term filter 搜索数据

要搜索数据,必须得先有数据,所以接下来会先把模拟数据创建出来

创建帖子数据

根据 用户ID、是否隐藏、帖子ID、发帖日期来搜索帖子

插入一些测试帖子数据

POST /forum/article/_bulk

{ "index": { "_id": 1 }}

{ "articleID" : "XHDK-A-1293-#fJ3", "userID" : 1, "hidden": false, "postDate": "2017-01-01" }

{ "index": { "_id": 2 }}

{ "articleID" : "KDKE-B-9947-#kL5", "userID" : 1, "hidden": false, "postDate": "2017-01-02" }

{ "index": { "_id": 3 }}

{ "articleID" : "JODL-X-1937-#pV7", "userID" : 2, "hidden": false, "postDate": "2017-01-01" }

{ "index": { "_id": 4 }}

{ "articleID" : "QQPX-R-3956-#aD8", "userID" : 2, "hidden": true, "postDate": "2017-01-02" }

初步来说,就先搞4个字段,因为整个 es 是支持 json document 格式的,所以说扩展性和灵活性非常之好。 如果后续随着业务需求的增加,要在 document 中增加更多的 field,那么我们可以很方便的随时添加field。

但是如果是在关系型数据库中,比如mysql,我们建立了一个表,现在要给表中新增一些 column,那就很坑爹了, 必须用复杂的修改表结构的语法去执行。而且可能对系统代码还有一定的影响。

查看 mappings

GET /forum/_mapping/article

响应

{

"forum": {

"mappings": {

"article": {

"properties": {

"articleID": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"hidden": {

"type": "boolean"

},

"postDate": {

"type": "date"

},

"userID": {

"type": "long"

}

}

}

}

}

}

articleID.keyword 解释

在 5.2 版本起,type = text,默认会设置两个 field:

- 原本的字段:articleID

-

不分词的字段:keyword

ignore_above:最多保留 256 个字符

可以通过

_analyze来检测

GET /forum/_analyze

{

"field": "articleID.keyword",

"text": "XHDK-A-1293-#fJ3"

}

响应

{

"error": {

"root_cause": [

{

"type": "remote_transport_exception",

"reason": "[sEvAlYx][127.0.0.1:9300][indices:admin/analyze[s]]"

}

],

"type": "illegal_argument_exception",

"reason": "Can't process field [articleID.keyword], Analysis requests are only supported on tokenized fields"

},

"status": 400

}

使用 term 搜索

term:对搜索文本不分词,直接拿去倒排索引中匹配,你输入的是什么,就去匹配什么

这里就是把数据过滤出来,也不需要相关分数,可以使用 constant_score

根据用户ID搜索帖子

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"term": {

"userID": 1

}

}

}

}

}

搜索没有隐藏的帖子

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"term": {

"hidden": false

}

}

}

}

}

根据发帖日期搜索帖子

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"term": {

"postDate": "2017-01-01"

}

}

}

}

}

根据帖子ID搜索帖子

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"term": {

"articleID": "JODL-X-1937-#pV7"

}

}

}

}

}

会发现什么都搜不到

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 0,

"max_score": null,

"hits": []

}

}

这是因为,该字段是分词字段。查看分词

查看分词

GET /forum/_analyze

{

"field": "articleID",

"text": "XHDK-A-1293-#fJ3"

}

响应

{

"tokens": [

{

"token": "xhdk",

"start_offset": 0,

"end_offset": 4,

"type": "<ALPHANUM>",

"position": 0

},

{

"token": "a",

"start_offset": 5,

"end_offset": 6,

"type": "<ALPHANUM>",

"position": 1

},

{

"token": "1293",

"start_offset": 7,

"end_offset": 11,

"type": "<NUM>",

"position": 2

},

{

"token": "fj3",

"start_offset": 13,

"end_offset": 16,

"type": "<ALPHANUM>",

"position": 3

}

]

}

可以看到在 articleID 存储中,已经是分词的了。所以我们使用 term 不分词的肯定是匹配不上的。

前面说了 text 字段会自动 mapping 一个 keyword 字段

articleID.keyword,是 es 最新版本内置建立的 field,就是不分词的。

所以一个 articleID 过来的时候,会建立两次索引,一次是自己本身,是要分词的,分词后放入倒排索引; 另外一次是基于 articleID.keyword,不分词,保留 256个 字符最多,直接一个字符串放入倒排索引中。

对于 text 类型的字段就可以考虑使用 filed.keyword 字段来搜索

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"term": {

"articleID.keyword": "JODL-X-1937-#pV7"

}

}

}

}

}

结果是出来了,但是还有个问题,默认就保留 256个 字符。 所以尽可能还是自己去手动建立索引,指定 not_analyzed 吧。在最新版本的es中,不需要指定 not_analyzed 也可以,将 type=keyword 即可。

索引重建

DELETE /forum

PUT /forum

{

"mappings": {

"article":{

"properties": {

"articleID":{

"type": "string",

"index": "not_analyzed"

}

}

}

}

}

::: tip 注意 type ,如果是 text,就算指定了 index=not_analyzed 也还是会分词的。 :::

如上面这样指定之后,再次查看 mapping ,会发现被优化成了 keyword

GET /forum/_mapping

响应

{

"forum": {

"mappings": {

"article": {

"properties": {

"articleID": {

"type": "keyword"

},

"hidden": {

"type": "boolean"

},

"postDate": {

"type": "date"

},

"userID": {

"type": "long"

}

}

}

}

}

}

所以在创建索引的时候就可以直接使用 keyword 类型

PUT /forum

{

"mappings": {

"article":{

"properties": {

"articleID":{

"type": "keyword"

}

}

}

}

}

插入测试数据之后再次搜索就可以了

知识总结

- term filter:根据 exact value 进行搜索,数字、boolean、date 天然支持

- text 需要建索引时指定为 not_analyzed,才能用 term query

-

相当于 SQL 中的单个 where 条件

select * from forum.article where articleID='XHDK-A-1293-#fJ3'filter 原理剖析

核心是 bitset,还有 caching 机制

1. 搜索数据,获取 document list

在倒排索引中查找搜索串,获取 document list

date 来举例

| word | doc1 | doc2 | doc3 |

|---|---|---|---|

| 2017-01-01 | * | * | |

| 2017-02-02 | * | * | |

| 2017-03-03 | * | * | * |

filter:2017-02-02

到倒排索引中一找,发现 2017-02-02 对应的 document list 是 doc2,doc3

2. 构建 bitset

为每个在倒排索引中搜索到的结果,构建一个 bitset,[0, 0, 0, 1, 0, 1]

使用找到的 doc list 构建一个 bitset:就是一个二进制的数组,数组每个元素都是 0 或 1, 用来标识一个 doc对一个 filter 条件是否匹配,如果匹配就是 1,不匹配就是 0

如 filter:2017-02-02 :[0, 1, 1]

- doc1:不匹配这个 filter 的

- doc2 和 do3:是匹配这个 filter 的

尽可能用简单的数据结构去实现复杂的功能,可以节省内存空间,提升性能

3. 遍历 bitset,查找满足条件的 documt

遍历每个过滤条件对应的 bitset,优先从最稀疏的开始搜索,查找满足所有条件的 document

后面会讲解,一次性其实可以在一个 search 请求中,发出多个 filter 条件,每个 filter 条件都会对应一个 bitset 遍历每个 filter 条件对应的 bitset,先从最稀疏的开始遍历

[0, 0, 0, 1, 0, 0]:比较稀疏,可以简单任务是 1 最少的

[0, 1, 0, 1, 0, 1]

先遍历比较稀疏的 bitset,就可以先过滤掉尽可能多的数据;遍历所有的 bitset,找到匹配所有 filter 条件的doc

比如请求:filter,postDate=2017-01-01,userID=1

postDate: [0, 0, 1, 1, 0, 0]

userID: [0, 1, 0, 1, 0, 1]

遍历完两个 bitset 之后,找到的匹配所有条件的 doc,就是 doc4 (都是 1)

就可以将document作为结果返回给client了

4. caching bitset

caching bitset:跟踪 query,在最近 256个 query 中超过一定次数的过滤条件,缓存其 bitset。对于小 segment(<1000,或<3%),不缓存 bitset。

比如 postDate=2017-01-01,[0, 0, 1, 1, 0, 0],可以缓存在内存中,

这样下次如果再有这个条件过来的时候,就不用重新扫描倒排索引,反复生成 bitset,可以大幅度提升性能。

在最近的 256 个 filter 中,有某个 filter 超过了一定的次数,次数不固定,就会自动缓存这个 filter 对应的 bitset

小 segment 不缓存

filter 针对小 segment 获取到的结果,可以不缓存,segment 记录数 <1000,或者 segment 大小 < index 总大小的 3%

因为:

- segment 数据量很小,此时哪怕是扫描也很快;

- segment 会在后台自动合并,小 segment 很快就会跟其他小 segment 合并成大 segment,此时就缓存也没有什么意义,segment 很快就消失了

filter 与 query 相比的好处

好处就是 filter 会 caching,但是之前不知道 caching 的是什么东西,实际上并不是一个 filter 返回的完整的 doc list 数据结果。 而是 filter bitset 缓存起来。下次不用扫描倒排索引了。

5. filter 大部分情况下会比 query 先执行

filter 大部分情况下来说,在 query 之前执行,先尽量过滤掉尽可能多的数据

- query:是会计算 doc 对搜索条件的 relevance score,还会根据这个 score 去排序

- filter:只是简单过滤出想要的数据,不计算 relevance score,也不排序

::: tip 之前我一直以为 filter 是在 query 中条件查找之后,在结果上进行单纯的过滤操作。 现在看来并不是这样 :::

6. 有修改或者更新,cached bitset 自动更新

如果 document 新增或修改,那么 cached bitset 会被自动更新

postDate=2017-01-01,[0, 0, 1, 0]

document,id=5,postDate=2017-01-01,会自动更新到 postDate=2017-01-01 这个 filter 的 bitset 中,全自动,缓存会自动更新。postDate=2017-01-01的bitset,[0, 0, 1, 0, 1]

document,id=1,postDate=2016-12-30,修改为 postDate-2017-01-01,此时也会自动更新 bitset,[1, 0, 1, 0, 1]

以后只要是有相同的 filter 条件的,会直接来使用这个过滤条件对应的 cached bitset

bool 组合多个 filter 搜索

第一个例子

需求如下:

- 搜索发帖日期为 2017-01-01 或者帖子 ID 为 XHDK-A-1293-#fJ3 的帖子

- 同时要求帖子的发帖日期绝对不为 2017-01-02

用 sql 来表示大致是这样

select * from forum.article

where (post_date='2017-01-01' or article_id='XHDK-A-1293-#fJ3')

and post_date!='2017-01-02'

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"bool": {

"should":[

{"term":{"postDate":"2017-01-01"}},

{"term":{"articleID":"XHDK-A-1293-#fJ3"}}

],

"must_not":{

"term":{

"postDate":"2017-01-02"

}

}

}

}

}

}

}

::: tip 这个语法提示在 kibana 中没有提示的!!! :::

第二个例子

- 搜索帖子 ID 为 XHDK-A-1293-#fJ3

- 或者帖子 ID 为 JODL-X-1937-#pV7 而且发帖日期为 2017-01-01 的帖子

select * from forum.article

where article_id='XHDK-A-1293-#fJ3'

or (article_id='JODL-X-1937-#pV7' and post_date='2017-01-01')

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"bool": {

"should":[

{"term":{"articleID":"XHDK-A-1293-#fJ3"}},

{"bool":{

"must":[

{"term":{"articleID":"JODL-X-1937-#pV7"}},

{"term":{"postDate":"2017-01-01"}}

]

}

}

]

}

}

}

}

}

总结

- bool:must,must_not,should,组合多个过滤条件

- bool 可以嵌套

- 相当于 SQL 中的多个 and 条件:当你把搜索语法学好了以后,基本可以实现部分常用的 sql 语法对应的功能

::: tip 好多语法提示在 kibana 中没有提示的!!!,重要的事情多说几遍,以前一直以为没有提示就是不支持 :::

terms 搜索多个值

之前都是使用 term 搜索一个词,那么怎么实现 sql 中的 in 效果呢?

select * from tbl where col in ("value1", "value2")

就可以使用 terms

terms: {"field": ["value1", "value2"]}

为帖子数据增加 tag 字段;增加模拟数据

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"tag" : ["java", "hadoop"]} }

{ "update": { "_id": "2"} }

{ "doc" : {"tag" : ["java"]} }

{ "update": { "_id": "3"} }

{ "doc" : {"tag" : ["hadoop"]} }

{ "update": { "_id": "4"} }

{ "doc" : {"tag" : ["java", "elasticsearch"]} }

搜索 articleID 为 KDKE-B-9947-#kL5 或 QQPX-R-3956-#aD8的帖子

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"terms": {

"articleID": [

"KDKE-B-9947-#kL5",

"QQPX-R-3956-#aD8"

]

}

}

}

}

}

搜索 tag 中包含 java 的帖子

由于这里只有一个条件,所以使用 term ,而不是 terms

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"term": {

"tag": "java"

}

}

}

}

}

响应结果

{

"took": 1,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": 1,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "2",

"_score": 1,

"_source": {

"articleID": "KDKE-B-9947-#kL5",

"userID": 1,

"hidden": false,

"postDate": "2017-01-02",

"tag": [

"java"

]

}

},

{

"_index": "forum",

"_type": "article",

"_id": "4",

"_score": 1,

"_source": {

"articleID": "QQPX-R-3956-#aD8",

"userID": 2,

"hidden": true,

"postDate": "2017-01-02",

"tag": [

"java",

"elasticsearch"

]

}

},

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 1,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

]

}

}

]

}

}

可见如上结果,tag 中包含 java 的都出来了,那么如果只包含 java 的呢?

搜索 tag 只包含 java 的帖子

该需求在目前的知识中貌似实现不了呢,可以通过一个标识字段来实现。

标识当前 tag 中 tag 的数量,只要为 1 的且又包含 java 的就可以了

增加 tag 数量字段

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"tag_cnt" : 2} }

{ "update": { "_id": "2"} }

{ "doc" : {"tag_cnt" : 1} }

{ "update": { "_id": "3"} }

{ "doc" : {"tag_cnt" : 1} }

{ "update": { "_id": "4"} }

{ "doc" : {"tag_cnt" : 2} }

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"bool": {

"must":[

{"term":{

"tag":"java"

}},

{

"match": {

"tag_cnt": 1

}

}

]

}

}

}

}

}

查找 tag 中只包含 java 和 hadoop 的数据

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"bool": {

"must":[

{"term":{

"tag":"java"

}},

{"term":{

"tag":"hadoop"

}},

{

"match": {

"tag_cnt": 2

}

}

]

}

}

}

}

}

- 使用 must + 2个 term 限制至少该数据包含 java 和 hadoop

- 并且他们的数量只能为 2

响应

{

"took": 1,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 1,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 1,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

],

"tag_cnt": 2

}

}

]

}

}

总结

- terms 多值搜索

- 优化 terms 多值搜索的结果

- 相当于 SQL 中的 in 语句

range filter 范围过滤

为帖子增加浏览量的字段数据

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"view_cnt" : 30} }

{ "update": { "_id": "2"} }

{ "doc" : {"view_cnt" : 50} }

{ "update": { "_id": "3"} }

{ "doc" : {"view_cnt" : 100} }

{ "update": { "_id": "4"} }

{ "doc" : {"view_cnt" : 80} }

数值范围查询

搜索浏览量在 30~60 之间的帖子

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"range": {

"view_cnt": {

"gte": 30,

"lte": 60

}

}

}

}

}

}

- gt:大于

- lt:小于

- gte:大于等于

- lte:小于等于

日期范围查询

搜索发帖日期在最近 1个月 的帖子

由于该笔记是 2019.01.28 记录的,需要添加一条记录

POST /forum/article/_bulk

{ "index": { "_id": 5 }}

{ "articleID" : "DHJK-B-1395-#Ky5", "userID" : 3, "hidden": false, "postDate": "2019-01-28", "tag": ["elasticsearch"], "tag_cnt": 1, "view_cnt": 10 }

最近一个月:也就是当前时间 - 30天,大于该时间即可

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"range": {

"postDate": {

"gte": "2018-01-01"

}

}

}

}

}

}

上面这个时间是我们自己算的,es 支持动态语法

- now-30d:当前时间减去 30天

-

2019-01-30 -2d:下面例子来说 gte: 大于 2019.01.30 或者是大于 2019.01.30 -2 天 = 2019.01.28

GET /forum/article/_search

{

"query": {

"constant_score": {

"filter": {

"range": {

"postDate": {

"gte": "2019-01-30||-2d"

}

}

}

}

}

}

总结

- range,sql 中的 between,或者是 >=1,<=1

- range 做范围过滤

体验如何控制全文检索结果的精准度

增加测试数据,添加一个 title 字段

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"title" : "this is java and elasticsearch blog"} }

{ "update": { "_id": "2"} }

{ "doc" : {"title" : "this is java blog"} }

{ "update": { "_id": "3"} }

{ "doc" : {"title" : "this is elasticsearch blog"} }

{ "update": { "_id": "4"} }

{ "doc" : {"title" : "this is java, elasticsearch, hadoop blog"} }

{ "update": { "_id": "5"} }

{ "doc" : {"title" : "this is spark blog"} }

1、搜索标题中包含 java 或 elasticsearch 的 blog

- term query: 搜索 exact value

-

match query:full text 全文检索

如果要检索的 field,是 not_analyzed 类型的,那么 match query 也相当于 term query。

GET /forum/article/_search

{

"query": {

"match": {

"title": "java elasticsearch"

}

}

}

会出来 4 条数据。

2、搜索标题中包含 java 和 elasticsearch 的 blog

GET /forum/article/_search

{

"query": {

"match": {

"title": {

"query": "java elasticsearch",

"operator": "and"

}

}

}

}

搜索的结果是包含 java 和 elasticsearch 两个关键词的结果,并不是 term query 的精准匹配

3、搜索包含 java、elasticsearch、spark、hadoop 4 个关键字中,至少 3 个的 blog

GET /forum/article/_search

{

"query": {

"match": {

"title": {

"query": "java elasticsearch spark hadoop",

"minimum_should_match": "75%"

}

}

}

}

minimum_should_match:必须至少匹配其中的多少个关键字,才能作为结果返回,默认是一个

4、用 bool 组合多个搜索条件,来搜索 title

GET /forum/article/_search

{

"query": {

"bool": {

"must": { "match": { "title": "java" }},

"must_not": { "match": { "title": "spark" }},

"should": [

{ "match": { "title": "hadoop" }},

{ "match": { "title": "elasticsearch" }}

]

}

}

}

再来解说下这个:必须包含 java,且不能包含 spark,且可以包含或者不包含 hadoop 和 elasticsearch;

这里的 should 这样用我觉得没有什么必要,那有什么用么?下面会讲解相关作用

5、bool 组合多个搜索条件,如何计算 relevance score

must 和 should 搜索对应的分数,加起来,除以 must 和 should 的总数

- 排名第一:java,同时包含 should 中所有的关键字,hadoop,elasticsearch

- 排名第二:java,同时包含 should 中的 elasticsearch

- 排名第三:java,不包含 should 中的任何关键字

should 是可以影响相关度分数的

must 是确保说,谁必须有这个关键字,同时会根据这个 must 的条件去计算出 document 对这个搜索条件的 relevance score

在满足 must 的基础之上,should 中的条件,不匹配也可以,但是如果匹配的更多,那么 document 的 relevance score 就会更高

看下面的结果排名,对照上面的就清楚了

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "4",

"_score": 1.3375794,

"_source": {

"articleID": "QQPX-R-3956-#aD8",

"userID": 2,

"hidden": true,

"postDate": "2017-01-02",

"tag": [

"java",

"elasticsearch"

],

"tag_cnt": 2,

"view_cnt": 80,

"title": "this is java, elasticsearch, hadoop blog"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 0.53484553,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

],

"tag_cnt": 2,

"view_cnt": 30,

"title": "this is java and elasticsearch blog"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "2",

"_score": 0.19856805,

"_source": {

"articleID": "KDKE-B-9947-#kL5",

"userID": 1,

"hidden": false,

"postDate": "2017-01-02",

"tag": [

"java"

],

"tag_cnt": 1,

"view_cnt": 50,

"title": "this is java blog"

}

}

]

6、搜索 java、hadoop、spark、elasticsearch,至少包含其中 3 个关键字

至少满足 should 中的 3个条件才返回结果

GET /forum/article/_search

{

"query": {

"bool": {

"should": [

{ "match": { "title": "java" }},

{ "match": { "title": "elasticsearch" }},

{ "match": { "title": "hadoop" }},

{ "match": { "title": "spark" }}

],

"minimum_should_match": 3

}

}

}

总结

-

全文检索的时候,进行多个值的检索,有两种做法,

- match query

- should

-

控制搜索结果精准度:

- operator and

- minimum_should_match

多关键词底层原理 term + bool

普通 match 如何转换为 term + should?

{

"match": { "title": "java elasticsearch"}

}

使用诸如上面的 match query 进行多值搜索的时候,es 会在底层自动将这个 match query 转换为 bool 的语法 bool should,指定多个搜索词,同时使用 term query

{

"bool": {

"should": [

{ "term": { "title": "java" }},

{ "term": { "title": "elasticsearch"}}

]

}

}

and match 如何转换为 term + must?

{

"match": {

"title": {

"query": "java elasticsearch",

"operator": "and"

}

}

}

转换为

{

"bool": {

"must": [

{ "term": { "title": "java" }},

{ "term": { "title": "elasticsearch" }}

]

}

}

minimum_should_match 如何转换

{

"match": {

"title": {

"query": "java elasticsearch hadoop spark",

"minimum_should_match": "75%"

}

}

}

转换为

{

"bool": {

"should": [

{ "term": { "title": "java" }},

{ "term": { "title": "elasticsearch" }},

{ "term": { "title": "hadoop" }},

{ "term": { "title": "spark" }}

],

"minimum_should_match": 3

}

}

上一讲,为啥要讲解两种实现 multi-value 搜索的方式呢?实际上,就是给这一讲进行铺垫的。match query –> bool + term。

权重控制 boost

权重是什么意思呢?简单来说就是用数值来给「重要」量化

比如这个需求:

- 搜索标题中包含 java 的帖子

- 同时呢,如果标题中包含 hadoop 或 elasticsearch 就优先搜索出来,

- 同时呢,如果一个帖子包含 java hadoop,一个帖子包含 java elasticsearch,包含 hadoop 的帖子要比 elasticsearch 优先搜索出来

知识点:boost 搜索条件的权重,可以将某个搜索条件的权重加大,此时当匹配这个搜索条件和匹配另一个搜索条件的 document, 计算 relevance score 时,匹配权重更大的搜索条件的 document,relevance score 会更高,当然也就会优先被返回回来

默认情况下,搜索条件的权重都是一样的,都是 1

比如下面这个查询,前面讲到过 should 的的得分计算, 如果 spark 的 boost=1 那么 “title”: “this is java, elasticsearch, hadoop blog” 肯定是得分最高的, 因为满足个数最多。

下面这个查询结果由于 spark 的 boost=5,最高得分就是 “title”: “this is spark blog” 了,

::: tip 得分有相关的计算,权重只是提高了这个分支,可以理解为最终得分再多加这个权重分,而不是直接手动排序 :::

GET /forum/article/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"title": "blog"

}

}

],

"should": [

{

"match": {

"title": {

"query": "java"

}

}

},

{

"match": {

"title": {

"query": "hadoop"

}

}

},

{

"match": {

"title": {

"query": "elasticsearch"

}

}

},

{

"match": {

"title": {

"query": "spark",

"boost": 5

}

}

}

]

}

}

}

多 shard 下评分不准确大揭秘

得分不准的产生

1 个 index 有多个 shard(副本)的情况下,有时会导致 relevance score 不准确的情况;

那么这个情况是怎么产生的呢?es 官网自己说该得分计算是有一点问题的(不知道哪里写的),

在 相关度评分 TF&IDF 算法独家解密 中有讲到过得分的计算规则。# dis_max 实现 best fields 策略多字段搜索

增加 content 字段的测试数据

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"content" : "i like to write best elasticsearch article"} }

{ "update": { "_id": "2"} }

{ "doc" : {"content" : "i think java is the best programming language"} }

{ "update": { "_id": "3"} }

{ "doc" : {"content" : "i am only an elasticsearch beginner"} }

{ "update": { "_id": "4"} }

{ "doc" : {"content" : "elasticsearch and hadoop are all very good solution, i am a beginner"} }

{ "update": { "_id": "5"} }

{ "doc" : {"content" : "spark is best big data solution based on scala ,an programming language similar to java"} }

问题产生

搜索 title 或 content 中包含 java 或 solution 的帖子

GET /forum/article/_search

{

"query": {

"bool": {

"should": [

{"match": {

"title": "java solution"

}},

{

"match": {

"content": "java solution"

}

}

]

}

}

}

获取其中两条数据来分析下为什么会这样? 下面两条数据比较好描述

id 5 的 doc 中 content 包含了 solution 和 java,而 id 4 中只包含一个词语,应该是 id 5 得分高才对吧?

id=4,得分 0.7120095

"title": "this is java, elasticsearch, hadoop blog",

"content": "elasticsearch and hadoop are all very good solution, i am a beginner"

id=5,得分 0.56008905

"title": "this is spark blog",

"content": "spark is best big data solution based on scala ,an programming language similar to java"

这个就关系到 es 中的 should 得分计算规则有关系了。 大体的公式可以理解为这样:每个 query 得分相加 * matched query 数量 / 总 query 数量。

如 id 4 :

- title 中包含 java ; matched query 有得分,假设是 1.1

- content 中包含 solution;matched query 有得分,假设是 1.2

- matched query 数量:就是有得分的 query 数量,这里为 2

- 总 query 数量:should 中的 query 个数,这里为 2

(1.1 + 1.2) * 2 / 2 = 2.3

id 4:

- title :没有得分

- content 中包含 solution 和 java 有得分,假设是 2.3

- matched query 数量:就是有得分的 query 数量,这里为 1

- 总 query 数量:should 中的 query 个数,这里为 2

2.3 * 1 / 2 = 1.5

这里就看出来了,id 5 得分变低了

best fields 策略 和 dis_max

- best fields 策略:某一个 field 中匹配到了尽可能多的关键词,得分就高

- dis_max 语法:直接取多个 query 中,分数最高的那一个 query 的分数即可

有这两项保证,就能得到我们想要的结果了

GET /forum/article/_search

{

"query": {

"dis_max": {

"queries": [

{"match": {

"title": "java solution"

}},

{

"match": {

"content": "java solution"

}

}

]

}

}

}

dis_max 的 tie_breaker 作用

GET /forum/article/_search

{

"query": {

"dis_max": {

"queries": [

{ "match": { "title": "java beginner" }},

{ "match": { "body": "java beginner" }}

],

"tie_breaker": 0.3

}

}

}

用法如上,那么 tie_breaker 有什么作用呢?

如果你仔细观察使用 tie_breaker 和不使用查询出来的某一条数据的 _score 分数就能看出来了,

添加了之后会相应的提高。

dis_max 就是获取得分最高的那一个 query,这样就一刀切了,在某些情况下就会导致结果不是正确的;

- title 中包含 java ; matched query 有得分,假设是 1.1

- content 中包含 solution;matched query 有得分,假设是 1.2

添加了 tie_breaker = 0.3,那么就是这样的了, 1.1 * 0.3 + 1.2 = 1.53;

大于 dis_max 获取最高一条得分的 1.2,这样一来关联性就会上去了,也就会更合理一点

multi_match 语法

例如这样一个查询,使用 dis_max 语法的

GET /forum/article/_search

{

"query": {

"dis_max": {

"queries": [

{

"match": {

"title": {

"query": "java beginner",

"minimum_should_match": "50%",

"boost": 2

}

}

},

{

"match": {

"content": {

"query": "java beginner",

"minimum_should_match": "30%"

}

}

}

],

"tie_breaker": 0.3

}

}

}

- dis_max:获取得分最高的一个 query 作为最终得分

- tie_breaker:综合其他 query 得分,也可以理解为一点权重的意思吧

- boost:权重

-

minimum_should_match:去长尾

什么意思呢?举个例子,查询 「java is good bee」,但是某些结果可能只包含了一个 java 这样一来关联性就很低了,设置必须满足一定的个数才算匹配该条件,这个就是去长尾

上面这个可以使用 multi_match 语法来转化

GET /forum/article/_search

{

"query": {

"multi_match": {

"query": "java beginner",

"type": "best_fields",

"fields": [ "title^2", "content" ],

"tie_breaker": 0.3,

"minimum_should_match": "50%"

}

}

}

title^2:来表示 bootsmulti_match 的 most_fiels 策略

- most-fiels: 在多个 field 查询到关键词的则优先返回该 doc

- best_fields:在一个 field 中匹配到多个查询词的则优先返回该 doc

他们两个是刚好相反的一个策略

现在来实验,首先添加测试数据

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"sub_title" : "learning more courses"} }

{ "update": { "_id": "2"} }

{ "doc" : {"sub_title" : "learned a lot of course"} }

{ "update": { "_id": "3"} }

{ "doc" : {"sub_title" : "we have a lot of fun"} }

{ "update": { "_id": "4"} }

{ "doc" : {"sub_title" : "both of them are good"} }

{ "update": { "_id": "5"} }

{ "doc" : {"sub_title" : "haha, hello world"} }

GET /forum/article/_search

{

"query": {

"match": {

"sub_title": "learning courses"

}

}

}

这个查询出来的结果我们希望是 id=1 的数据会排在最前面,因为最相关。但是使用默认的 mapping 就不一定

原理就是:sub_title 会自动 mapping 成 enligsh analyzer,所以还原了单词

为什么,因为如果我们用的是类似于 english analyzer 这种分词器的话,就会将单词还原为其最基本的形态(stemmer)

learning --> learn

learned --> learn

courses --> course

sub_titile: learning coureses --> learn course

这样转换后再查询,相关分就和我们想象的不太一样了。所以先处理该差异,手动 mapping

POST /forum/_mapping/article

{

"properties": {

"sub_title": {

"type": "string",

"analyzer": "english",

"fields": {

"std": {

"type": "string",

"analyzer": "standard"

}

}

}

}

}

再次查询

GET /forum/article/_search

{

"query": {

"match": {

"sub_title.std": "learning courses"

}

}

}

就只会返回一条了,因为只有这一条符合标准

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 0.5063205,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 0.5063205,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

],

"tag_cnt": 2,

"view_cnt": 30,

"title": "this is java and elasticsearch blog",

"content": "i like to write best elasticsearch article",

"sub_title": "learning more courses"

}

}

]

}

}

如果不使用 .std 就会使用分词形式去匹配到两条数据。multi_match 语法如下

GET /forum/article/_search

{

"query": {

"multi_match": {

"query": "learning courses",

"type": "most_fields",

"fields": [ "sub_title", "sub_title.std" ]

}

}

}

响应结果

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 2,

"max_score": 1.219939,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "2",

"_score": 1.219939,

"_source": {

"articleID": "KDKE-B-9947-#kL5",

"userID": 1,

"hidden": false,

"postDate": "2017-01-02",

"tag": [

"java"

],

"tag_cnt": 1,

"view_cnt": 50,

"title": "this is java blog",

"content": "i think java is the best programming language",

"sub_title": "learned a lot of course"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 1.012641,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

],

"tag_cnt": 2,

"view_cnt": 30,

"title": "this is java and elasticsearch blog",

"content": "i like to write best elasticsearch article",

"sub_title": "learning more courses"

}

}

]

}

}

但是这还是没有出现我们希望的结果是为什么呢?这个老师也讲解不清楚了,计算很复杂;但是有一点可以知道, 使用 best_fields 和 most_fields 查看对于 id=1 的评分, 在 most_fields 策略下 评分达到了 1+ ,而 best_fields 策略下只有 0.5+;

这就可以说明 most_fields 策略的作用了

GET /forum/article/_search

{

"query": {

"multi_match": {

"query": "learning courses",

"type": "best_fields",

"fields": [ "sub_title", "sub_title.std" ]

}

}

}

most_fields 策略 cross-fields 搜索弊端

cross-fields (跨字段)搜索:一个唯一标识,跨了多个 field。比如一个人,标识,是姓名; 一个建筑,它的标识是地址。姓名可以散落在多个 field 中,比如 first_name 和 last_name 中, 地址可以散落在 country、province、city中。

跨多个 field 搜索一个标识,比如搜索一个人名,或者一个地址,就是 cross-fields 搜索

初步来说,如果要实现,可能用 most_fields 比较合适。因为 best_fields 是优先搜索单个 field 最匹配的结果, cross-fields 本身就不是一个 field 的问题了。

增加字段数据

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"author_first_name" : "Peter", "author_last_name" : "Smith"} }

{ "update": { "_id": "2"} }

{ "doc" : {"author_first_name" : "Smith", "author_last_name" : "Williams"} }

{ "update": { "_id": "3"} }

{ "doc" : {"author_first_name" : "Jack", "author_last_name" : "Ma"} }

{ "update": { "_id": "4"} }

{ "doc" : {"author_first_name" : "Robbin", "author_last_name" : "Li"} }

{ "update": { "_id": "5"} }

{ "doc" : {"author_first_name" : "Tonny", "author_last_name" : "Peter Smith"} }

查询

GET /forum/article/_search

{

"query": {

"multi_match": {

"query": "Peter Smith",

"type": "most_fields",

"fields": [ "author_first_name", "author_last_name" ]

}

}

}

响应结果

{

"took": 118,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": 0.6931472,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "2",

"_score": 0.6931472,

"_source": {

"articleID": "KDKE-B-9947-#kL5",

"userID": 1,

"hidden": false,

"postDate": "2017-01-02",

"tag": [

"java"

],

"tag_cnt": 1,

"view_cnt": 50,

"title": "this is java blog",

"content": "i think java is the best programming language",

"sub_title": "learned a lot of course",

"author_first_name": "Smith",

"author_last_name": "Williams"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 0.5753642,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

],

"tag_cnt": 2,

"view_cnt": 30,

"title": "this is java and elasticsearch blog",

"content": "i like to write best elasticsearch article",

"sub_title": "learning more courses",

"author_first_name": "Peter",

"author_last_name": "Smith"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "5",

"_score": 0.51623213,

"_source": {

"articleID": "DHJK-B-1395-#Ky5",

"userID": 3,

"hidden": false,

"postDate": "2019-01-28",

"tag": [

"elasticsearch"

],

"tag_cnt": 1,

"view_cnt": 10,

"title": "this is spark blog",

"content": "spark is best big data solution based on scala ,an programming language similar to java",

"sub_title": "haha, hello world",

"author_first_name": "Tonny",

"author_last_name": "Peter Smith"

}

}

]

}

}

会发现 id=5 的 "author_last_name": "Peter Smith" 居然是排在最后面的,

我们想要的结果应该就是 id=5 这条数据了,造成这个结果的原因如下:

- 只是找到尽可能多的 field 匹配的 doc,而不是某个 field 完全匹配的 doc

- most_fields 没办法用 minimum_should_match 去掉长尾数据,就是匹配的特别少的结果

-

TF/IDF算法,

比如 Peter Smith 和 Smith Williams,搜索 Peter Smith 的时候,由于 first_name 中很少有 Smith 的, 所以 query 在所有 document 中的频率很低,得到的分数很高,可能 Smith Williams 反而会排在 Peter Smith 前面

注意:该算法在本教程中有时候的解释并不是完全正确,只大概是这样

copy_to 解决 cross-fields

上一节使用 most_fields 来解决多字段搜索的需求的弊端中最最核心的问题就是有跨字段搜索了, 那么这里就可以使用 copy_to 来让多个字段组合成一个字段

需要先 mapping ,这里新增加字段

PUT /forum/_mapping/article

{

"properties": {

"new_author_first_name": {

"type": "string",

"copy_to": "new_author_full_name"

},

"new_author_last_name": {

"type": "string",

"copy_to": "new_author_full_name"

},

"new_author_full_name": {

"type": "string"

}

}

}

再增加数据

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"new_author_first_name" : "Peter", "new_author_last_name" : "Smith"} }

{ "update": { "_id": "2"} }

{ "doc" : {"new_author_first_name" : "Smith", "new_author_last_name" : "Williams"} }

{ "update": { "_id": "3"} }

{ "doc" : {"new_author_first_name" : "Jack", "new_author_last_name" : "Ma"} }

{ "update": { "_id": "4"} }

{ "doc" : {"new_author_first_name" : "Robbin", "new_author_last_name" : "Li"} }

{ "update": { "_id": "5"} }

{ "doc" : {"new_author_first_name" : "Tonny", "new_author_last_name" : "Peter Smith"} }

注意:在查询的时候 new_author_full_name 字段并不会显示出来,在查询 mapping 的时候才能看到

::: warning 该章节示例的测试不能解决我们的需求,因为该打分的的策略没有彻底搞明白的缘故。所以复现不出来了 :::

这几章节的内容其实就是讲解了什么场景下使用:best_fields、most_fields

cross-fields

在 multi_match 中就已经支持了 cross_fields

GET /forum/article/_search

{

"query": {

"multi_match": {

"query": "Peter Smith",

"type": "cross_fields",

"operator": "and",

"fields": ["author_first_name", "author_last_name"]

}

}

}

响应结果

{

"took": 7,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 2,

"max_score": 0.5753642,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "1",

"_score": 0.5753642,

"_source": {

"articleID": "XHDK-A-1293-#fJ3",

"userID": 1,

"hidden": false,

"postDate": "2017-01-01",

"tag": [

"java",

"hadoop"

],

"tag_cnt": 2,

"view_cnt": 30,

"title": "this is java and elasticsearch blog",

"content": "i like to write best elasticsearch article",

"sub_title": "learning more courses",

"author_first_name": "Peter",

"author_last_name": "Smith",

"new_author_last_name": "Smith",

"new_author_first_name": "Peter"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "5",

"_score": 0.51623213,

"_source": {

"articleID": "DHJK-B-1395-#Ky5",

"userID": 3,

"hidden": false,

"postDate": "2019-01-28",

"tag": [

"elasticsearch"

],

"tag_cnt": 1,

"view_cnt": 10,

"title": "this is spark blog",

"content": "spark is best big data solution based on scala ,an programming language similar to java",

"sub_title": "haha, hello world",

"author_first_name": "Tonny",

"author_last_name": "Peter Smith",

"new_author_last_name": "Peter Smith",

"new_author_first_name": "Tonny"

}

}

]

}

}

和最开始说想要 id=5 的数据还是没能达到要求,但是现在的结果已经很正常了。 无论是单独还是组合都出现了 Peter Smith,其他的还是评分缘故

match_phrase 短语匹配

什么是短语匹配和近似匹配?

先来看一个搜索例子

添加两条数据

PUT /forum/article/6

{

"content":"java is my favourite programming language, and I also think spark is a very good big data system."

}

PUT /forum/article/7

{

"content":"java spark are very related, because scala is spark's programming language and scala is also based on jvm like java."

}

PUT /forum/article/8

{

"content":"java are spark very related, because scala is spark's programming language and scala is also based on jvm like java."

}

查询

GET /forum/article/_search

{

"query": {

"match": {

"content": "java spark"

}

}

}

}

会看到这三条数据都返回来了,并且 id=7 的得分要高于 id=6 的。

假如要实现下面需求:

- java spark,就靠在一起,中间不能插入任何其他字符,就要搜索出来这种 doc

- java spark,但是要求,java 和 spark 两个单词靠的越近,doc 的分数越高,排名越靠前

使用 match 是搞不定的,match 只能搜索到包含 java 和 spark 的数据(因为会分词成两个词)

近似匹配包括以下两类,短语匹配也属于近似匹配,后续会看到(如 slop)

- phrase match 短语匹配:就是不分词,直接包含这个词的

- proximity match 近似匹配:靠得越近得分越高

phrase match

GET /forum/article/_search

{

"query": {

"match_phrase": {

"content": "java spark"

}

}

}

}

成功了,只有包含 java spark 这个短语的 doc 才返回了,只包含 java 的 doc 不会返回

term position

什么是 term position?简单说就是分词后的词在原始 doc 中的顺序位置

通过下面的的语法可以查看到分词后的 position

GET _analyze

{

"text": "hello world, java spark",

"analyzer": "standard"

}

GET _analyze

{

"text": "hi, spark java",

"analyzer": "standard"

}

其中一个返回

{

"tokens": [

{

"token": "hello",

"start_offset": 0,

"end_offset": 5,

"type": "<ALPHANUM>",

"position": 0

},

{

"token": "world",

"start_offset": 6,

"end_offset": 11,

"type": "<ALPHANUM>",

"position": 1

},

{

"token": "java",

"start_offset": 13,

"end_offset": 17,

"type": "<ALPHANUM>",

"position": 2

},

{

"token": "spark",

"start_offset": 18,

"end_offset": 23,

"type": "<ALPHANUM>",

"position": 3

}

]

}

phrase match 基本原理

倒排索引中的 position 示例

hello world, java spark doc1

hi, spark java doc2

--- 倒排索引示例,

hello doc1(0)

wolrd doc1(1)

java doc1(2) doc2(2)

spark doc1(3) doc2(1)

java spark --> java 和 spark

match phrase 要求 doc 必须包含所有的关键词才符合第一步条件

--- 查询词在 doc 中的 position 示例

java --> doc1(2) doc2(2)

spark --> doc1(3) doc2(1)

对于 match phrase 来说,spark 的 position > java 的 position 且必须大于 1 才能满足条件。因为刚好大于 1 的话,就能拼接成 java spark。

通过 position 的对比就能判定这个搜索是否是一个短语

这样看来,后面的 proximity match 原理也应该是这样!

match_phrase 的 slop

语法

GET /forum/article/_search

{

"query": {

"match_phrase": {

"content": {

"query": "java spark",

"slop": 1

}

}

}

}

slop 的含义是什么?

query string 搜索文本中的几个 term,要经过几次移动才能与一个 document 匹配,这个移动的次数,就是 slop

举个例子:

这样一段文本:hello world, java is very good, spark is also very good.

使用 match_phrase 搜索 java spark 搜不到

如果我们指定了slop,那么就允许 java spark 进行移动,来尝试与 doc 进行匹配

java is very good spark is

java spark

java --> spark

java --> spark

java --> spark

上面展示了,当固定第一个 term 的时候,后面的 teram 经过移动直到匹配上搜索词的经过

这个移动的次数就是 slop

::: tip slop 只指最大移动次数 :::

验证 slop

GET /forum/article/_search

{

"query": {

"match_phrase": {

"content": {

"query": "java spark",

"slop": 2

}

}

}

}

响应结果

{

"took": 1,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 2,

"max_score": 1.1324264,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "7",

"_score": 1.1324264,

"_source": {

"content": "java spark are very related, because scala is spark's programming language and scala is also based on jvm like java."

}

},

{

"_index": "forum",

"_type": "article",

"_id": "8",

"_score": 0.21395226,

"_source": {

"content": "java are spark very related, because scala is spark's programming language and scala is also based on jvm like java."

}

}

]

}

}

尝试着把 slop 的数值调整大一点,之前有好多条数据中都包含了 java 和 spark, 你会发现靠得越近的(slop 相对小的)得分会越高

其实,加了 slop 的 phrase match,就是 proximity match(近似匹配)

- java spark,短语,doc,phrase match

- java spark,可以有一定的距离,但是靠的越近,越先搜索出来,proximity match

混合使用 match 和近似匹配实现召回率与精准度的平衡

什么是召回率与精准度

-

召回率

比如你搜索一个 java spark,总共有 100 个 doc,能返回多少个 doc作为结果,就是召回率(recall)

-

精准度

比如你搜索一个 java spark,能不能尽可能让包含 java spark 或者是 java 和 spark 离的很近的 doc, 排在最前面,这个就是精准度(precision)

直接用 match_phrase 短语搜索(包括 proximity match),会导致必须所有 term 都在 doc field 中出现, 而且距离在 slop 限定范围内,才能匹配上,如果某一个 doc 可能就是有某个 term 没有包含,那么就无法作为结果返回

如:

java spark --> hello world java --> 就不能返回了

java spark --> hello world, java spark --> 才可以返回

近似匹配的时候,召回率比较低,精准度太高了。

那么怎么才能达到:召回率高,精准度高的排在最前面呢? 也就是说希望上面两条数据都返回,但是第二条排在前面

这里就可以混合使用 match 与近似匹配来达到这个效果

混合使用 match 与近似匹配

GET /forum/article/_search

{

"query": {

"bool": {

"must": [

{"match": {

"content": "java spark"

}}

],

"should": [

{"match_phrase": {

"content": {

"query": "java spark",

"slop": 50

}

}}

]

}

}

}

响应结果

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 5,

"max_score": 2.5593896,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "7",

"_score": 2.5593896,

"_source": {

"content": "java spark are very related, because scala is spark's programming language and scala is also based on jvm like java."

}

},

{

"_index": "forum",

"_type": "article",

"_id": "6",

"_score": 1.3154804,

"_source": {

"content": "java is my favourite programming language, and I also think spark is a very good big data system."

}

},

{

"_index": "forum",

"_type": "article",

"_id": "8",

"_score": 0.63663185,

"_source": {

"content": "java are spark very related, because scala is spark's programming language and scala is also based on jvm like java."

}

},

{

"_index": "forum",

"_type": "article",

"_id": "2",

"_score": 0.5099718,

"_source": {

"articleID": "KDKE-B-9947-#kL5",

"userID": 1,

"hidden": false,

"postDate": "2017-01-02",

"tag": [

"java"

],

"tag_cnt": 1,

"view_cnt": 50,

"title": "this is java blog",

"content": "i think java is the best programming language",

"sub_title": "learned a lot of course",

"author_first_name": "Smith",

"author_last_name": "Williams",

"new_author_last_name": "Williams",

"new_author_first_name": "Smith"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "5",

"_score": 0.42019215,

"_source": {

"articleID": "DHJK-B-1395-#Ky5",

"userID": 3,

"hidden": false,

"postDate": "2019-01-28",

"tag": [

"elasticsearch"

],

"tag_cnt": 1,

"view_cnt": 10,

"title": "this is spark blog",

"content": "spark is best big data solution based on scala ,an programming language similar to java",

"sub_title": "haha, hello world",

"author_first_name": "Tonny",

"author_last_name": "Peter Smith",

"new_author_last_name": "Peter Smith",

"new_author_first_name": "Tonny"

}

}

]

}

}

可以看到匹配上的都排在前面了,如果不使用 slop , id=2 的(只包含了 java) 会比部分都包含的 doc 得分高

-

match:提高了召回率

只要包含了 java 或者 spark 其中一个词的都符合结果

-

match_phrase 提高了精准度

使用 should 符合 match_phrase 条件的将会使 doc 的得分增加, 使用 slop 进一步提高召回率 两步相加召回率和得分都提高了

rescore 机制优化近似匹配搜索的性能

match 和 phrase match(proximity match)的区别

-

match

只要简单的匹配到了一个 term,就可以理解将 term 对应的 doc 作为结果返回,扫描倒排索引,扫描到了就 ok

-

phrase match

首先扫描到所有 term 的 doc list; 找到包含所有 term 的 doc list; 然后对每个 doc 都计算每个 term 的 position,是否符合指定的范围; slop,需要进行复杂的运算,来判断能否通过 slop 移动,匹配一个 doc

- match query 的性能比 phrase match 和 proximity match(有 slop)要高很多。因为后两者都要计算 position 的距离。

- match query 比 phrase match 的性能要高10倍,比 proximity match 的性能要高20倍。

但是别太担心,因为 es 的性能一般都在毫秒级别,match query 一般就在几毫秒,或者几十毫秒, 而 phrase match 和 proximity match 的性能在几十毫秒到几百毫秒之间,所以也是可以接受的。

优化 proximity match 的性能,一般就是减少要进行 proximity match 搜索的 document 数量。 主要思路就是,用 match query 先过滤出需要的数据,然后再用 proximity match 来根据 term 距离提高 doc 的分数, 同时 proximity match 只针对每个 shard 的分数排名前 n 个 doc 起作用,来重新调整它们的分数, 这个过程称之为 rescoring,重计分。因为一般用户会分页查询,只会看到前几页的数据,所以不需要对所有结果进行 proximity match 操作。

用我们刚才的说法,match + proximity match同时实现召回率和精准度

默认情况下,match 也许匹配了 1000 个 doc,proximity match 全都需要对每个 doc 进行一遍运算,判断能否 slop 移动匹配上,然后去贡献自己的分数

但是很多情况下,match 出来也许 1000 个 doc,其实用户大部分情况下是分页查询的, 所以可能最多只会看前几页,比如一页是10条,最多也许就看5页,就是50条, proximity match 只要对前 50 个 doc 进行 slop 移动去匹配,去贡献自己的分数即可, 不需要对全部 1000 个 doc 都去进行计算和贡献分数

rescore 重打分

GET /forum/article/_search

{

"query": {

"match": {

"content": "java spark"

}

},

"rescore": {

"window_size": 50,

"query": {

"rescore_query": {

"match_phrase": {

"content": {

"query": "java spark",

"slop": 50

}

}

}

}

}

}

::: tip 此时应该都会有一个疑问,那么这样只重打分 50 个,最后结果正确吗?

肯定是不正确的,此时的重打分是在第一个 match 的返回的所有 doc list 上进行重打分, 而且是指定个数,所以不在重打分个数内的不会被影响。

所以这个操作只符合部分场景 :::

前缀、通配符、正则搜索

前缀搜索

C3D0-KD345

C3K5-DFG65

C4I8-UI365

搜索 C3:需要将前两条搜索出来,这个就是前缀搜索

伪造新 index 和测试数据

DELETE my_index

PUT my_index

{

"mappings": {

"my_type": {

"properties": {

"title": {

"type": "keyword"

}

}

}

}

}

PUT my_index/my_index/1

{

"title":"C3D0-KD345"

}

PUT my_index/my_index/2

{

"title":"C3K5-DFG65"

}

PUT my_index/my_index/3

{

"title":"C4I8-UI365"

}

GET my_index/_search

使用前缀查询语法

GET my_index/_search

{

"query": {

"prefix": {

"title": {

"value": "C3"

}

}

}

}

前缀搜索的原理

prefix query 不计算 relevance score,与 prefix filter 唯一的区别就是,filter 会 cache bitset

前缀越短,要处理的 doc 越多,性能越差,尽可能用长前缀搜索

前缀搜索,它是怎么执行的?性能为什么差呢?

下面举例来说明:

C3-D0-KD345

C3-K5-DFG65

C4-I8-UI365

全文检索,每个字符串都需要被分词

c3 doc1,doc2

d0

kd345

k5

dfg65

c4

i8

ui365

搜索目标 C3,扫描到 C3 即可停止了,因为能拿到目标 doc 了

而前缀搜索,你没有办法分词了,建立的倒排索引是一整个字符串,整个时候需要扫描所有的倒排索引去匹配前缀

通配符搜索

跟前缀搜索类似,功能更加强大

C3D0-KD345

C3K5-DFG65

C4I8-UI365

如这样一个需求:5字符-D任意个字符5,通配符表达式如下:

5?-*5:通配符去表达更加复杂的模糊搜索的语义

GET my_index/_search

{

"query": {

"wildcard": {

"title": {

"value": "C?K*5"

}

}

}

}

?:任意字符

*:0个或任意多个字符

响应

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 1,

"hits": [

{

"_index": "my_index",

"_type": "my_index",

"_id": "2",

"_score": 1,

"_source": {

"title": "C3K5-DFG65"

}

}

]

}

}

性能一样差,必须扫描整个倒排索引,才ok

正则搜索

GET /my_index/my_type/_search

{

"query": {

"regexp": {

"title": "C[0-9].+"

}

}

}

[0-9]:指定范围内的数字

[a-z]:指定范围内的字母

.:一个字符

+:前面的正则表达式可以出现一次或多次

wildcard 和 regexp,与 prefix 原理一致,都会扫描整个索引,性能很差

主要是给大家介绍一些高级的搜索语法。在实际应用中,能不用尽量别用。性能太差了。

match_phrase_prefix 实现搜索推荐

什么是搜索推荐(search-time)?

比如搜索 hello world,但是你在输入到 hello w 的时候,就会出现以下的一些数据

hello world

hello we

hello win

hello wind

hello dog

hello cat

hello w -->

hello world

hello we

hello win

hello wind

例如百度中搜索 –> elas –> elasticsearch –> elasticsearch权威指南

match_phrase_prefix

GET /forum/article/_search

{

"query": {

"match_phrase_prefix": {

"content": "java i"

}

}

}

响应结果

{

"took": 106,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 2,

"max_score": 1.1648302,

"hits": [

{

"_index": "forum",

"_type": "article",

"_id": "2",

"_score": 1.1648302,

"_source": {

"articleID": "KDKE-B-9947-#kL5",

"userID": 1,

"hidden": false,

"postDate": "2017-01-02",

"tag": [

"java"

],

"tag_cnt": 1,

"view_cnt": 50,

"title": "this is java blog",

"content": "i think java is the best programming language",

"sub_title": "learned a lot of course",

"author_first_name": "Smith",

"author_last_name": "Williams",

"new_author_last_name": "Williams",

"new_author_first_name": "Smith"

}

},

{

"_index": "forum",

"_type": "article",

"_id": "6",

"_score": 0.8480819,

"_source": {

"content": "java is my favourite programming language, and I also think spark is a very good big data system."

}

}

]

}

}

原理跟 match_phrase 类似,唯一的区别,就是把最后一个 term 作为前缀去搜索:

java i分词- 使用 java match

- 最后一个 term 「i」会作为前缀去扫描整个倒排索引,找到所有已 i 开头的 doc

- 然后找到既满足第 2 条,又满足第 3 条的 doc

复杂的语法如下

GET /forum/article/_search

{

"query": {

"match_phrase_prefix": {

"content": {

"query": "java i",

"slop":10,

"max_expansions": 2

}

}

}

}

- slop:只有最有一个 term 会作为前缀

-

max_expansions:指定 prefix 最多匹配多少个 term,超过这个数量就不继续匹配了,限定性能

具体是什么规则我也没有搞懂,和 slop 一起使用才能限制。测试中没有看出来什么规则

尽量不要用,因为,最后一个前缀始终要去扫描大量的索引,性能可能会很差

ngram 实现搜索推荐

什么是 ngram?

比如一个单词 quick,5 种长度下的 ngram

ngram length=1,q u i c k

ngram length=2,qu ui ic ck

ngram length=3,qui uic ick

ngram length=4,quic uick

ngram length=5,quick

被切分的词叫做 ngram。

更细化的一个名词 edge ngram;它的表现形式如下:

anchor 首字母后进行 ngram

q

qu

qui

quic

quick

其实这个形式已经能想到了,这个就是我们搜索的时候进行的推荐那样的效果,类似前缀索引的效果;

在数据写入的时候就将这种情况进行倒排索引,查询的时候和普通 match 一样了,匹配倒排索引,匹配到则 ok,不用扫描所有的倒排索引了

实践 ngram

首先自定义分词器

DELETE /my_index

PUT /my_index

{

"settings": {

"analysis": {

"filter": {

"autocomplete_filter": {

"type": "edge_ngram",

"min_gram": 1,

"max_gram": 20

}

},

"analyzer": {

"autocomplete": {

"type": "custom",

"tokenizer": "standard",

"filter": [

"lowercase",

"autocomplete_filter"

]

}

}

}

}

}

分词相关定义详细请参考 修改和定制分词器

- min_gram:最小

-

max_gram:最大

比如:quick ,max_gram = 2,那么只会切分成

- q

- qu

最大 gram 数量为 2

查看分词效果

GET /my_index/_analyze

{

"analyzer": "autocomplete",

"text": "quick brown"

}

响应结果

{

"tokens": [

{

"token": "q",

"start_offset": 0,

"end_offset": 5,

"type": "word",

"position": 0

},

{

"token": "qu",

"start_offset": 0,

"end_offset": 5,

"type": "word",

"position": 0

},

{

"token": "qui",

"start_offset": 0,

"end_offset": 5,

"type": "word",

"position": 0

},

{

"token": "quic",

"start_offset": 0,

"end_offset": 5,

"type": "word",

"position": 0

},

{

"token": "quick",

"start_offset": 0,

"end_offset": 5,

"type": "word",

"position": 0

},

{

"token": "b",

"start_offset": 6,

"end_offset": 11,

"type": "word",

"position": 1

},

{

"token": "br",

"start_offset": 6,

"end_offset": 11,

"type": "word",

"position": 1

},

{

"token": "bro",

"start_offset": 6,

"end_offset": 11,

"type": "word",

"position": 1

},

{

"token": "brow",

"start_offset": 6,

"end_offset": 11,

"type": "word",

"position": 1

},

{

"token": "brown",

"start_offset": 6,

"end_offset": 11,

"type": "word",

"position": 1

}

]

}

建立 mapping

PUT /my_index/_mapping/my_type

{

"properties": {

"title": {

"type": "string",

"analyzer": "autocomplete",

"search_analyzer": "standard"

}

}

}

插入实验数据

put my_index/my_type/1

{

"title": "hello w"

}

put my_index/my_type/2

{

"title": "hello word"

}

put my_index/my_type/3

{

"title": "hello wo"

}

put my_index/my_type/4

{

"title": "hello"

}

查询

GET /my_index/my_type/_search

{

"query": {

"match": {

"title": "hello w"

}

}

}

会发现 4 条语句都会查询出来,是因为 match 是全文检索,只是分数比较低

可以改用 match_phrase 来查询,要求每个 term 都有,而且 position 刚好靠着1位,符合我们的期望

GET /my_index/my_type/_search

{

"query": {

"match_phrase": {

"title": "hello w"

}

}

}

这次 id=4 的 hello 不会被搜索出来了

TF&IDF 算法以及向量空间模型算法

es 里的得分算法主要是 3 部分

- boolean model

- TF/IDF

- vector space model 向量空间模型算法

前面两个只是简单的过一下,主要是向量空间模型算法

boolean model

类似 and 这种逻辑操作符,先过滤出包含指定 term 的 doc

举个例子

query "hello world" --> 过滤出包含 --> hello / world / hello & world 的 doc

bool --> must/must not/should --> 过滤 --> 包含 / 不包含 / 可能包含

doc --> 经过条件过滤之后,这些步骤是不打分数 --> 正或反 true or false --> 为了减少后续要计算的 doc 的数量,提升性能

TF/IDF

详细请参考 相关度评分 TF&IDF 算法独家解密

简单或就是计算单个 term 在 doc 中的分数

比如要查询 content 中查询「hello world」

doc1: java is my favourite programming language, hello world !!!

doc2: hello java, you are very good, oh hello world!!!

hello 对 doc1 的评分

-

TF: term frequency

找到 hello 在 doc1 中出现了几次,1次,会根据出现的次数给个分数 一个 term 在一个 doc 中,出现的次数越多,那么最后给的相关度评分就会越高

-

IDF:inversed document frequency

找到 hello 在所有的 doc 中出现的次数,3 次 一个 term 在所有的 doc 中,出现的次数越多,那么最后给的相关度评分就会越低

-

length norm

hello 搜索的那个 field 的长度,field 长度越长,给的相关度评分越低; field 长度越短,给的相关度评分越高

最后,会将 hello 这个 term,对 doc1 的分数,综合 TF,IDF,length norm,计算出来一个综合性的分数

hello world –> doc1 –> hello 对 doc1的分数,world 对 doc1 的分数 –> 但是最后 hello world query 要对 doc1 有一个总的分数 –> vector space model

vector space model

这个是一个数学上的概念,很复杂。这里举例让你明白大概是个什么东西、

计算多个 term 对一个 doc 的总分数

query vector

hello world –> es 会根据 hello world 在所有 doc 中的评分情况,计算出一个 query vector,query 向量

- hello 这个 term,给的基于所有 doc 的一个评分就是 2

- world 这个 term,给的基于所有 doc 的一个评分就是 5

query vertor 就是 [2, 5]

doc vector

3 个 doc,会给每一个 doc,拿每个 term 计算出一个分数来,hello 有一个分数,world 有一个分数,再拿所有 term 的分数组成一个 doc vector

doc1:包含 hello --> [2, 0]

doc2:包含 world --> [0, 5]

doc3:包含 hello, world --> [2, 5]

画在一个图中(图也很简单,不截图了),取每个 doc vector 对 query vector 的弧度,给出每个 doc 对多个 term 的总分数

每个 doc vector 计算出对 query vector 的弧度,最后基于这个弧度给出一个 doc 相对于 query 中多个 term 的总分数 弧度越大,分数月底; 弧度越小,分数越高

如果是多个 term,那么就是线性代数来计算,无法用图表示

这个反正也没有看懂。知道是这么个名词就行了

lucene 相关度分数算法

之前讲解到 boolean model、TF/IDF、vector space model

本章是深入讲解 TF/IDF 算法在 lucene 中,底层到底进行 TF/IDF 算法计算的一个完整的公式是什么?

lucene practical scoring function

practical scoring function:来计算一个 query 对一个 doc 的分数的公式,该函数会使用一个公式来计算

score(q,d) =

queryNorm(q)

· coord(q,d)

· ∑ (

tf(t in d)

· idf(t)2

· t.getBoost()

· norm(t,d)

) (t in q)

-

score(q,d) is the relevance score of document d for query q.

这个公式的最终结果,就是说是一个 query(叫做 q),对一个 doc(叫做 d)的最终的总评分

-

queryNorm(q) is the query normalization factor (new).

是用来让一个 doc 的分数处于一个合理的区间内,不要太离谱, 举个例子,一个 doc 分数是 10000,一个 doc 分数是 0.1,你们说好不好,肯定不好

-

coord(q,d) is the coordination factor (new).

简单来说,就是对更加匹配的 doc,进行一些分数上的成倍的奖励

The sum of the weights for each term t in the query q for document d.

-

∑:求和的符号

-

∑ (t in q):

query 中每个 term,query = hello world,query 中的 term 就包含了 hello 和 world query 中每个 term 对 doc 的分数,进行求和,多个 term 对一个 doc 的分数,组成一个 vector space,然后计算,就在这一步

-

tf(t in d) is the term frequency for term t in document d.

计算每一个term对doc的分数的时候,就是TF/IDF算法

-

idf(t) is the inverse document frequency for term t.

-

t.getBoost() is the boost that has been applied to the query (new).

-

norm(t,d) is the field-length norm, combined with the index-time field-level boost, if any. (new).

query normalization factor

queryNorm = 1 / √sumOfSquaredWeights

sumOfSquaredWeights = 所有 term 的 IDF 分数之和,开一个平方根,然后做一个平方根分之 1

主要是为了将分数进行规范化 –> 开平方根,首先数据就变小了 –> 然后还用 1 去除以这个平方根,分数就会很小 –> 1.几 / 零点几

分数就不会出现几万,几十万,那样的离谱的分数

query coodination

奖励那些匹配更多字符的 doc 更多的分数

Document 1 with hello → score: 1.5

Document 2 with hello world → score: 3.0

Document 3 with hello world java → score: 4.5

Document 1 with hello → score: 1.5 * 1 / 3 = 0.5

Document 2 with hello world → score: 3.0 * 2 / 3 = 2.0

Document 3 with hello world java → score: 4.5 * 3 / 3 = 4.5

把计算出来的总分数 * 匹配上的 term 数量 / 总的 term 数量,让匹配不同 term/query 数量的doc,分数之间拉开差距

field level boost

自定义权重

::: warning 这章基本上没有看懂 :::

四种常见的相关度分数优化方法

之前两节课,我觉得已经很了解整个 es 的相关度评分的算法了,算法思想,TF/IDF,vector model,boolean model; 实际的公式,query norm,query coordination,boost

对相关度评分进行调节和优化的常见的 4种方法

query-time boost

提高权重

GET /forum/article/_search

{

"query": {

"bool": {

"should": [

{

"match": {

"title": {

"query": "java spark",

"boost": 2

}

}

},

{

"match": {

"content": "java spark"

}

}

]

}

}

}

大致的校验查看,去掉 boost 和加上 boost 观察某几个 doc 的得分变化

重构查询结构

重构查询结果,在 es 新版本中,影响越来越小了。一般情况下,没什么必要的话,大家不用也行。

就是把下面查询中原本是所有的 match 都在第一个 should 中的,改写成下面的语句

GET /forum/article/_search

{

"query": {

"bool": {

"should": [

{

"match": {

"content": "java"

}

},

{

"match": {

"content": "spark"

}

},

{

"bool": {

"should": [

{

"match": {

"content": "solution"

}

},

{

"match": {

"content": "beginner"

}

}

]

}

}

]

}

}

}

negative boost

举个例子:

搜索包含 java,不包含 spark 的 doc

但是这样子很死板,包含了 java 且 包含了 spark 的 doc 就会被过滤掉

GET /forum/article/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"content": "java"

}

}

],

"must_not": [

{

"match": {

"content": "spark"

}

}

]

}

}

}

搜索结果显示只有一条数据。

搜索包含 java,尽量不包含 spark 的 doc,如果包含了 spark,不会说排除掉这个 doc,而是说将这个 doc 的分数降低

GET /forum/article/_search

{

"query": {

"boosting": {

"positive": {

"match": {

"content": "java"

}

},

"negative": {

"match": {

"content": "spark"

}

},

"negative_boost": 0.2

}

}

}

- positive:正向搜索

- negative:否定的搜索

- negative_boost:否定的权重

包含了 negative term 的 doc,分数乘以 negative boost ,分数降低

搜索结果显示有 5 条显示,但是不包含 spark 的那一个 doc 得分和使用 must_not 查询出来的得分是一样的, 其他的得分就很低很低

constant_score

如果你压根儿不需要相关度评分,直接走 constant_score 加 filter,所有的 doc 分数都是 1,没有评分的概念了

GET /forum/article/_search

{

"query": {

"bool": {

"should": [

{

"constant_score": {

"query": {

"match": {

"title": "java"

}

}

}

},

{

"constant_score": {

"query": {

"match": {

"title": "spark"

}

}

}

}

]

}

}

}

function_score 自定义相关度分数算法

我们可以做到自定义一个 function_score 函数,自己将某个 field 的值, 跟 es 内置算出来的分数进行运算,然后由自己指定的 field 来进行分数的增强

插入实验数据,给所有的帖子数据增加 follower(查看)数量

POST /forum/article/_bulk

{ "update": { "_id": "1"} }

{ "doc" : {"follower_num" : 5} }

{ "update": { "_id": "2"} }

{ "doc" : {"follower_num" : 10} }

{ "update": { "_id": "3"} }

{ "doc" : {"follower_num" : 25} }

{ "update": { "_id": "4"} }

{ "doc" : {"follower_num" : 3} }

{ "update": { "_id": "5"} }

{ "doc" : {"follower_num" : 60} }

将对帖子搜索得到的分数,跟 follower_num 进行运算,由 follower_num 在一定程度上增强帖子的分数, 看帖子的人越多,那么帖子的分数就越高

GET /forum/article/_search

{

"query": {

"function_score": {

"query": {

"multi_match": {

"query": "java spark",

"fields": ["title","content"]

}

},

"field_value_factor": {

"field": "follower_num",

"modifier": "log1p",

"factor": 1.2

},

"boost_mode": "sum",

"max_boost": 1

}

}

}

::: tip 注意进行 field_value_factor 的 field 必须要在每条数据中存在,否则会报错

删除不存在的其他两条数据 DELETE /forum/article/6 DELETE /forum/article/7 :::

-

modifier:

默认是 none,这个时候得分 * 指定的 field。 可以设置成 log1p,使用这个内置的函数,大致意思是:new_score = old_score * log(1 + number_of_votes)

-

factor:

进一步影响分数,new_score = old_score * log(1 + factor * number_of_votes)

-

boost_mode:

可以决定分数与指定字段的值如何计算,multiply、sum、min、max、replace

-

max_boost:

限制计算出来的分数不要超过 max_boost 指定的值

fuzzy 纠错模糊搜索技术

什么是 fuzzy 纠错

考虑一个场景:搜索的时候,可能输入的搜索文本会出现误拼写的情况

doc1: Surprise me

doc2: I wasn't surprised

搜索:surprize(手抖打错了最后两个字母) ,正常情况下是一条数据都搜索不到的

fuzzy 搜索技术自动将拼写错误的搜索文本,进行纠正,纠正以后去尝试匹配索引中的数据

fuzzy 语法

插入测试数据

POST /my_index/my_type/_bulk

{ "index": { "_id": 1 }}

{ "text": "Surprise me!"}

{ "index": { "_id": 2 }}

{ "text": "That was surprising."}

{ "index": { "_id": 3 }}

{ "text": "I wasn't surprised."}

使用 fuzzy 查询语法

GET /my_index/my_type/_search

{

"query": {

"fuzzy": {

"text": {

"value": "surprize",

"fuzziness": 2

}

}

}

}

- fuzzy 搜索以后,会自动尝试将你的搜索文本进行纠错,然后去跟文本进行匹配

- fuzziness,你的搜索文本最多可以纠正几个字母去跟你的数据进行匹配,默认值为 2

响应结果

"hits": {

"total": 2,

"max_score": 0.22585157,

"hits": [

{

"_index": "my_index",

"_type": "my_type",

"_id": "1",

"_score": 0.22585157,

"_source": {

"text": "Surprise me!"

}

},

{

"_index": "my_index",

"_type": "my_type",

"_id": "3",

"_score": 0.1898702,

"_source": {

"text": "I wasn't surprised."

}

}

]

}

}

还有另外一种用法,在 match 中使用

query match 中使用 fuzziness

GET /my_index/my_type/_search

{

"query": {

"match": {

"text": {

"query": "SURPIZE ME",

"fuzziness": "AUTO",

"operator": "and"

}

}

}

}

选择 atuo,自动纠错

ik 分词器的安装与简单使用

之前大家会发现,我们全部是用英文在玩儿,不太好玩

中国人,其实我们用来进行搜索的,绝大多数,都是中文应用,很少做英文的

standard:没有办法对中文进行合理分词的,只是将每个中文字符一个一个的切割开来,比如说「中国人」就会简单的拆分为 中、国、人

所以说,我们利用核心知识篇的相关的知识,来把 es 这种英文原生的搜索引擎,先学一下; 因为有些知识点,可能用英文讲更靠谱,因为比如说 analyzed、palyed、students 进行 stemmer 后会变成 analyze,play,student, 那么使用中文来讲的话,这个就不好讲了,有些知识点,仅仅适用于英文,不太适用于中文

从这一讲开始,大家就会觉得很爽,因为全部都是我们熟悉的中文了,没有英文了,高阶知识点,搜索,聚合,全部是中文了

ik 分词器简介

在搜索引擎领域,比较成熟和流行的,就是 ik 分词器

比如:中国人很喜欢吃油条

- standard:中 国 人 很 喜 欢 吃 油 条

- ik:中国人 很 喜欢 吃 油条

看下上面分词后的结果,肯定是 ik 的分词结果比较符合中文

安装 ik 分词器

在 elasticsearch 中安装 ik 中文分词器

# 自己拉取源码进行打包

git clone https://github.com/medcl/elasticsearch-analysis-ik

git checkout tags/v5.2.0

mvn package

- 将 target/releases/elasticsearch-analysis-ik-5.2.0.zip 拷贝到 es/plugins/ik 目录下

-

在 es/plugins/ik 下对 elasticsearch-analysis-ik-5.2.0.zip 进行解压缩

比如

elasticsearch-5.2.0\plugins\ik该文件夹下就是所有的解压缩内容 - 重启 es

::: tip 在 windows 下安装中间件等开发软件,路径中最好不要有空格,否则会莫名其妙的错误 :::

ik 分词器基础知识

两种 analyzer,你根据自己的需要自己选吧,但是一般是选用 ik_max_word

-

ik_max_word 会将文本做最细粒度的拆分

比如会将「中华人民共和国国歌」拆分为:中华人民共和国、中华人民、中华、华人、人民共和国、人民、人、民、共和国、共和、和、国国、国歌,会穷尽各种可能的组合;

-

ik_smart 最粗粒度的拆分

比如会将「中华人民共和国国歌」拆分为:中华人民共和国、国歌。

显而易见在搜索效果中来说,拆分越细粒度的搜索效果越好,比如搜索「共和国」在「中华人民共和国、国歌」索引中能搜索到吗?

ik 分词器的使用

安装完后,就可以使用 _analyze 语法验证

GET /_analyze

{

"text": "中华人民共和国国歌",

"analyzer": "ik_smart"

}

响应结果

{

"tokens": [

{

"token": "中华人民共和国",

"start_offset": 0,

"end_offset": 7,

"type": "CN_WORD",

"position": 0

},

{

"token": "国歌",

"start_offset": 7,

"end_offset": 9,

"type": "CN_WORD",

"position": 1

}

]

}

插入实验数据

PUT /my_index

{

"mappings": {

"my_type": {

"properties": {

"text": {

"type": "text",

"analyzer": "ik_max_word"

}

}

}

}

}

POST /my_index/my_type/_bulk

{ "index": { "_id": "1"} }

{ "text": "男子偷上万元发红包求交女友 被抓获时仍然单身" }

{ "index": { "_id": "2"} }

{ "text": "16岁少女为结婚“变”22岁 7年后想离婚被法院拒绝" }

{ "index": { "_id": "3"} }

{ "text": "深圳女孩骑车逆行撞奔驰 遭索赔被吓哭(图)" }

{ "index": { "_id": "4"} }

{ "text": "女人对护肤品比对男票好?网友神怼" }

{ "index": { "_id": "5"} }

{ "text": "为什么国内的街道招牌用的都是红黄配?" }

查询

GET /my_index/my_type/_search

{

"query": {

"match": {

"text": "16岁少女结婚好还是单身好?"

}

}

}

响应结果

{

"took": 5,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": 3.603062,

"hits": [

{

"_index": "my_index",

"_type": "my_type",

"_id": "2",

"_score": 3.603062,

"_source": {

"text": "16岁少女为结婚“变”22岁 7年后想离婚被法院拒绝"

}

},

{

"_index": "my_index",

"_type": "my_type",

"_id": "4",

"_score": 1.3862944,

"_source": {

"text": "女人对护肤品比对男票好?网友神怼"

}

},

{

"_index": "my_index",

"_type": "my_type",

"_id": "1",

"_score": 0.2699054,

"_source": {

"text": "男子偷上万元发红包求交女友 被抓获时仍然单身"

}

}

]

}

}

对于这个结果像了解更详细的可以使用 explain 查看每个文档中的倒排索引得分情况

IK 分词器配置文件和自定义词库

主要配置解说

ik 配置文件地址:elasticsearch-5.2.0/plugins/ik/config 目录下都是存放配置文件, 下面是一些主要配置文件含义:

- IKAnalyzer.cfg.xml:用来配置自定义词库

- main.dic:ik 原生内置的中文词库,总共有 27 万多条,只要是这些单词,都会被分在一起

- quantifier.dic:放了一些单位相关的词

- suffix.dic:放了一些后缀

- surname.dic:中国的姓氏

- stopword.dic:英文停用词

IKAnalyzer.cfg.xml 内容如下

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict">custom/mydict.dic;custom/single_word_low_freq.dic</entry>

<!--用户可以在这里配置自己的扩展停止词字典-->

<entry key="ext_stopwords">custom/ext_stopword.dic</entry>

<!--用户可以在这里配置远程扩展字典 -->

<!-- <entry key="remote_ext_dict">words_location</entry> -->

<!--用户可以在这里配置远程扩展停止词字典-->

<!-- <entry key="remote_ext_stopwords">words_location</entry> -->

</properties>

ik 原生最重要的两个配置文件

- main.dic:包含了原生的中文词语,会按照这个里面的词语去分词

- stopword.dic:包含了英文的停用词。custom/ext_stopword.dic 中包含了中文的一些扩展词

什么是停用词?与其他词相比,功能词没有什么实际含义,比如’the’、’is’、’at’、’which’、’on’等。

自定义词库

每年都会涌现一些特殊的流行词,网红,蓝瘦香菇,喊麦,鬼畜,一般不会在 ik 的原生词典里, 自己补充自己的最新的词语,到 ik 的词库里面去

IKAnalyzer.cfg.xml:ext_dict,custom/mydict.dic 是在配置文件的默认文件,可以追加,也可以自定义

::: tip 想要词库生效,需要重启 es :::

可以使用如下语法进行检测

GET /_analyze

{

"text": "网红",

"analyzer": "ik_max_word"

}

使用 mysql 来达到热更新 ik 词库

什么是热更新?

修改扩展词的时候,每次都需要手动在配置文件中增加,并且需要重启 es 才能生效, es 是分布式的,可能有数百个节点,你不能每次都一个一个节点上面去修改。

es 不停机,直接我们在外部某个地方添加新的词语,es 中立即热加载到这些新词语,这就是热更新效果

热更新的方案

- 修改 ik 分词器源码,然后手动支持从 mysql 中每隔一定时间,自动加载新的词库

-

基于 ik 分词器原生支持的热更新方案

部署一个 web 服务器,提供一个 http 接口,通过 modified 和 tag 两个 http 响应头,来提供词语的热更新 这个远程更新的可以在源码中找到。使用数据库加载的时候就可以参考这个是怎么把词语放到内存中的

用第一种方案,第二种 ik git 社区官方都不建议采用,觉得不太稳定

-

下载源码

https://github.com/medcl/elasticsearch-analysis-ik/tree/v5.2.0 ik 分词器,是个标准的 java maven 工程

-

修改源码

主要思路:

Dictionary类,169行:Dictionary 单例类的初始化方法,在这里需要创建一个我们自定义的线程,并且启动它 HotDictReloadThread 类:就是死循环,不断调用 Dictionary.getSingleton().reLoadMainDict(),去重新加载词典 Dictionary类,389行:this.loadMySQLExtDict(); Dictionary类,683行:this.loadMySQLStopwordDict();然后再写个配置文件和 ik 的词库配置放一起,里面可以配置 mysql 的相关参数配置

org.wltea.analyzer.dic.Dictionary主要的入口点在这个类里面,大概看了一下代码量少,有中文注释,比较容易看懂 -

mvn package 打包代码

target\releases\elasticsearch-analysis-ik-5.2.0.zip

- 解压缩 ik 压缩包:将 mysql 驱动 jar,放入 ik 的目录下

- 修改 jdbc 相关配置

- 重启 es

观察日志,日志中就会显示我们打印的那些东西,比如加载了什么配置,加载了什么词语,什么停用词

在 mysql 中添加词库与停用词并分词实验,验证热更新是否生效

::: tip 该课程包含了一个已经实现 mysql 热更新的项目包。由于代码不是很复杂,就不提供该包了 :::

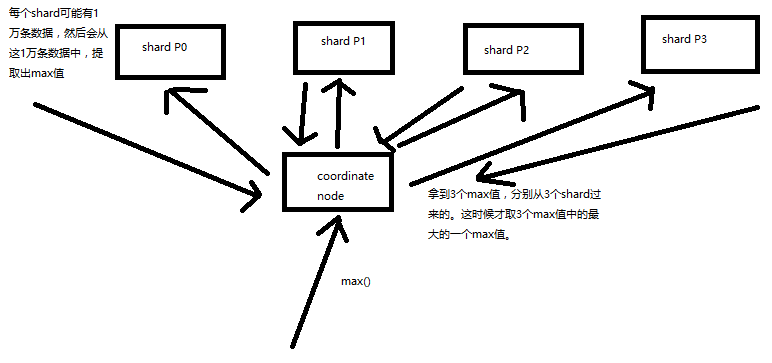

比如在 title 中查询 java

- 在一个 document 中 java 出现了几次

- 在所有的 document 中 java 出现了几次

- 这个 document 的长度

这里只有第二条会涉及到多 shard 的情况,在计算得分的时候默认只是在本地计算,而不是全局计算;

比如 10 条数据,分散在 3 个 shard 中,在第一个中有 5 条数据参与计算,在第二个中只有 1 条数据参与计算, 那么这个时候第二个中的那一条数据得分就会很高。这个时候就可能会出现原本得分很高的会被排在后面去

怎么解决?

生产环境下,数据量大,尽可能实现均匀分配

数据量很大的话,其实一般情况下,在概率学的背景下,es 都是在多个 shard 中均匀路由数据的,

路由的时候根据 _id,负载均衡

比如说有 10 个 document,title 都包含 java,一共有 5 个 shard,那么在概率学的背景下, 如果负载均衡的话,其实每个 shard 都应该有 2 个 doc,title 包含 java,如果说数据分布均匀的话, 其实就没有刚才说的那个问题了

测试环境下,将索引的 primary shard 设置为 1 个,number_of_shards=1,index settings

如果说只有一个 shard,那么当然,所有的 document 都在这个 shard 里面,就没有这个问题了

测试环境下,搜索附带 search_type=dfs_query_then_fetch 参数,会将 local IDF 取出来计算 global IDF

计算一个 doc 的相关度分数的时候,就会将所有 shard 的 local IDF 计算一下,获取出来, 在本地进行 global IDF 分数的计算,会将所有 shard 的 doc 作为上下文来进行计算,也能确保准确性。 但是 production 生产环境下,不推荐这个参数,因为性能很差。

bucket、metric 核心概念

bucket(桶)

表示一个数据分组,类似 mysql 中的 group

| city | name |

|---|---|

| 北京 | 小李 |

| 北京 | 小王 |

| 上海 | 小张 |

| 上海 | 小丽 |

| 上海 | 小陈 |

基于如上数据,按 city 划分 buckets,划分出来两个bucket:

- 北京 bucket:包含了 2 个人,小李,小王

- 上海 bucket:包含了 3 个人,小张,小丽,小陈

按照某个字段进行 bucket 划分,那个字段的值相同的那些数据,就会被划分到一个 bucket 中

metric

表示对一个数据分组执行的统计操作

当我们有了一堆 bucket 之后,就可以对每个 bucket 中的数据进行聚合分词了,

metric 就是对一个 bucket 执行的某种聚合分析的操作,比如说求平均值、求最大值、求最小值

使用如下 sql 来理解这两个概念

select count(*) from access_log group by user_id

- bucket:

group by user_id,那些 user_id 相同的数据,就会被划分到一个 bucket 中 - metric:

count(*),对每个 user_id bucket 中所有的数据,计算一个数量统计哪种颜色电视销量最高&案例介绍

家电卖场案例背景

以一个家电卖场中的电视销售数据为背景,来对各种品牌,各种颜色的电视的销量和销售额,进行各种各样角度的分析

根据业务进行定制 mappings

PUT /tvs

{

"mappings": {

"sales": {

"properties": {

"price": {

"type": "long"

},

"color": {

"type": "keyword"

},

"brand": {

"type": "keyword"

},

"sold_date": {

"type": "date"

}

}

}

}

}

插入销售数据

POST /tvs/sales/_bulk

{ "index": {}}

{ "price" : 1000, "color" : "红色", "brand" : "长虹", "sold_date" : "2016-10-28" }

{ "index": {}}

{ "price" : 2000, "color" : "红色", "brand" : "长虹", "sold_date" : "2016-11-05" }

{ "index": {}}

{ "price" : 3000, "color" : "绿色", "brand" : "小米", "sold_date" : "2016-05-18" }

{ "index": {}}

{ "price" : 1500, "color" : "蓝色", "brand" : "TCL", "sold_date" : "2016-07-02" }

{ "index": {}}

{ "price" : 1200, "color" : "绿色", "brand" : "TCL", "sold_date" : "2016-08-19" }

{ "index": {}}

{ "price" : 2000, "color" : "红色", "brand" : "长虹", "sold_date" : "2016-11-05" }

{ "index": {}}

{ "price" : 8000, "color" : "红色", "brand" : "三星", "sold_date" : "2017-01-01" }

{ "index": {}}

{ "price" : 2500, "color" : "蓝色", "brand" : "小米", "sold_date" : "2017-02-12" }

统计哪种颜色的电视销量最高

GET /tvs/sales/_search

{

"size": 0,

"aggs": {

"popular_colors": {

"terms": {

"field": "color"

}

}

}

}

- size:只获取聚合结果,而不要返回参与聚合的原始数据

- aggs:固定语法,要对一份数据执行分组聚合操作

- popular_colors:就是对每个 aggs 都要起一个名字,这个名字是自定义的

- terms:根据字段的值进行分组

- field:根据指定的字段的值进行分组

可以看到响应的结果,已经分好组了

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 8,

"max_score": 0,

"hits": []

},

"aggregations": {

"popular_colors": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "红色",

"doc_count": 4

},

{

"key": "绿色",

"doc_count": 2

},

{

"key": "蓝色",

"doc_count": 2

}

]

}

}

}

- hits.hits:我们指定了size=0,所以 hits.hits 就是空的,否则会把执行聚合的那些原始数据给你返回回来

- aggregations:聚合结果

- popular_color:我们指定的某个聚合的名称

- buckets:根据我们指定的 field 划分出的 buckets

- key:每个 bucket 对应的那个值

- doc_count:这个 bucket 分组内,有多少个数据

- 数量,其实就是这种颜色的销量

- 默认的排序规则:按照 doc_count 降序排序

bucket+metric 统计每种颜色电视平均价格

按照 color 去分 bucket,可以拿到每个 color bucket 中的数量,这个仅仅只是一个 bucket 操作, doc_count 可以看成是 es 的 bucket 操作 默认执行的一个内置 metric

统计每种颜色电视平均价格如下。

GET /tvs/sales/_search

{

"size" : 0,

"aggs": {

"colors": {

"terms": {

"field": "color"

},

"aggs": {

"avg_price": {

"avg": {

"field": "price"

}

}

}

}

}

}

看如上代码,使用了 terms bucket 操作,如下代码就是一个 metric 操作, 对每个 bucket 的数据进行平均值计算

"aggs": {

"avg_price": {

"avg": {

"field": "price"

}

}

}

看看响应结果

{

"took": 6,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 8,

"max_score": 0,

"hits": []

},

"aggregations": {

"colors": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "红色",

"doc_count": 4,

"avg_price": {

"value": 3250

}

},

{

"key": "绿色",

"doc_count": 2,

"avg_price": {

"value": 2100

}

},

{

"key": "蓝色",

"doc_count": 2,

"avg_price": {

"value": 2000

}

}

]

}

}

}

- avg_price:我们自己取的 metric aggs 的名字

- value:metric 计算的结果,每个 bucket 中的数据的 price 字段求平均值后的结果

bucket 嵌套实现颜色+品牌的多层下钻分析

从颜色到品牌进行下钻分析,每种颜色的平均价格,以及找到每种颜色每个品牌的平均价格

在实现该需求之前,我们先来了解下什么是下钻分析

什么是下钻?

比如说,现在红色的电视有 4 台,有 3 台是属于长虹的,1 台是属于小米的

- 红色电视中的 3 台长虹的平均价格是多少?