用大白话告诉你什么是 Elasticsearch

Elasticsearch,分布式,高性能,高可用,可伸缩的搜索和分析系统

- 什么是搜索?

- 如果用数据库做搜索会怎么样?

- 什么是全文检索、倒排索引和Lucene?

- 什么是Elasticsearch?

什么是搜索?

百度:我们比如说想找寻任何的信息的时候,就会上百度去搜索一下,比如说找一部自己喜欢的电影,或者说找一本喜欢的书,或者找一条感兴趣的新闻(提到搜索的第一印象) 百度 != 搜索,这是不对的

垂直搜索(站内搜索)

互联网的搜索:电商网站,招聘网站,新闻网站,各种app IT系统的搜索:OA软件,办公自动化软件,会议管理,日程管理,项目管理,员工管理,搜索“张三”,“张三儿”,“张小三”;有个电商网站,卖家,后台管理系统,搜索“牙膏”,订单,“牙膏相关的订单”

搜索,就是在任何场景下,找寻你想要的信息,这个时候,会输入一段你要搜索的关键字,然后就期望找到这个关键字相关的有些信息

如果用数据库做搜索会怎么样?

做软件开发的话,或者对IT、计算机有一定的了解的话,都知道,数据都是存储在数据库里面的,比如说电商网站的商品信息,招聘网站的职位信息,新闻网站的新闻信息,等等吧。所以说,很自然的一点,如果说从技术的角度去考虑,如何实现如说,电商网站内部的搜索功能的话,就可以考虑,去使用数据库去进行搜索。

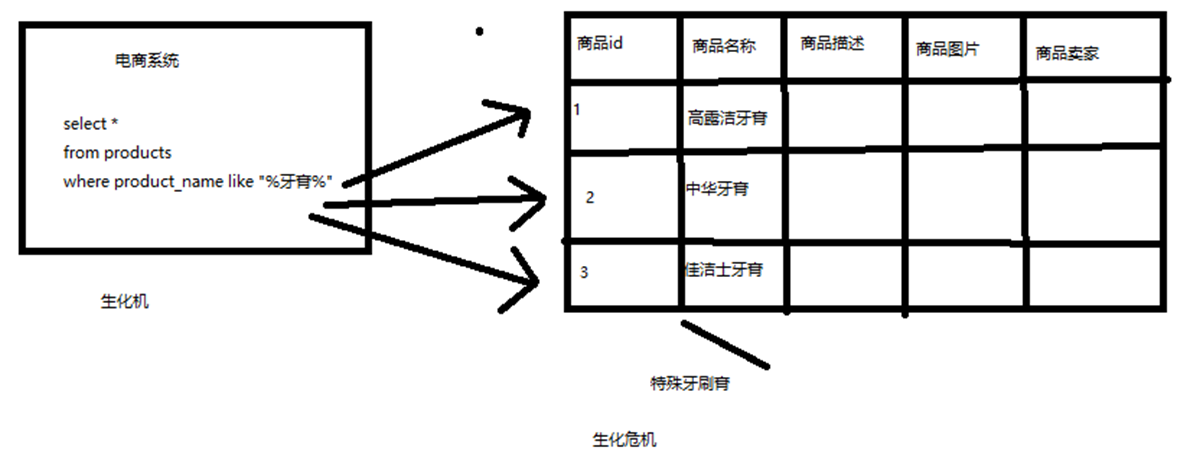

假如下图:电商系统的商品搜索

- 搜索含有牙膏的商品

- 在数据库中商品名称字段中存储有关键字

数据库来处理的话,不考虑数据库的全文索引什么的,假如商品有 1000万 个,那么基本上就要查找 1000 万次,且每次都需要加载商品的名称字段的整段字符串,并挨个寻找。

-

比方说,每条记录的指定字段的文本,可能会很长,比如说“商品描述”字段的长度,有长达数千个,甚至数万个字符,这个时候,每次都要对每条记录的所有文本进行扫描,懒判断说,你包不包含我指定的这个关键词(比如说“牙膏”)

-

还不能将搜索词拆分开来,尽可能去搜索更多的符合你的期望的结果,比如输入“生化机”,就搜索不出来“生化危机”

用数据库来实现搜索,是不太靠谱的。通常来说,性能会很差的。

什么是全文检索和Lucene?

- 全文检索,倒排索引

-

lucene,就是一个 jar 包,

里面包含了封装好的各种建立倒排索引,以及进行搜索的代码,包括各种算法。

我们就用 java 开发的时候,引入 lucene jar,然后基于 lucene 的 api 进行去进行开发就可以了。用 lucene,我们就可以去将已有的数据建立索引,lucene 会在本地磁盘上面,给我们组织索引的数据结构。另外的话,我们也可以用 lucene 提供的一些功能和 api 来针对磁盘上的数据进行搜索

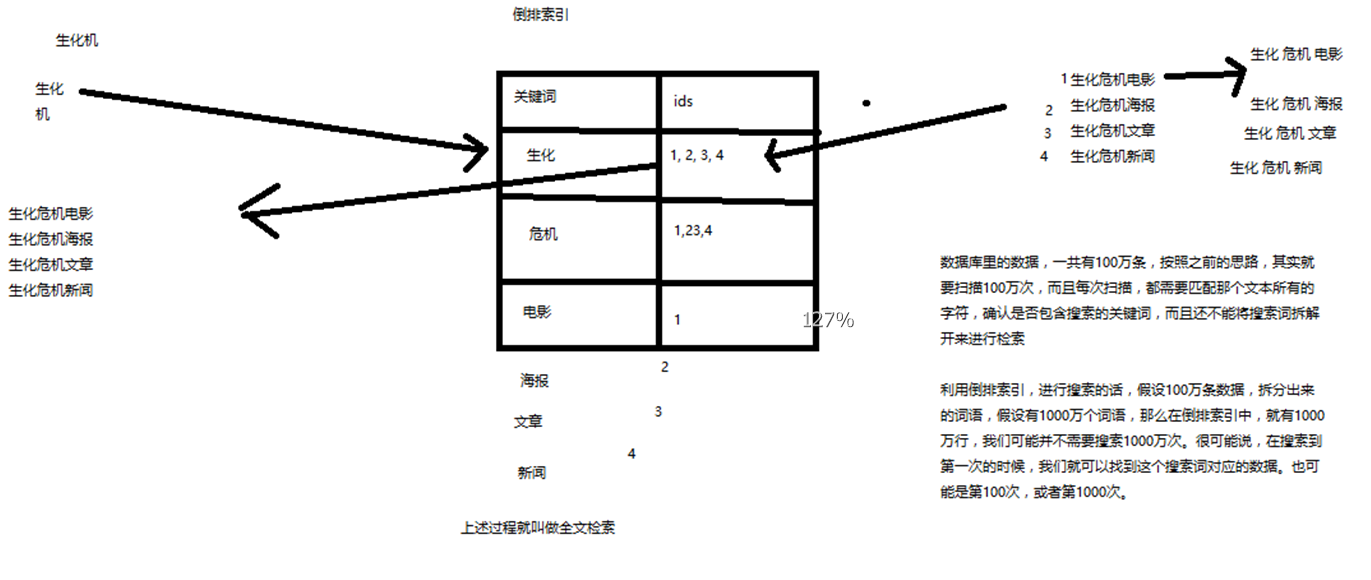

全文索检索和倒排索引简述

简单说就如下图

场景:搜索“生化机”(有可能是手抖打错了,本来是生化危机),但是期望需要出来右侧的 4条 记录

- 有 4条 数据

- 将每条数据进行词条拆分。如“生化危机电影”拆成:生化、危机、电影 关键词(拆分结果与策略算法有关)

- 每个关键词将对应包含此关键词的数据 ID

- 搜索的时候,直接匹配这些关键词,就能拿到包含关键词的数据

这个过程就叫做全文检索。而词条拆分和词条对应的 ID 这个就是倒排索引的的基本原理

什么是Elasticsearch?

我们可以使用 lucene 开发搜索服务,部署在一台机器上面,但是无法解决当数据量增大的时候出现的问题(图上右侧)。那么 elasticsearch 就是解决这种场景的工具;

- 自动维护数据的分布到多个节点的索引建立、检索请求分布到多个节点的执行

- 自动维护数据的冗余副本,保证一些机器宕机了,不会丢失任何数据

-

封装了更多的高级功能

给我们提供更多高级的支持,让我们快速的开发应用,开发更加复杂的应用; 复杂的搜索功能,聚合分析的功能,基于地理位置的搜多(距离我当前位置 1公里 以内的烤肉店)

Elasticsearch 核心概念

- lucene 和 elasticsearch 的前世今生

- elasticsearch 的核心概念

- elasticsearch 核心概念 vs 数据库核心概念

lucene 和 elasticsearch 的前世今生

lucene,最先进、功能最强大的搜索库;直接基于 lucene 开发,非常复杂,api 复杂(实现一些简单的功能,写大量的 java 代码),需要深入理解原理(各种索引结构)

elasticsearch 基于 lucene,隐藏复杂性,提供简单易用的 restful api 接口、java api 接口(还有其他语言的api接口)

- 分布式的文档存储引擎

- 分布式的搜索引擎和分析引擎

- 分布式,支持PB级数据

开箱即用,优秀的默认参数,不需要任何额外设置,完全开源

关于 elasticsearch 的一个传说,有一个程序员失业了,陪着自己老婆去英国伦敦学习厨师课程。程序员在失业期间想给老婆写一个菜谱搜索引擎,觉得 lucene 实在太复杂了,就开发了一个封装了 lucene 的开源项目 compass。后来程序员找到了工作,是做分布式的高性能项目的,觉得 compass 不够,就写了 elasticsearch,让 lucene 变成分布式的系统。

elasticsearch 的核心概念

-

Near Realtime(NRT)近实时

两个意思:

从写入数据到数据可以被搜索到有一个小延迟(大概1秒);

基于es执行搜索和分析可以达到秒级

-

Cluster 集群

包含多个节点,每个节点属于哪个集群是通过一个配置(集群名称,默认是 elasticsearch )来决定的,对于中小型应用来说,刚开始一个集群就一个节点很正常

-

Node 节点

集群中的一个节点,节点也有一个名称(默认是随机分配的),节点名称很重要(在执行运维管理操作的时候),默认节点会去加入一个名称为 “elasticsearch” 的集群,如果直接启动一堆节点,那么它们会自动组成一个 elasticsearch 集群,当然一个节点也可以组成一个 elasticsearch 集群

-

Document&field 文档

es中的最小数据单元,一个 document 可以是一条客户数据,一条商品分类数据,一条订单数据,通常用 JSON 数据结构表示

一个 index 下的 type 中,都可以去存储多个 document。

一个 document 里面有多个 field,每个field就是一个数据字段。

product document { "product_id": "1", "product_name": "高露洁牙膏", "product_desc": "高效美白", "category_id": "2", "category_name": "日化用品" } -

Index 索引

包含一堆有相似结构的文档数据,比如可以有一个客户索引,商品分类索引,订单索引,索引有一个名称。

一个 index 包含很多 document,一个 index 就代表了一类类似的或者相同的 document。比如说建立一个 product index,商品索引,里面可能就存放了所有的商品数据,所有的商品 document。

-

Type 类型

每个索引里都可以有一个或多个 type,type 是 index 中的一个逻辑数据分类,一个 type 下的 document,都有相同的 field,比如博客系统,有一个索引,可以定义用户数据 type,博客数据 type,评论数据 type。

商品index,里面存放了所有的商品数据,商品 document

但是商品分很多种类,每个种类的 document 的 field 可能不太一样,比如说电器商品,可能还包含一些诸如售后时间范围这样的特殊 field;生鲜商品,还包含一些诸如生鲜保质期之类的特殊 field

type,日化商品 type,电器商品 type,生鲜商品 type

日化商品 type:product_id,product_name,product_desc,category_id,category_name

电器商品 type:product_id,product_name,product_desc,category_id,category_name,service_period

生鲜商品 type:product_id,product_name,product_desc,category_id,category_name,eat_period

每一个 type 里面,都会包含一堆 document

{ "product_id": "2", "product_name": "长虹电视机", "product_desc": "4k高清", "category_id": "3", "category_name": "电器", "service_period": "1年" } { "product_id": "3", "product_name": "基围虾", "product_desc": "纯天然,冰岛产", "category_id": "4", "category_name": "生鲜", "eat_period": "7天" }- index :可以看成是一个数据库

- type :可以看成是数据库中的表

- document:可以看成是表中的记录

-

shard 分片

单台机器无法存储大量数据,es 可以将一个索引中的数据切分为多个 shard,分布在多台服务器上存储。有了 shard 就可以横向扩展,存储更多数据,让搜索和分析等操作分布到多台服务器上去执行,提升吞吐量和性能。每个 shard 都是一个 lucene index。

-

replica 复制集/副本

任何一个服务器随时可能故障或宕机,此时 shard 可能就会丢失,因此可以为每个 shard 创建多个 replica副本。replica 可以在 shard 故障时提供备用服务,保证数据不丢失,多个 replica 还可以提升搜索操作的吞吐量和性能。

- primary shard(建立索引时一次设置,不能修改,默认5个)

- replica shard(随时修改数量,默认1个)

默认每个索引 10 个 shard,5个 primary shard,5个 replica shard,最小的高可用配置,是 2台 服务器。

核心概念 vs 数据库核心概念

| Elasticsearch | 数据库 |

|---|---|

| Document | 行 |

| Type | 表 |

| Index | 库 |

windows 上启动 Elasticsearch

-

安装 JDK,至少 1.8.0_73 以上版本,java -version

-

下载和解压缩 Elasticsearch 安装包 elasticsearch-5.2.0.zip,并了解目录结构

-

启动 Elasticsearch:bin\elasticsearch.bat,

es本身特点之一就是开箱即用,如果是中小型应用,数据量少,操作不是很复杂,直接启动就可以用了

-

检查ES是否启动成功:http://localhost:9200/?pretty

name: node名称 cluster_name: 集群名称(默认的集群名称就是elasticsearch) version.number: 5.2.0,es版本号 { "name" : "4onsTYV", "cluster_name" : "elasticsearch", "cluster_uuid" : "nKZ9VK_vQdSQ1J0Dx9gx1Q", "version" : { "number" : "5.2.0", "build_hash" : "24e05b9", "build_date" : "2017-01-24T19:52:35.800Z", "build_snapshot" : false, "lucene_version" : "6.4.0" }, "tagline" : "You Know, for Search" } -

修改集群名称:elasticsearch.yml

-

下载和解压缩 Kibana 安装包 kibana-5.2.0-windows-x86.zip

使用里面的开发界面,去操作 elasticsearch,作为我们学习es知识点的一个主要的界面入口

-

启动Kibana:bin\kibana.bat

-

进入Dev Tools界面

-

GET _cluster/health

{ "cluster_name": "elasticsearch", "status": "yellow", "timed_out": false, "number_of_nodes": 1, "number_of_data_nodes": 1, "active_primary_shards": 1, "active_shards": 1, "relocating_shards": 0, "initializing_shards": 0, "unassigned_shards": 1, "delayed_unassigned_shards": 0, "number_of_pending_tasks": 0, "number_of_in_flight_fetch": 0, "task_max_waiting_in_queue_millis": 0, "active_shards_percent_as_number": 50 }快速上手-集群健康检查、文档 CRUD

- document 数据格式

- 电商网站商品管理案例:背景介绍

- 简单的集群管理

- 商品的 CRUD 操作(document CRUD 操作)

::: tip 快速上手的三章节,只是展示简单的使用 :::

document 数据格式

面向文档的搜索分析引擎

- 应用系统的数据结构都是面向对象的、复杂的

- 对象数据存储到数据库中,只能拆解开来,变为扁平的多张表,每次查询的时候还得还原回对象格式,相当麻烦

- ES 是面向文档的,文档中存储的数据结构,与面向对象的数据结构是一样的,基于这种文档数据结构,es 可以提供复杂的索引,全文检索,分析聚合等功能

- es 的 document 用 json 数据格式来表达

如下的一个场景,在 Java 中面向对象存入数据库的时候:

public class Employee {

private String email;

private String firstName;

private String lastName;

private EmployeeInfo info;

private Date joinDate;

}

private class EmployeeInfo {

private String bio; // 性格

private Integer age;

private String[] interests; // 兴趣爱好

}

EmployeeInfo info = new EmployeeInfo();

info.setBio("curious and modest");

info.setAge(30);

info.setInterests(new String[]{"bike", "climb"});

Employee employee = new Employee();

employee.setEmail("zhangsan@sina.com");

employee.setFirstName("san");

employee.setLastName("zhang");

employee.setInfo(info);

employee.setJoinDate(new Date());

employee 对象:里面包含了 Employee 类自己的属性,还有一个 EmployeeInfo 对象

两张表:employee 表,employee_info 表,将 employee 对象的数据重新拆开来,变成 Employee 数据和 EmployeeInfo 数据

- employee表:email,first_name,last_name,join_date,4个字段

- employee_info表:bio,age,interests,3个字段;此外还有一个外键字段,比如employee_id,关联着employee表

而在 es 中的 document

{

"email": "zhangsan@sina.com",

"first_name": "san",

"last_name": "zhang",

"info": {

"bio": "curious and modest",

"age": 30,

"interests": [ "bike", "climb" ]

},

"join_date": "2017/01/01"

}

我们就明白了 es 的 document 数据格式和数据库的关系型数据格式的区别

电商网站商品管理案例背景介绍

::: tip 该实例纯粹是为了演示 es 的 crud 的基本操作 :::

现在考虑一个场景:有一个电商网站,需要为其基于 ES 构建一个后台系统,提供以下功能:

- 对商品信息进行 CRUD(增删改查)操作

- 执行简单的结构化查询

- 可以执行简单的全文检索,以及复杂的 phrase(短语)检索

- 对于全文检索的结果,可以进行高亮显示

- 对数据进行简单的聚合分析

简单的集群管理

快速检查集群的健康状况

es 提供了一套api,叫做 cat api,可以查看 es 中各种各样的数据;

::: tip 看到是 restuful api 的链接基本上都是在 kibana 中操作查询 :::

GET /_cat/health?v 获取当前集群关键的信息,参与 v : 显示标题头

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1546235661 13:54:21 elasticsearch yellow 1 1 1 1 0 0 1 0 - 50.0%

-------------

unassign:未分配数量

active_shards_percent:可用 shards 百分比

如何快速了解集群的健康状况?可以通过 status 的值: green、yellow、red?

- green:每个索引的 primary shard 和 replica shard 都是 active 状态的

- yellow:每个索引的 primary shard 都是 active 状态的,但是部分 replica shard 不是 active 状态,处于不可用的状态

- red:不是所有索引的 primary shard 都是 active 状态的,部分索引有数据丢失了

为什么现在会处于一个 yellow 状态?

我们现在就一个笔记本电脑,就启动了一个 es 进程,相当于就只有一个 node。

现在 es 中有一个 index,就是 kibana 自己内置建立的 index。由于默认的配置是给每个 index 分配 5个 primary shard 和 5个 replica shard,而且 primary shard 和 replica shard 不能在同一台机器上(为了容错)。

现在 kibana 自己建立的 index 是 1个 primary shard 和 1个 replica shard。

当前就一个 node,所以只有 1个 primary shard 被分配了和启动了,但是一个 replica shard 没有第二台机器去启动。

做一个小实验: 此时只要启动第二个 es 进程,就会在 es 集群中有 2个 node,然后那 1个 replica shard 就会自动分配过去,然后 cluster status 就会变成 green 状态。

步骤:值需要再把压缩包解压一份,直接启动 bin/elasticsearch.bat 即可,关于端口,通过观察应该会自动生成端口,这一点做得很强大

第一个 es 启动后端口情况:

publish_address {127.0.0.1:9300}, bound_addresses {127.0.0.1:9300}, {[::1]:9300}

第二个 es 启动后端口情况:

publish_address {127.0.0.1:9301}, bound_addresses {127.0.0.1:9301}, {[::1]:9301}

再次查看集群信息: GET /_cat/health?v

只有一个 es 的信息

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1546235661 13:54:21 elasticsearch yellow 1 1 1 1 0 0 1 0 - 50.0%

启动第二个 es 后的信息

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1546236258 14:04:18 elasticsearch green 2 2 2 1 0 0 0 0 - 100.0%

快速查看集群中有哪些索引

GET /_cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open .kibana id1SV_oGSjyGosKxeJApww 1 1 1 0 3.1kb 3.1kb

可以看到此时就只有一个 kibana 的索引,它的 primary shard(pri.store.size) 占用的大小是 3.1kb

简单的索引操作

创建索引 PUT /test_index?pretty;创建一个名为 test_index 的索引

{

"acknowledged": true,

"shards_acknowledged": true

}

------------- 再次查看索引 GET /_cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open test_index JXdbMWj8T9-Y0JWW5-M7fg 5 1 0 0 650b 650b

yellow open .kibana id1SV_oGSjyGosKxeJApww 1 1 1 0 3.1kb 3.1kb

可以看到 pri 默认是 5 个,rep 默认是 1 个

删除索引 DELETE /test_index?pretty

{

"acknowledged": true

}

商品的 CRUD 操作

新增

这里没有使用中文,由于中文分词需要安装插件,对于数据查询才会准确,所以这里使用拼音

PUT /ecommerce/product/1

{

"name" : "gaolujie yagao",

"desc" : "gaoxiao meibai",

"price" : 30,

"producer" : "gaolujie producer",

"tags": [ "meibai", "fangzhu" ]

}

-------- 响应

// 可以看到 index 和 type 对应了 PUT 地址中的信息

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_version": 1,

"result": "updated",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"created": false

}

_version:数据版本号,用途一般是是乐观锁,后面会讲解_shards:分片信息- total :总的要写的分片数量是 2

- successful :成功了 1 个

- failed :失败了 0 个

这里为什么 total 是 2个?简单说:一个 pre 默认对应一个 rep 这里只有一台机器,所以 1 个 pre + rep 等于 2, 但是只有一台机器,rep 没有被分配,所以只成功了一个,总数是 2 个;反正这里有点懵逼,pre 和 rep 的分配策略什么的不知道,所以这里的数字有一点对不上,后面课程会讲解

再多增加几条数据

PUT /ecommerce/product/2

{

"name" : "jiajieshi yagao",

"desc" : "youxiao fangzhu",

"price" : 25,

"producer" : "jiajieshi producer",

"tags": [ "fangzhu" ]

}

PUT /ecommerce/product/3

{

"name" : "zhonghua yagao",

"desc" : "caoben zhiwu",

"price" : 40,

"producer" : "zhonghua producer",

"tags": [ "qingxin" ]

}

es 会自动建立 index 和 type,不需要提前创建,而且 es 默认会对 document 每个 field 都建立倒排索引,让其可以被搜索

查询商品:检索文档

语法:GET /index/type/id

`GET /ecommerce/product/1`

--------- 响应

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_version": 1,

"found": true,

"_source": {

"name": "gaolujie yagao",

"desc": "gaoxiao meibai",

"price": 30,

"producer": "gaolujie producer",

"tags": [

"meibai",

"fangzhu"

]

}

}

修改商品:替换文档

PUT /ecommerce/product/1

{

"name" : "jiaqiangban gaolujie yagao",

"desc" : "gaoxiao meibai",

"price" : 30,

"producer" : "gaolujie producer",

"tags": [ "meibai", "fangzhu" ]

}

--------- 响应

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_version": 2,

"result": "updated",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"created": false

}

替换文档:顾名思义,原始 _id 中的所有 document 内容被覆盖;

修改商品:更新文档

POST /ecommerce/product/1/_update

{

"doc": {

"name": "jiaqiangban gaolujie yagao"

}

}

--------- 响应

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_version": 8,

"result": "updated",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

}

}

删除商品:删除文档

DELETE /ecommerce/product/1

--------- 响应

{

"found": true,

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_version": 4,

"result": "deleted",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

}

}

如果删除一个不存在的 id 文档将是

{

"found": false,

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_version": 7,

"result": "not_found",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

}

}

_version :每执行一次操作 version 都会自增一次

快速上手-商品搜索多种方式

- query string search

- query DSL

- query filter

- full-text search

- phrase search

- highlight search - 真正意义上算不上一种搜索方式

query string search

通俗一点来说,就是以 http get 方式去拼接参数的一种方式

查询所有商品

GET /ecommerce/product/_search

----- 响应

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 2,

"max_score": 1,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "2",

"_score": 1,

"_source": {

"name": "jiajieshi yagao",

"desc": "youxiao fangzhu",

"price": 25,

"producer": "jiajieshi producer",

"tags": [

"fangzhu"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": 1,

"_source": {

"name": "zhonghua yagao",

"desc": "caoben zhiwu",

"price": 40,

"producer": "zhonghua producer",

"tags": [

"qingxin"

]

}

}

]

}

}

- took:耗费了几毫秒

- timed_out:是否超时,这里是没有

_shards:数据拆成了5个分片,所以对于搜索请求,会打到所有的 primary shard(或者是它的某个 replica shard 也可以)- hits.total:查询结果的数量,3个 document

- hits.max_score:score 的含义,就是 document 对于一个 search 的相关度的匹配分数,越相关,就越匹配,分数也高

- hits.hits:包含了匹配搜索的 document 的详细数据

条件查询

搜索名称中带有 “yagao” 的商品,且按价格降序排列:

GET /ecommerce/product/_search?q=name:yagao&sort=price:desc

适用于临时的在命令行使用一些工具,比如 curl,快速的发出请求,来检索想要的信息;但是如果查询请求很复杂,是很难去构建的 在生产环境中,几乎很少使用 query string search

query DSL

DSL:Domain Specified Language,特定领域的语言

http request body:请求体,可以用 json 的格式来构建查询语法,比较方便,可以构建各种复杂的语法,比 query string search 肯定强大多了

查询所有

GET /ecommerce/product/_search

{

"query": {

"match_all": {}

}

}

条件查询

搜索名称中带有 “yagao” 的商品,且按价格降序排列:

GET /ecommerce/product/_search

{

"query": {

"match": {

"name": "yagao"

}

},

"sort": [

{

"price": {

"order": "desc"

}

}

]

}

// price 这里也可以直接简写成 "price":"desc"

----------- 响应

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": null,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": null,

"_source": {

"name": "zhonghua yagao",

"desc": "caoben zhiwu",

"price": 40,

"producer": "zhonghua producer",

"tags": [

"qingxin"

]

},

"sort": [

40

]

}

]

}

}

.... 部分结果

分页查询

总共 3条 商品,假设每页就显示 1条 商品,现在显示第 2页,所以就查出来第 2个 商品

GET /ecommerce/product/_search

{

"query": {

"match_all": {}

},

"from": 1,

"size": 1

}

注意这里的 from:表示是从第几条数据开始,而不是表示 页数

限制返回字段

指定要查询出来商品的名称和价格就可以

GET /ecommerce/product/_search

{

"query": {

"match_all": {}

},

"_source": ["name","price"]

}

---- 响应

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": 1,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "2",

"_score": 1,

"_source": {

"price": 25,

"name": "jiajieshi yagao"

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_score": 1,

"_source": {

"price": 30,

"name": "gaolujie yagao"

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": 1,

"_source": {

"price": 40,

"name": "zhonghua yagao"

}

}

]

}

}

更加适合生产环境的使用,可以构建复杂的查询

query filter

简单说就是在查询后,再进行过滤操作(可以理解为多条件查询)。

搜索商品名称包含 yagao,而且售价大于 25元 的商品

GET /ecommerce/product/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"name": "yagao"

}

}

],

"filter": {

"range": {

"price": {

"gte": 25

}

}

}

}

}

}

full-text search(全文检索)

为了演示这个示例,先增加一条数据

PUT /ecommerce/product/4

{

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

}

查询示例: 查询 producer 中包含 yagao 和 producer 的数据

GET /ecommerce/product/_search

{

"query" : {

"match" : {

"producer" : "yagao producer"

}

}

}

-------- 响应

{

"took": 8,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0.70293105,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "4",

"_score": 0.70293105,

"_source": {

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_score": 0.25811607,

"_source": {

"name": "gaolujie yagao",

"desc": "gaoxiao meibai",

"price": 30,

"producer": "gaolujie producer",

"tags": [

"meibai",

"fangzhu"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": 0.25811607,

"_source": {

"name": "zhonghua yagao",

"desc": "caoben zhiwu",

"price": 40,

"producer": "zhonghua producer",

"tags": [

"qingxin"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "2",

"_score": 0.1805489,

"_source": {

"name": "jiajieshi yagao",

"desc": "youxiao fangzhu",

"price": 25,

"producer": "jiajieshi producer",

"tags": [

"fangzhu"

]

}

}

]

}

}

针对这个结果的一些说明:_score:相关度评分

回顾下倒排索引,针对 producer 字段:

producer 这个字段,会先被拆解,建立倒排索引

| 关键词 | ids |

|---|---|

| special | 4 |

| yagao | 4 |

| producer | 1,2,3,4 |

| gaolujie | 1 |

| zhognhua | 3 |

| jiajieshi | 2 |

id 为 4 的评分为什么这么高呢?

仔细观察 搜索目标 “yagao producer” 会被拆解成 yagao和 producer

在倒排索引中出现了 2次 ,而其他数据只出现了一次,所以它的评分是最高的

phrase search(短语搜索)

跟全文检索相对应,相反,全文检索会将输入的搜索串拆解开来,去倒排索引里面去一一匹配,只要能匹配上任意一个拆解后的单词,就可以作为结果返回

phrase search:要求输入的搜索串,必须在指定的字段文本中,完全包含一模一样的,才可以算匹配,才能作为结果返回

GET /ecommerce/product/_search

{

"query" : {

"match_phrase" : {

"producer" : "yagao producer"

}

}

}

---- 响应

{

"took": 10,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 0.70293105,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "4",

"_score": 0.70293105,

"_source": {

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

}

}

]

}

}

highlight search(高亮搜索结果)

GET /ecommerce/product/_search

{

"query" : {

"match_phrase" : {

"producer" : "yagao producer"

}

},

"highlight": {

"fields": {

"producer": {}

}

}

}

----- 响应

{

"took": 61,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 0.70293105,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "4",

"_score": 0.70293105,

"_source": {

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

},

"highlight": {

"producer": [

"special <em>yagao</em> <em>producer</em>"

]

}

}

]

}

}

增加了 highlight 配置,响应结果中除了目标数据,还返回了 highlight 的信息;

仔细看 _source 中的 producer 和 highlight 中的 producer 文本信息的区别,这一整条信息中被搜索的关键词都被 em 标签包裹了。在显示的时候,可以针对 em 进行高亮样式处理,这就是高亮结果

"producer": "special yagao producer"

"producer": [

"special <em>yagao</em> <em>producer</em>"

]

快速上手-聚合分析

嵌套聚合,下钻分析,聚合分析

计算每个 tag 下的商品数量

语法:

- aggs:聚合函数

- NAME:给这个操作取一个名字

- AGG_TYPE:聚合类型

GET /ecommerce/product/_search

{

"aggs": {

"NAME": {

"AGG_TYPE": {}

}

}

}

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags"

}

}

}

}

------------ 响应

{

"error": {

"root_cause": [

{

"type": "illegal_argument_exception",

"reason": "Fielddata is disabled on text fields by default. Set fielddata=true on [tags] in order to load fielddata in memory by uninverting the inverted index. Note that this can however use significant memory."

}

],

"type": "search_phase_execution_exception",

"reason": "all shards failed",

"phase": "query",

"grouped": true,

"failed_shards": [

{

"shard": 0,

"index": "ecommerce",

"node": "sEvAlYxFRJe598mrSDwUjQ",

"reason": {

"type": "illegal_argument_exception",

"reason": "Fielddata is disabled on text fields by default. Set fielddata=true on [tags] in order to load fielddata in memory by uninverting the inverted index. Note that this can however use significant memory."

}

}

],

"caused_by": {

"type": "illegal_argument_exception",

"reason": "Fielddata is disabled on text fields by default. Set fielddata=true on [tags] in order to load fielddata in memory by uninverting the inverted index. Note that this can however use significant memory."

}

},

"status": 400

}

error.root_cause.reason 中说:在 text 字段上默认 fielddata=false, 需要设置为 true,通过生成正向索引并加载到内存中进行计算;

也就是说需要映射的修改:

PUT /ecommerce/product/_mapping

{

"properties": {

"tags":{

"type": "text",

"fielddata": true

}

}

}

--------------- 响应

{

"acknowledged": true

}

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": { // 可以理解为是分组的意思

"field": "tags"

}

}

},

"size": 0

}

--------------- 响应

{

"took": 146,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0,

"hits": []

},

"aggregations": {

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "fangzhu",

"doc_count": 2

},

{

"key": "meibai",

"doc_count": 2

},

{

"key": "qingxin",

"doc_count": 1

}

]

}

}

}

在请求的时候使用了一个 size=0,这个参数影响响应数据中的 hits.hits 中的数据

- hits.total:总共参与聚合运算的目标数据,这里是 4 条

- hits.hits:这 4条 数据的详细信息(原数据)

- aggregations 聚合的响应

- aggregations.group_by_tags.buckets:桶,也就是聚合的结果

doc_count_error_upper_bound 和 sum_other_doc_count 后面再讲解;

对于 buckets 返回的数据条数也可以通过 size 控制,aggs.group_by_tags.terms.size = n

先搜索,再聚合

需求:对名称中包含 yagao 的商品,计算每个 tag 下的商品数量

GET /ecommerce/product/_search

{

"query": {

"match": {

"name": "yagao"

}

},

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags"

}

}

},

"size": 0

}

很简单,之前的搜索,再加上 aggs 即可

嵌套聚合

需求:计算每个 tag 下的商品平均价格

也就是说:需要先对 tags 进行分组,再计算商品的平均价格

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags"

},

"aggs": {

"avg_by_price": {

"avg": {

"field": "price"

}

}

}

}

},

"size": 0

}

响应

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0,

"hits": []

},

"aggregations": {

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "fangzhu",

"doc_count": 2,

"avg_by_price": {

"value": 27.5

}

},

{

"key": "meibai",

"doc_count": 2,

"avg_by_price": {

"value": 40

}

},

{

"key": "qingxin",

"doc_count": 1,

"avg_by_price": {

"value": 40

}

}

]

}

}

}

在聚合分析后再排序

需求:给上一个例子加上排序,按照计算结果(商品平均价格)降序排列

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags",

"order": {

"avg_by_price": "desc"

}

},

"aggs": {

"avg_by_price": {

"avg": {

"field": "price"

}

}

}

}

},

"size": 0

}

在 terms 中增加 order 属性,并对 avg_by_price 这个计算结果进行排序

说明:为什么不用 java 代码讲解

我们现在全部都是用 es 的 restful api 在学习和讲解 es 的所欲知识点和功能点,但是没有使用一些编程语言去讲解(比如 java),原因有以下:

- es 最重要的 api,让我们进行各种尝试、学习甚至在某些环境下进行使用的 api,就是 restful api。如果你学习不用 es restful api,比如我上来就用 java api 来讲 es,也是可以的,但是你根本就漏掉了 es 知识的一大块,你都不知道它最重要的 restful api 是怎么用的

- 讲知识点,用 es restful api,更加方便,快捷,不用每次都写大量的 java 代码,能加快讲课的效率和速度,更加易于同学们关注es本身的知识和功能的学习

- 我们通常会讲完 es 知识点后,开始详细讲解 java api,如何用 java api 执行各种操作

- 我们每个篇章都会搭配一个项目实战,项目实战是完全基于 java 去开发的真实项目和系统

多次嵌套(下钻操作)

下钻操作:前面的列子,先分组,再聚合计算,这样的操作称为下钻操作(来源没有说)

需求:按照指定的价格区间进行分组,然后再每组内再按照 tags 进行分组,并计算每组内的商品平均价格,并按照平均价格进行降序排列

GET /ecommerce/product/_search

{

"aggs": {

"group_by_price": {

"range": {

"field": "price",

"ranges": [

{

"from": 0,

"to": 20

},

{

"from": 20,

"to": 40

},

{

"from": 40,

"to": 50

}

]

},

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags",

"order": {

"group_by_avg": "desc"

}

},

"aggs": {

"group_by_avg": {

"avg": {

"field": "price"

}

}

}

}

}

}

},

"size": 0

}

响应

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0,

"hits": []

},

"aggregations": {

"group_by_price": {

"buckets": [

{

"key": "0.0-20.0",

"from": 0,

"to": 20,

"doc_count": 0,

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": []

}

},

{

"key": "20.0-40.0",

"from": 20,

"to": 40,

"doc_count": 2,

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "meibai",

"doc_count": 1,

"group_by_avg": {

"value": 30

}

},

{

"key": "fangzhu",

"doc_count": 2,

"group_by_avg": {

"value": 27.5

}

}

]

}

},

{

"key": "40.0-50.0",

"from": 40,

"to": 50,

"doc_count": 1,

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "qingxin",

"doc_count": 1,

"group_by_avg": {

"value": 40

}

}

]

}

}

]

}

}

}

快速上手-商品搜索多种方式

- query string search

- query DSL

- query filter

- full-text search

- phrase search

- highlight search - 真正意义上算不上一种搜索方式

query string search

通俗一点来说,就是以 http get 方式去拼接参数的一种方式

查询所有商品

GET /ecommerce/product/_search

----- 响应

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 2,

"max_score": 1,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "2",

"_score": 1,

"_source": {

"name": "jiajieshi yagao",

"desc": "youxiao fangzhu",

"price": 25,

"producer": "jiajieshi producer",

"tags": [

"fangzhu"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": 1,

"_source": {

"name": "zhonghua yagao",

"desc": "caoben zhiwu",

"price": 40,

"producer": "zhonghua producer",

"tags": [

"qingxin"

]

}

}

]

}

}

- took:耗费了几毫秒

- timed_out:是否超时,这里是没有

_shards:数据拆成了5个分片,所以对于搜索请求,会打到所有的 primary shard(或者是它的某个 replica shard 也可以)- hits.total:查询结果的数量,3个 document

- hits.max_score:score 的含义,就是 document 对于一个 search 的相关度的匹配分数,越相关,就越匹配,分数也高

- hits.hits:包含了匹配搜索的 document 的详细数据

条件查询

搜索名称中带有 “yagao” 的商品,且按价格降序排列:

GET /ecommerce/product/_search?q=name:yagao&sort=price:desc

适用于临时的在命令行使用一些工具,比如 curl,快速的发出请求,来检索想要的信息;但是如果查询请求很复杂,是很难去构建的 在生产环境中,几乎很少使用 query string search

query DSL

DSL:Domain Specified Language,特定领域的语言

http request body:请求体,可以用 json 的格式来构建查询语法,比较方便,可以构建各种复杂的语法,比 query string search 肯定强大多了

查询所有

GET /ecommerce/product/_search

{

"query": {

"match_all": {}

}

}

条件查询

搜索名称中带有 “yagao” 的商品,且按价格降序排列:

GET /ecommerce/product/_search

{

"query": {

"match": {

"name": "yagao"

}

},

"sort": [

{

"price": {

"order": "desc"

}

}

]

}

// price 这里也可以直接简写成 "price":"desc"

----------- 响应

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": null,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": null,

"_source": {

"name": "zhonghua yagao",

"desc": "caoben zhiwu",

"price": 40,

"producer": "zhonghua producer",

"tags": [

"qingxin"

]

},

"sort": [

40

]

}

]

}

}

.... 部分结果

分页查询

总共 3条 商品,假设每页就显示 1条 商品,现在显示第 2页,所以就查出来第 2个 商品

GET /ecommerce/product/_search

{

"query": {

"match_all": {}

},

"from": 1,

"size": 1

}

注意这里的 from:表示是从第几条数据开始,而不是表示 页数

限制返回字段

指定要查询出来商品的名称和价格就可以

GET /ecommerce/product/_search

{

"query": {

"match_all": {}

},

"_source": ["name","price"]

}

---- 响应

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": 1,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "2",

"_score": 1,

"_source": {

"price": 25,

"name": "jiajieshi yagao"

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_score": 1,

"_source": {

"price": 30,

"name": "gaolujie yagao"

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": 1,

"_source": {

"price": 40,

"name": "zhonghua yagao"

}

}

]

}

}

更加适合生产环境的使用,可以构建复杂的查询

query filter

简单说就是在查询后,再进行过滤操作(可以理解为多条件查询)。

搜索商品名称包含 yagao,而且售价大于 25元 的商品

GET /ecommerce/product/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"name": "yagao"

}

}

],

"filter": {

"range": {

"price": {

"gte": 25

}

}

}

}

}

}

full-text search(全文检索)

为了演示这个示例,先增加一条数据

PUT /ecommerce/product/4

{

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

}

查询示例: 查询 producer 中包含 yagao 和 producer 的数据

GET /ecommerce/product/_search

{

"query" : {

"match" : {

"producer" : "yagao producer"

}

}

}

-------- 响应

{

"took": 8,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0.70293105,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "4",

"_score": 0.70293105,

"_source": {

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "1",

"_score": 0.25811607,

"_source": {

"name": "gaolujie yagao",

"desc": "gaoxiao meibai",

"price": 30,

"producer": "gaolujie producer",

"tags": [

"meibai",

"fangzhu"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "3",

"_score": 0.25811607,

"_source": {

"name": "zhonghua yagao",

"desc": "caoben zhiwu",

"price": 40,

"producer": "zhonghua producer",

"tags": [

"qingxin"

]

}

},

{

"_index": "ecommerce",

"_type": "product",

"_id": "2",

"_score": 0.1805489,

"_source": {

"name": "jiajieshi yagao",

"desc": "youxiao fangzhu",

"price": 25,

"producer": "jiajieshi producer",

"tags": [

"fangzhu"

]

}

}

]

}

}

针对这个结果的一些说明:_score:相关度评分

回顾下倒排索引,针对 producer 字段:

producer 这个字段,会先被拆解,建立倒排索引

| 关键词 | ids |

|---|---|

| special | 4 |

| yagao | 4 |

| producer | 1,2,3,4 |

| gaolujie | 1 |

| zhognhua | 3 |

| jiajieshi | 2 |

id 为 4 的评分为什么这么高呢?

仔细观察 搜索目标 “yagao producer” 会被拆解成 yagao和 producer

在倒排索引中出现了 2次 ,而其他数据只出现了一次,所以它的评分是最高的

phrase search(短语搜索)

跟全文检索相对应,相反,全文检索会将输入的搜索串拆解开来,去倒排索引里面去一一匹配,只要能匹配上任意一个拆解后的单词,就可以作为结果返回

phrase search:要求输入的搜索串,必须在指定的字段文本中,完全包含一模一样的,才可以算匹配,才能作为结果返回

GET /ecommerce/product/_search

{

"query" : {

"match_phrase" : {

"producer" : "yagao producer"

}

}

}

---- 响应

{

"took": 10,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 0.70293105,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "4",

"_score": 0.70293105,

"_source": {

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

}

}

]

}

}

highlight search(高亮搜索结果)

GET /ecommerce/product/_search

{

"query" : {

"match_phrase" : {

"producer" : "yagao producer"

}

},

"highlight": {

"fields": {

"producer": {}

}

}

}

----- 响应

{

"took": 61,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 1,

"max_score": 0.70293105,

"hits": [

{

"_index": "ecommerce",

"_type": "product",

"_id": "4",

"_score": 0.70293105,

"_source": {

"name": "special yagao",

"desc": "special meibai",

"price": 50,

"producer": "special yagao producer",

"tags": [

"meibai"

]

},

"highlight": {

"producer": [

"special <em>yagao</em> <em>producer</em>"

]

}

}

]

}

}

增加了 highlight 配置,响应结果中除了目标数据,还返回了 highlight 的信息;

仔细看 _source 中的 producer 和 highlight 中的 producer 文本信息的区别,这一整条信息中被搜索的关键词都被 em 标签包裹了。在显示的时候,可以针对 em 进行高亮样式处理,这就是高亮结果

"producer": "special yagao producer"

"producer": [

"special <em>yagao</em> <em>producer</em>"

]

快速上手-聚合分析

嵌套聚合,下钻分析,聚合分析

计算每个 tag 下的商品数量

语法:

- aggs:聚合函数

- NAME:给这个操作取一个名字

- AGG_TYPE:聚合类型

GET /ecommerce/product/_search

{

"aggs": {

"NAME": {

"AGG_TYPE": {}

}

}

}

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags"

}

}

}

}

------------ 响应

{

"error": {

"root_cause": [

{

"type": "illegal_argument_exception",

"reason": "Fielddata is disabled on text fields by default. Set fielddata=true on [tags] in order to load fielddata in memory by uninverting the inverted index. Note that this can however use significant memory."

}

],

"type": "search_phase_execution_exception",

"reason": "all shards failed",

"phase": "query",

"grouped": true,

"failed_shards": [

{

"shard": 0,

"index": "ecommerce",

"node": "sEvAlYxFRJe598mrSDwUjQ",

"reason": {

"type": "illegal_argument_exception",

"reason": "Fielddata is disabled on text fields by default. Set fielddata=true on [tags] in order to load fielddata in memory by uninverting the inverted index. Note that this can however use significant memory."

}

}

],

"caused_by": {

"type": "illegal_argument_exception",

"reason": "Fielddata is disabled on text fields by default. Set fielddata=true on [tags] in order to load fielddata in memory by uninverting the inverted index. Note that this can however use significant memory."

}

},

"status": 400

}

error.root_cause.reason 中说:在 text 字段上默认 fielddata=false, 需要设置为 true,通过生成正向索引并加载到内存中进行计算;

也就是说需要映射的修改:

PUT /ecommerce/product/_mapping

{

"properties": {

"tags":{

"type": "text",

"fielddata": true

}

}

}

--------------- 响应

{

"acknowledged": true

}

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": { // 可以理解为是分组的意思

"field": "tags"

}

}

},

"size": 0

}

--------------- 响应

{

"took": 146,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0,

"hits": []

},

"aggregations": {

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "fangzhu",

"doc_count": 2

},

{

"key": "meibai",

"doc_count": 2

},

{

"key": "qingxin",

"doc_count": 1

}

]

}

}

}

在请求的时候使用了一个 size=0,这个参数影响响应数据中的 hits.hits 中的数据

- hits.total:总共参与聚合运算的目标数据,这里是 4 条

- hits.hits:这 4条 数据的详细信息(原数据)

- aggregations 聚合的响应

- aggregations.group_by_tags.buckets:桶,也就是聚合的结果

doc_count_error_upper_bound 和 sum_other_doc_count 后面再讲解;

对于 buckets 返回的数据条数也可以通过 size 控制,aggs.group_by_tags.terms.size = n

先搜索,再聚合

需求:对名称中包含 yagao 的商品,计算每个 tag 下的商品数量

GET /ecommerce/product/_search

{

"query": {

"match": {

"name": "yagao"

}

},

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags"

}

}

},

"size": 0

}

很简单,之前的搜索,再加上 aggs 即可

嵌套聚合

需求:计算每个 tag 下的商品平均价格

也就是说:需要先对 tags 进行分组,再计算商品的平均价格

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags"

},

"aggs": {

"avg_by_price": {

"avg": {

"field": "price"

}

}

}

}

},

"size": 0

}

响应

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0,

"hits": []

},

"aggregations": {

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "fangzhu",

"doc_count": 2,

"avg_by_price": {

"value": 27.5

}

},

{

"key": "meibai",

"doc_count": 2,

"avg_by_price": {

"value": 40

}

},

{

"key": "qingxin",

"doc_count": 1,

"avg_by_price": {

"value": 40

}

}

]

}

}

}

在聚合分析后再排序

需求:给上一个例子加上排序,按照计算结果(商品平均价格)降序排列

GET /ecommerce/product/_search

{

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags",

"order": {

"avg_by_price": "desc"

}

},

"aggs": {

"avg_by_price": {

"avg": {

"field": "price"

}

}

}

}

},

"size": 0

}

在 terms 中增加 order 属性,并对 avg_by_price 这个计算结果进行排序

说明:为什么不用 java 代码讲解

我们现在全部都是用 es 的 restful api 在学习和讲解 es 的所欲知识点和功能点,但是没有使用一些编程语言去讲解(比如 java),原因有以下:

- es 最重要的 api,让我们进行各种尝试、学习甚至在某些环境下进行使用的 api,就是 restful api。如果你学习不用 es restful api,比如我上来就用 java api 来讲 es,也是可以的,但是你根本就漏掉了 es 知识的一大块,你都不知道它最重要的 restful api 是怎么用的

- 讲知识点,用 es restful api,更加方便,快捷,不用每次都写大量的 java 代码,能加快讲课的效率和速度,更加易于同学们关注es本身的知识和功能的学习

- 我们通常会讲完 es 知识点后,开始详细讲解 java api,如何用 java api 执行各种操作

- 我们每个篇章都会搭配一个项目实战,项目实战是完全基于 java 去开发的真实项目和系统

多次嵌套(下钻操作)

下钻操作:前面的列子,先分组,再聚合计算,这样的操作称为下钻操作(来源没有说)

需求:按照指定的价格区间进行分组,然后再每组内再按照 tags 进行分组,并计算每组内的商品平均价格,并按照平均价格进行降序排列

GET /ecommerce/product/_search

{

"aggs": {

"group_by_price": {

"range": {

"field": "price",

"ranges": [

{

"from": 0,

"to": 20

},

{

"from": 20,

"to": 40

},

{

"from": 40,

"to": 50

}

]

},

"aggs": {

"group_by_tags": {

"terms": {

"field": "tags",

"order": {

"group_by_avg": "desc"

}

},

"aggs": {

"group_by_avg": {

"avg": {

"field": "price"

}

}

}

}

}

}

},

"size": 0

}

响应

{

"took": 3,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 4,

"max_score": 0,

"hits": []

},

"aggregations": {

"group_by_price": {

"buckets": [

{

"key": "0.0-20.0",

"from": 0,

"to": 20,

"doc_count": 0,

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": []

}

},

{

"key": "20.0-40.0",

"from": 20,

"to": 40,

"doc_count": 2,

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "meibai",

"doc_count": 1,

"group_by_avg": {

"value": 30

}

},

{

"key": "fangzhu",

"doc_count": 2,

"group_by_avg": {

"value": 27.5

}

}

]

}

},

{

"key": "40.0-50.0",

"from": 40,

"to": 50,

"doc_count": 1,

"group_by_tags": {

"doc_count_error_upper_bound": 0,

"sum_other_doc_count": 0,

"buckets": [

{

"key": "qingxin",

"doc_count": 1,

"group_by_avg": {

"value": 40

}

}

]

}

}

]

}

}

}

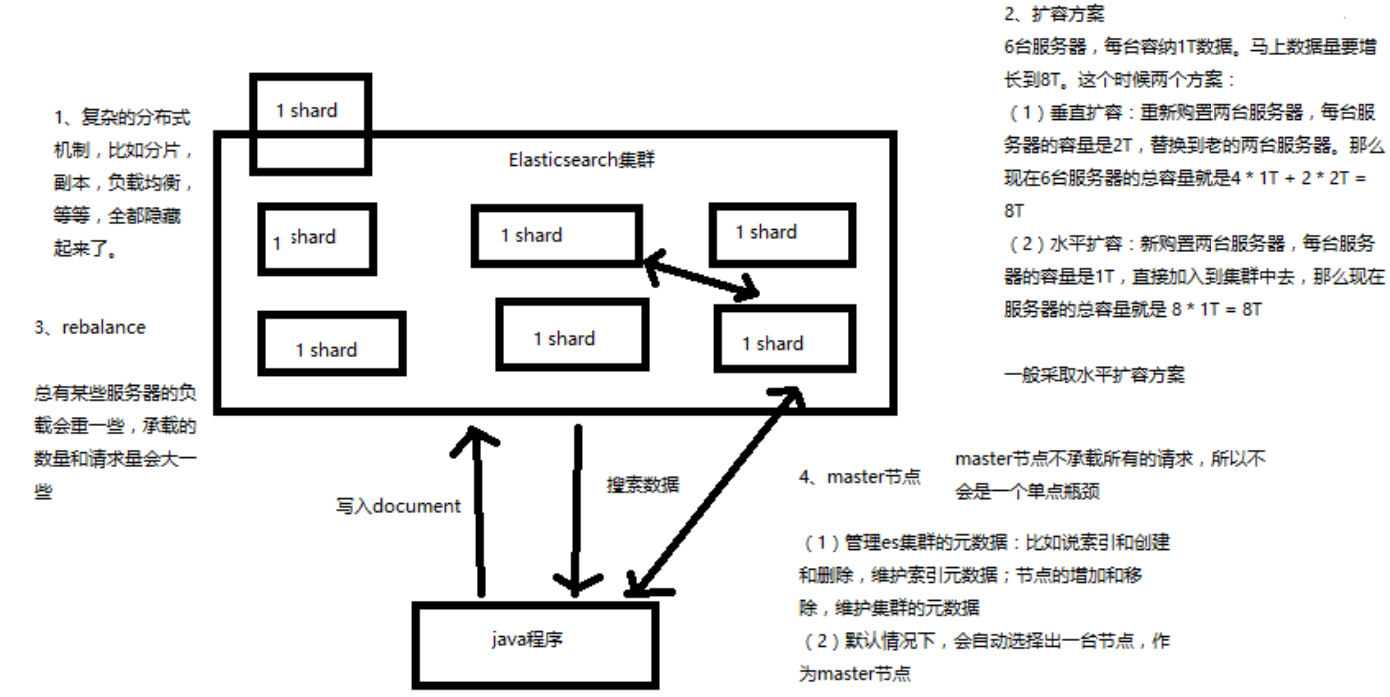

基础分布式架构剖析

- Elasticsearch 对复杂分布式机制的透明隐藏特性

- Elasticsearch 的垂直扩容与水平扩容

- 增减或减少节点时的数据 rebalance

- master 节点

- 节点对等的分布式架构

Elasticsearch 对复杂分布式机制的透明隐藏特性

Elasticsearch 是一套分布式的系统,分布式是为了应对大数据量 隐藏了复杂的分布式机制

-

分片机制

我们之前随随便便就将一些 document 插入到 es 集群中去了,我们有没有关心过数据怎么进行分片的,数据到哪个 shard 中去

-

cluster discovery(集群发现机制)

我们之前在做那个集群 status 从 yellow 转 green 的实验里,直接启动了第二个 es 进程,那个进程作为一个 node 自动就发现了集群,并且加入了进去,还接受了部分数据 (replica shard)

-

shard 负载均衡

举例,假设现在有 3个 节点,总共有 25个 shard 要分配到 3个节点上去,es 会自动进行均匀分配,以保持每个节点的均衡的读写负载请求

shard 副本,请求路由,集群扩容,shard 重分配

Elasticsearch 的垂直扩容与水平扩容

-

垂直扩容

采购更强大的服务器,成本非常高昂,而且会有瓶颈,假设世界上最强大的服务器容量就是 10T,但是当你的总数据量达到 5000T 的时候,你要采购多少台最强大的服务器啊

-

水平扩容

业界经常采用的方案,采购越来越多的普通服务器,性能比较一般,但是很多普通服务器组织在一起,就能构成强大的计算和存储能力

假设服务器的价格如下:

-

普通服务器:1T,1万,100万

-

强大服务器:10T,50万,500万

扩容对应用程序的透明性

增减或减少节点时的数据 rebalance

目的:保持负载均衡

当有新节点加进来的时候,一些 shard 上承担数据量不平衡的时候,es 会自动做 rebalance 操作,将这些数据分担一部分到新机器上去

master 节点

管理 es 集群的元数据,默认情况下回自动选举出一台节点,作为 master 节点;

- 创建或删除索引

- 增加或删除节点

master 节点不承载所有的请求,所以不存在单节点瓶颈,那么这就涉及到一个概念:节点对等

节点对等的分布式架构

- 节点对等,每个节点都能接收所有的请求

- 自动请求路由

- 响应收集

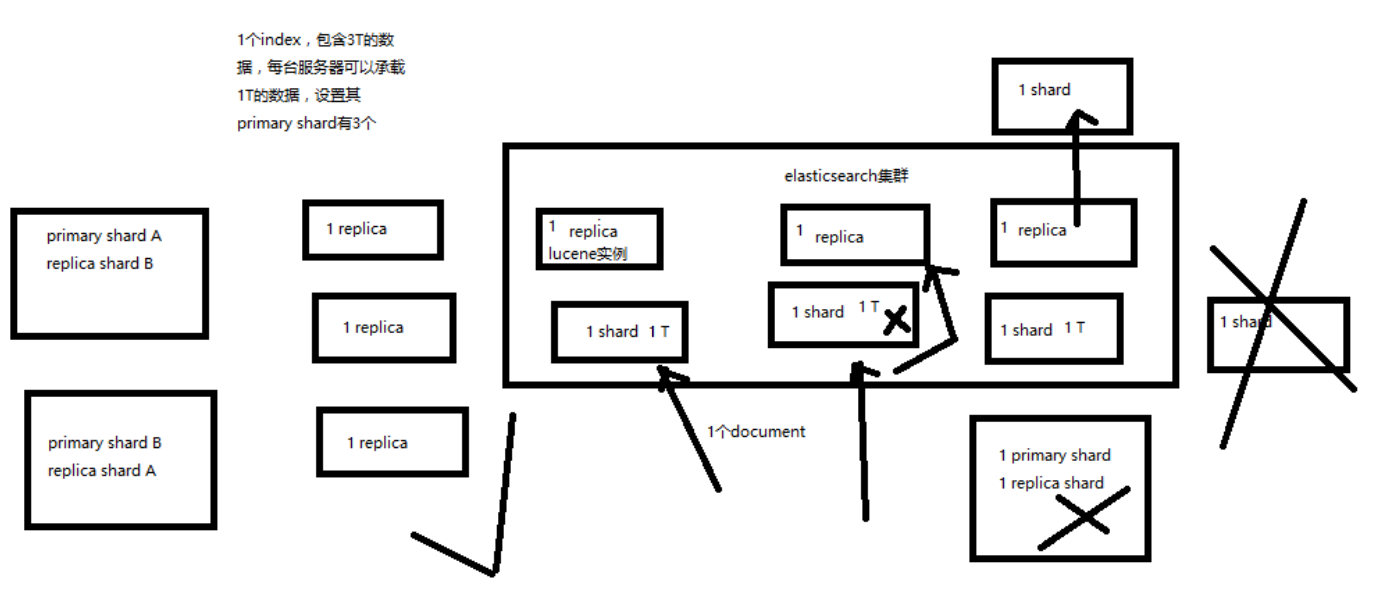

单节点 shard & replica 机制

- shard & replica 机制再次梳理

- 图解单 node 环境下创建 index 是什么样子的

shard & replica 机制再次梳理

- index 包含多个 shard

- 每个 shard 都是一个最小工作单元,承载部分数据,是一个 lucene 实例,完整的建立索引和处理请求的能力

- 增减节点时,shard 会自动在 nodes 中负载均衡

- primary shard 和 replica shard,每个 document 肯定只存在于某一个 primary shard 以及其对应的 replica shard 中,不可能存在于多个 primary shard

- replica shard 是 primary shard 的副本,负责容错,以及承担读请求负载

- primary shard 的数量在创建索引的时候就固定了,replica shard 的数量可以随时修改

- primary shard 的默认数量是 5,replica 默认是 1,默认有 10个 shard,5个 primary shard,5个 replica shard

- primary shard 不能和自己的 replica shard 放在同一个节点上(否则节点宕机,primary shard 和副本都丢失,起不到容错的作用),但是可以和其他 primary shard 的 replica shard 放在同一个节点上

对于 shard 和 replica 的总结:

- pri : primary shard

- rep : replica shard

- 所以一个 es 实例叫做 shard

- rep 的配置是针对于每个 pri 的副本个数

如:test 的 pri=2,rep=2;那么将产生 2个 primary shard 和 4个 replica shard

图解单 node 环境下创建 index 是什么样子的

- 单 node 环境下,创建一个 index,有 3个 primary shard,3个 replica shard

- 集群 status 是 yellow

- 这个时候,只会将 3个 primary shard 分配到仅有的一个 node 上去,另外 3个 replica shard 是无法分配的

- 集群可以正常工作,但是一旦出现节点宕机,数据全部丢失,而且集群不可用,无法承接任何请求

PUT /test_index

{

"settings": {

"number_of_shards": 3,

"number_of_replicas": 1

}

}

GET /_cat/health?v

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1546323256 14:14:16 elasticsearch yellow 1 1 9 9 0 0 9 0 - 50.0%

GET /_cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open ecommerce ZpGp7bIBQBaZFk9SYmbJVQ 5 1 4 0 22.2kb 22.2kb

yellow open test_index g4RJx2v8TXK95LdwlhRx5A 3 1 0 0 390b 390b

yellow open .kibana id1SV_oGSjyGosKxeJApww 1 1 1 0 3.1kb 3.1kb

来计算下是否是正确的:这个单节点集群有 9个 shards ,9个 pri,有 9个 unassign;

再来统计下这 3个 索引一共有 9个 pri,每个索引都有 1个 rep,那么一共会产生 9个 rep。 9个 unassign 全是这 9个 rep,因为 同一份数据的 pri 和 rep 不能在一台机器上;

也就是说,一共会产生 18 个 shard;这里只有 9个,还有 9个没有被分配

而 pri 的数据却可以再同一台机器上,这里创建的 3个 pri 都会在这个 node 上存在

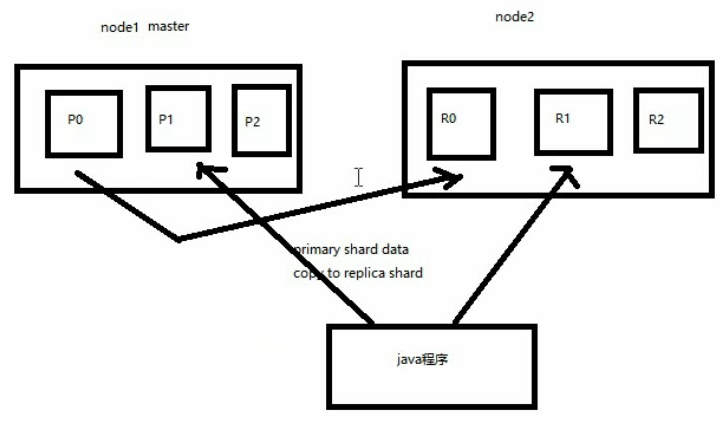

2 节点 shard & replica 机制

图解 2个 node 环境下 replica shard 是如何分配的

- replica shard 分配:3个 primary shard,3个 replica shard,1 node

- primary —> replica 同步

- 读请求:primary/replica

再启动一个 es 实例后,再次查看:

health status 变成了 green; shards 变成了 18

GET /_cat/health?v

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1546324075 14:27:55 elasticsearch green 2 2 18 9 0 0 0 0 - 100.0%

indices 是没有任何变化的

GET /_cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open ecommerce ZpGp7bIBQBaZFk9SYmbJVQ 5 1 4 0 44.5kb 22.2kb

green open test_index g4RJx2v8TXK95LdwlhRx5A 3 1 0 0 780b 390b

green open .kibana id1SV_oGSjyGosKxeJApww 1 1 1 0 6.3kb 3.1kb

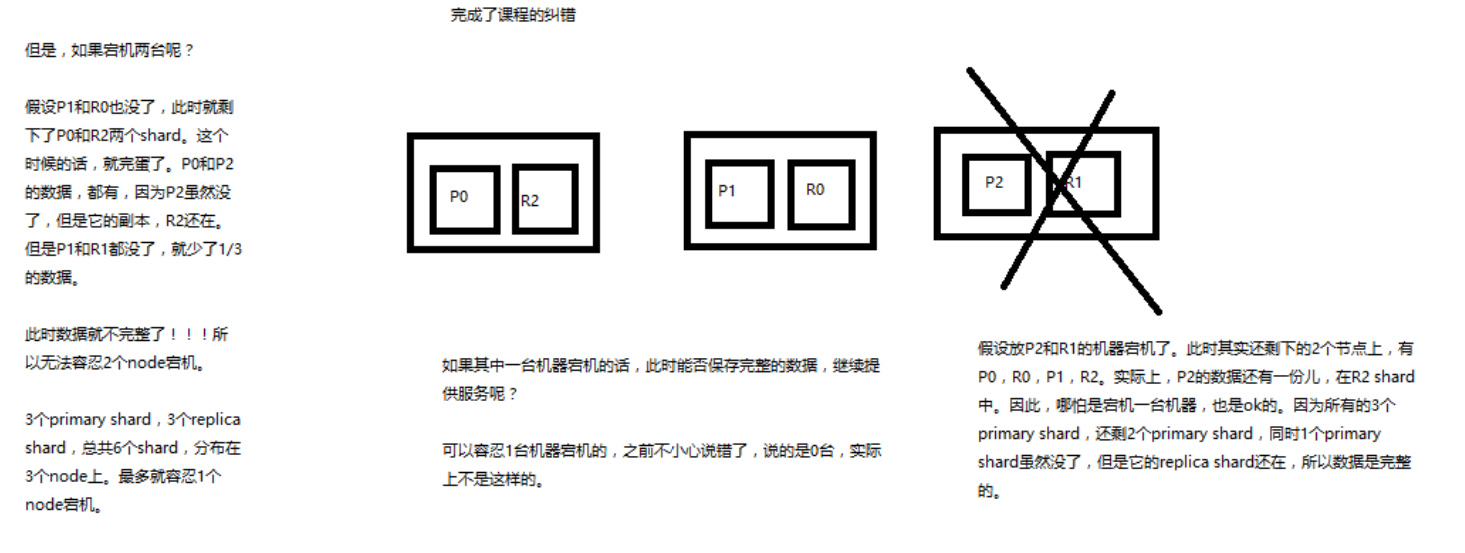

横向扩容机制浅析

图解横向扩容过程,如何超出扩容极限,以及如何提升容错性

-

primary&replica 自动负载均衡,6个shard,3 primary,3 replica

-

每个 node 有更少的 shard,IO/CPU/Memory 资源给每个 shard 分配更多,每个 shard 性能更好

-

扩容的极限,6个 shard(3 primary,3 replica),最多扩容到 6台 机器,每个 shard 可以占用单台服务器的所有资源,性能最好

-

超出扩容极限,动态修改 replica 数量,9个 shard(3primary,6 replica),扩容到 9台 机器,比 3台 机器时,拥有 3倍 的读吞吐量

-

3台 机器下,9个 shard(3 primary,6 replica),资源更少,但是容错性更好,最多容纳 2台机器宕机,6个 shard 只能容纳 1台 机器宕机

-

这里的这些知识点,你综合起来看,就是说,一方面告诉你扩容的原理,怎么扩容,怎么提升系统整体吞吐量;另一方面要考虑到系统的容错性,怎么保证提高容错性,让尽可能多的服务器宕机,保证数据不丢失

自己总结:

- 横向扩容简单,只需要增加 replica 的数量即可,es 会完成副本的同步

- rep 会可接受读请求,分担 master 的压力

- 当副本在每台机器上都存在的时候,容错性增加,但是空间增多,这就是以空间换取性能和容错性

纠错

前面的讲解中,有一个地方说错了:3台 机器,6个 shard,不能有机器宕机;这个说错了。

看下图:就是一个排列的问题,3 台机器上怎么才能保证至少 2台机器上至少存在一份数据。这个是可以做到的

容错机制浅析

图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复

还是使用上一章的例子,9 shard,3 node 来说明 es 的一个最基本的容错机制

- master node 宕机,自动 master 选举,red

- replica容错:新 master 将 replica 提升为 primary shard,yellow

- 重启宕机 node,master copy replica 到该 node,使用原有的 shard 并同步宕机后的修改,green

初步解析 document 的核心元数据

初步解析 document 的核心元数据以及图解剖析 index 创建反例

_index 元数据_type元数据_id元数据

插入一条数据查看返回来的元数据信息

PUT /test_index/test_type/1

{

"test_content": "test test"

}

------------ 响应

{

"_index": "test_index",

"_type": "test_type",

"_id": "1",

"_version": 1,

"result": "created",

"_shards": {

"total": 2,

"successful": 2,

"failed": 0

},

"created": true

}

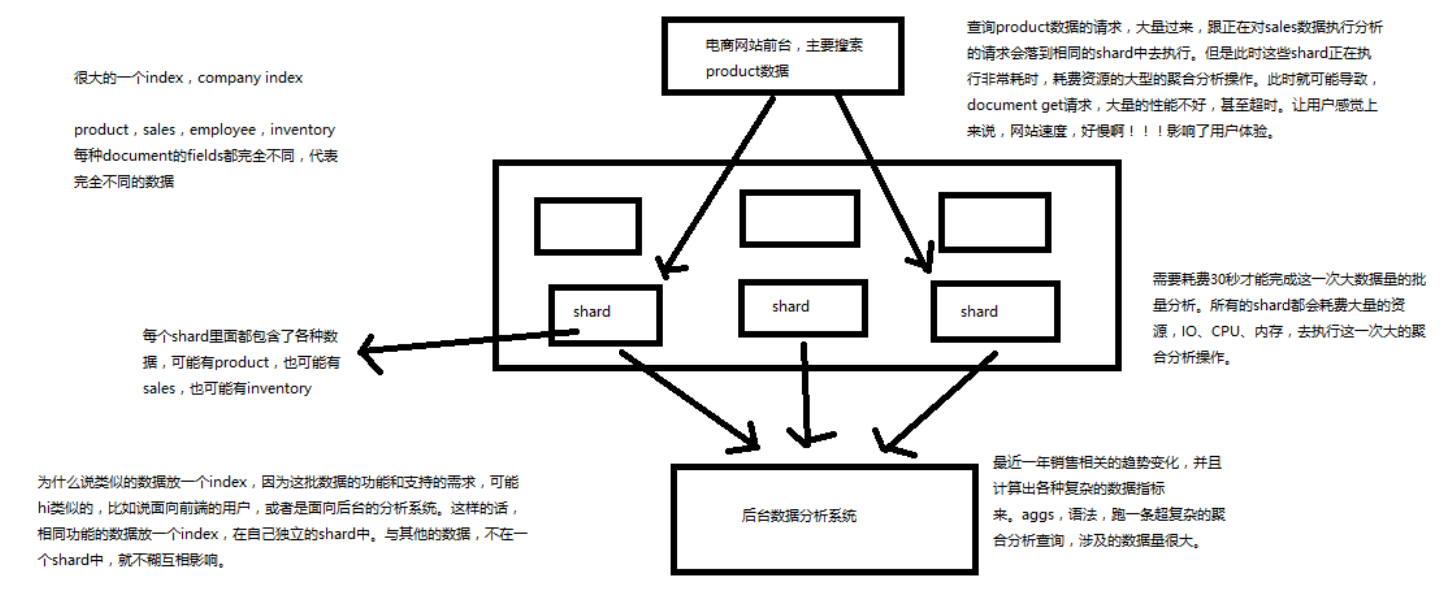

_index 元数据

简单说:可以看成是 mysql 中的一个库

- 代表一个 document 存放在哪个 index 中

-

类似的数据放在一个索引,非类似的数据放不同索引

product index(包含了所有的商品),

sales index(包含了所有的商品销售数据),

inventory index(包含了所有库存相关的数据)。

如果你把 product,sales,human resource(employee),全都放在一个大的 index 里面,比如说 company index,不合适的。

-

index 中包含了很多类似的 document

类似是什么意思?

其实指的就是说,这些 document 的 fields 很大一部分是相同的,你说你放了 3个 document,每个 document 的 fields 都完全不一样,这就不是类似了,就不太适合放到一个index里面去了。 大致上的意思就是:在查询不相关数据的时候,相同 index 下所占用的资源是共享的,不相关的资源访问的时候就会影响它的访问(当然是在数据量很大的情况下容易感受到这种性能情况)

- 索引名称必须是小写的,不能用下划线开头,不能包含逗号;如:product,website,blog 都可以

下面图解不类似的情况下出现的性能问题

_type元数据

简单说:可以看成是 mysql 一个库中的表

- 代表 document 属于 index 中的哪个类别(type)

-

一个索引通常会划分为多个 type,逻辑上对 index 中有些许不同的几类数据进行分类

因为一批相同的数据,可能有很多相同的 fields,但是还是可能会有一些轻微的不同,可能会有少数 fields 是不一样的,举个例子,就比如说,商品,可能划分为电子商品,生鲜商品,日化商品,等等。

- type 名称可以是大写或者小写,但是同时不能用下划线开头,不能包含逗号

_id元数据

- 代表 document 的唯一标识,与 index 和 type 一起,可以唯一标识和定位一个 document

- 我们可以手动指定 document 的 id(put /index/type/id),也可以不指定,由 es 自动为我们创建一个 id

分布式文档-document id

- 手动指定 document id

- 自动生成 document id

手动指定 document id

根据应用情况来说,是否满足手动指定document id的前提:

一般来说,是从某些其他的系统中,导入一些数据到es时,会采取这种方式, 就是使用系统中已有数据的唯一标识,作为 es 中 document 的 id。

举个例子,比如说,我们现在在开发一个电商网站,做搜索功能,或者是OA系统,做员工检索功能。 这个时候,数据首先会在网站系统或者 IT 系统内部的数据库中,会先有一份, 此时就肯定会有一个数据库的 primary key(自增长,UUID,或者是业务编号)。 如果将数据导入到 es 中,此时就比较适合采用数据在数据库中已有的 primary key。

如果说,我们是在做一个系统,这个系统主要的数据存储就是es一种,也就是说, 数据产生出来以后,可能就没有 id,直接就放 es 一个存储,那么这个时候, 可能就不太适合说手动指定 document id 的形式了,因为你也不知道id应该是什么, 此时可以采取下面要讲解的让 es 自动生成 id 的方式。

手动指定的语法就是前面用过的 put 方式

PUT /test_index/test_type/1

{

"test_content": "test test"

}

自动生成 document id

语法很简单,把 put 改成 post,不指定 id

POST /test_index/test_type

{

"test_content": "test test"

}

---------- 响应

{

"_index": "test_index",

"_type": "test_type",

"_id": "AWgPGM7zE8HO-7Ks86bu",

"_version": 1,

"result": "created",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"created": true

}

可以看到返回了一串很长的 id

自动生成的 ID 的特点:

- 长度为 20 个字符

- URL 安全:经过了 base64编码的 id,可以放在 url 中传递

- GUID 方式,分布式系统并行生成时不可能发生冲突

_souce元数据 _souce元数据- 定制返回结果字段

_souce 元数据

添加一条数据

PUT /test_index/test_type/1

{

"test_content": "test test",

"test_content2": "test test2"

}

获取这一条数据

GET /test_index/test_type/1

-------- 响应

{

"_index": "test_index",

"_type": "test_type",

"_id": "1",

"_version": 2,

"found": true,

"_source": {

"test_content": "test test",

"test_content2": "test test2"

}

}

其中响应的 _source 中的就是我们在新增数据的时候提交的数据

定制返回结果字段

// 多个字段用逗号分隔,就能返回指定的字段了

GET /test_index/test_type/1?_source=test_content2,test_content

dsl 语法,只有一个字段的时候,可以直接写 "_source": "test_content"

GET /test_index/test_type/_search

{

"query": {

"match": {

"_id": "1"

}

},

"_source": ["test_content","test_content2"]

}

CRUD、强制操作

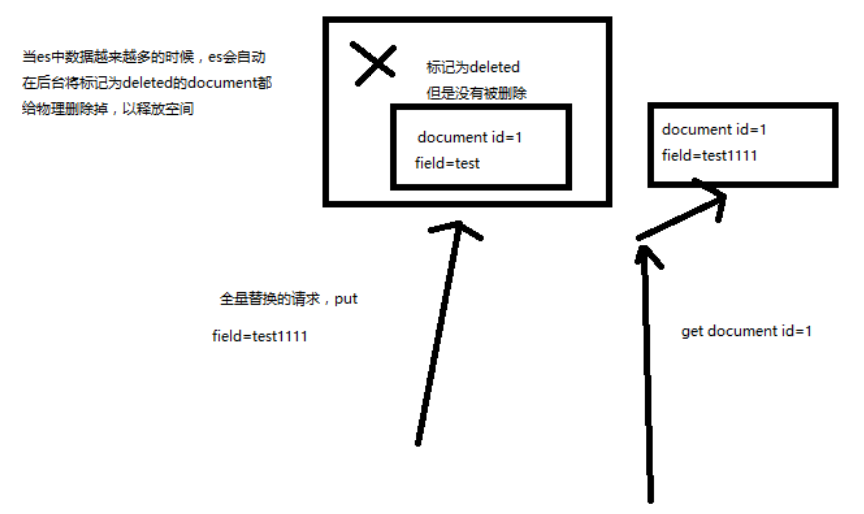

document 的全量替换、强制创建以及图解 lazy delete 机制

- document 的全量替换

- document 的强制创建

- document 的删除

document 的全量替换

-

语法与创建文档是一样的

如果 document id 不存在,那么就是创建;如果 document id 已经存在,那么就是全量替换操作,替换 document 的 json 串内容

-

document 是不可变的

如果要修改 document 的内容,第一种方式就是全量替换,直接对 document 重新建立索引,替换里面所有的内容

-

es 会将老的 document 标记为 deleted

然后新增我们给定的一个 document,当我们创建越来越多的 document 的时候,es 会在适当的时机在后台自动删除标记为 deleted 的 document

document 的强制创建

老师讲解的是:

- 创建文档与全量替换的语法是一样的,有时我们只是想新建文档,不想替换文档,如果强制进行创建呢?

PUT /index/type/id?op_type=create,PUT /index/type/id/_create

PUT /test_index/test_type/1/_create

{

"test_content": "test test",

"test_content2": "test test23"

}

PUT /test_index/test_type/1?op_type=create

{

"test_content": "test test",

"test_content2": "test test23",

"test_content3": "test test23"

}

document 的强制创建(正确的讲解)

我觉得上面讲解得有问题:

如果已经存在一个 document id 为 1 的时候,再使用以上语法创建,会报错;

会告诉你已经存在了;

那么这个的含义应该是:当你不想要覆盖操作的时候,可以使用 create 显示指定不要覆盖,而是报错

{

"error": {

"root_cause": [

{

"type": "version_conflict_engine_exception",

"reason": "[test_type][1]: version conflict, document already exists (current version [3])",

"index_uuid": "g4RJx2v8TXK95LdwlhRx5A",

"shard": "2",

"index": "test_index"

}

],

"type": "version_conflict_engine_exception",

"reason": "[test_type][1]: version conflict, document already exists (current version [3])",

"index_uuid": "g4RJx2v8TXK95LdwlhRx5A",

"shard": "2",

"index": "test_index"

},

"status": 409

}

document 的删除

DELETE /test_index/test_type/1

这里的删除和更新操作类似,也是一个 lazy delete 机制

并发更新冲突

本章记录 5 个小结的笔记;他们都是讲解如何解决更新冲突

- 18-深度图解剖析 Elasticsearch 并发冲突问题

- 19-深度图解剖析悲观锁与乐观锁两种并发控制方案

- 20-图解 Elasticsearch 内部基于

_version如何进行乐观锁并发控制 - 21-上机动手实战演练基于

_version进行乐观锁并发控制 - 22-上机动手实战演练基于 external version 进行乐观锁并发控制

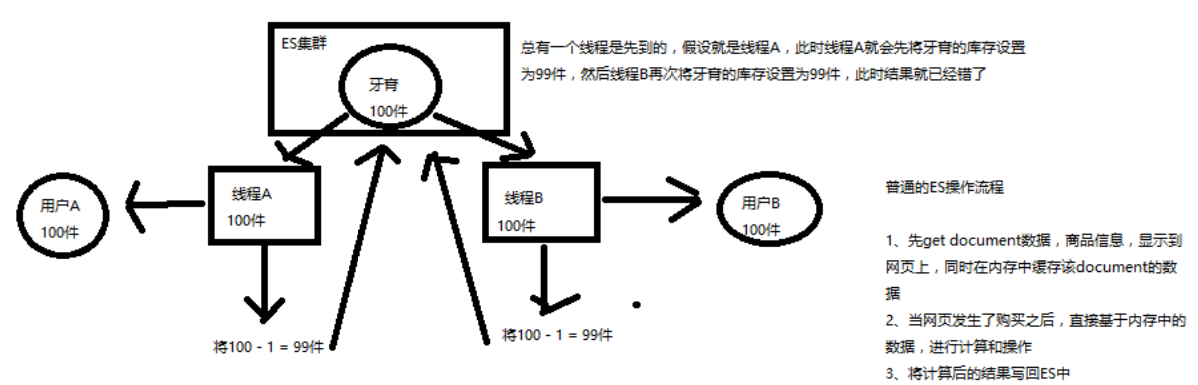

深度图解剖析 Elasticsearch 并发冲突问题

并发修改这个在很多数据库中都存在问题,一个场景:

一个商品库存是 2 个,一共 3 个人购买,3个人同时下单,如果没有并发控制,那么久会超卖。

为什么会超卖,这个就太基础了,不记录笔记了;

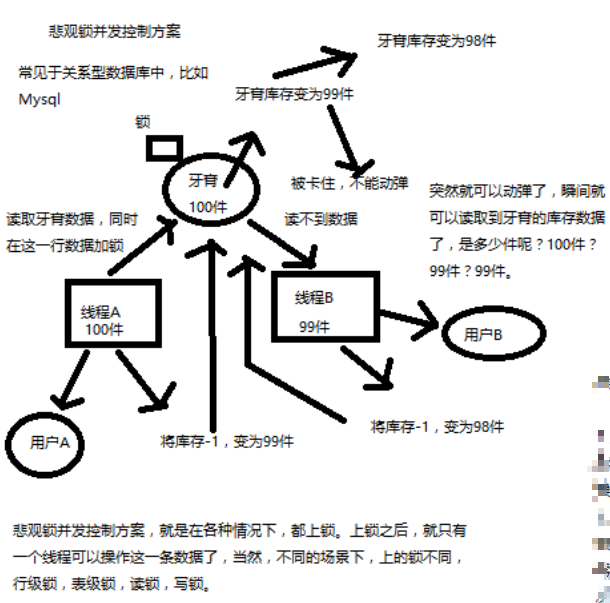

深度图解剖析悲观锁与乐观锁两种并发控制方案

悲观锁

悲观锁:通过锁定某一条数据(独占),进行解决并发控制

乐观锁

乐观锁:不加锁,通过条件(版本号)来更新数据;

大致流程:

- version = 1; 期望版本等于 1 的时候更新数据

- 如果此时数据库中的数据版本变为了 2,那么此时不更新

- 再次获取数据的版本号,再重复第 1、2步。

::: tip 关于条件更新:是需要依赖数据库的按指定条件更新的功能,而不是自行在程序中处理 :::

优缺点

悲观锁:

优点:

- 方便,直接加锁

- 对程序透明,不需要做额外操作

缺点:并发能力很低,同一时间只能有一条线程操作数据

乐观锁:

优点

- 并发能力很高,不给数据加锁

- 大量线程并发操作

缺点:

- 麻烦,每次更新都要对比版本号

- 可能多次加载数据,再次修改

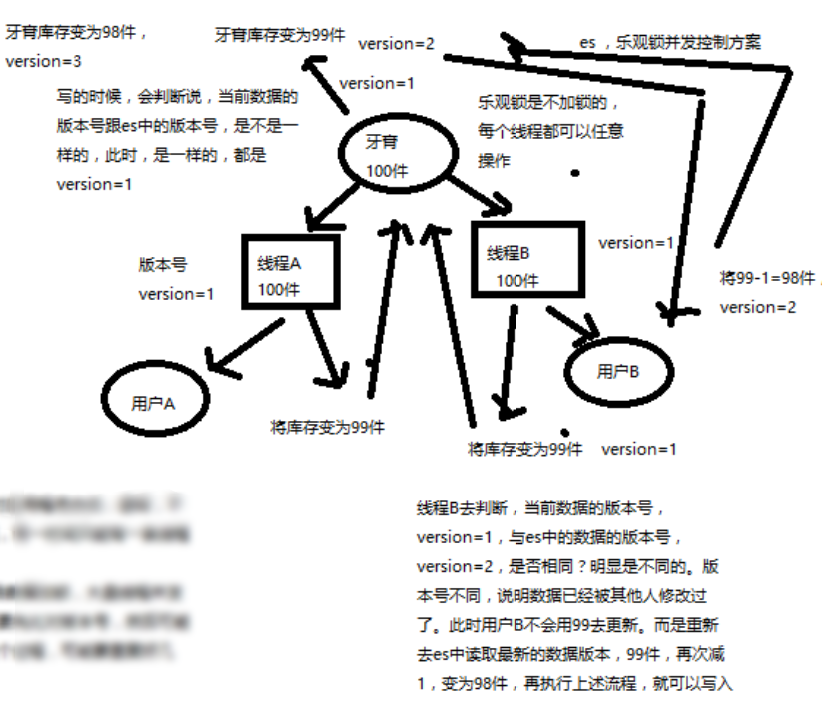

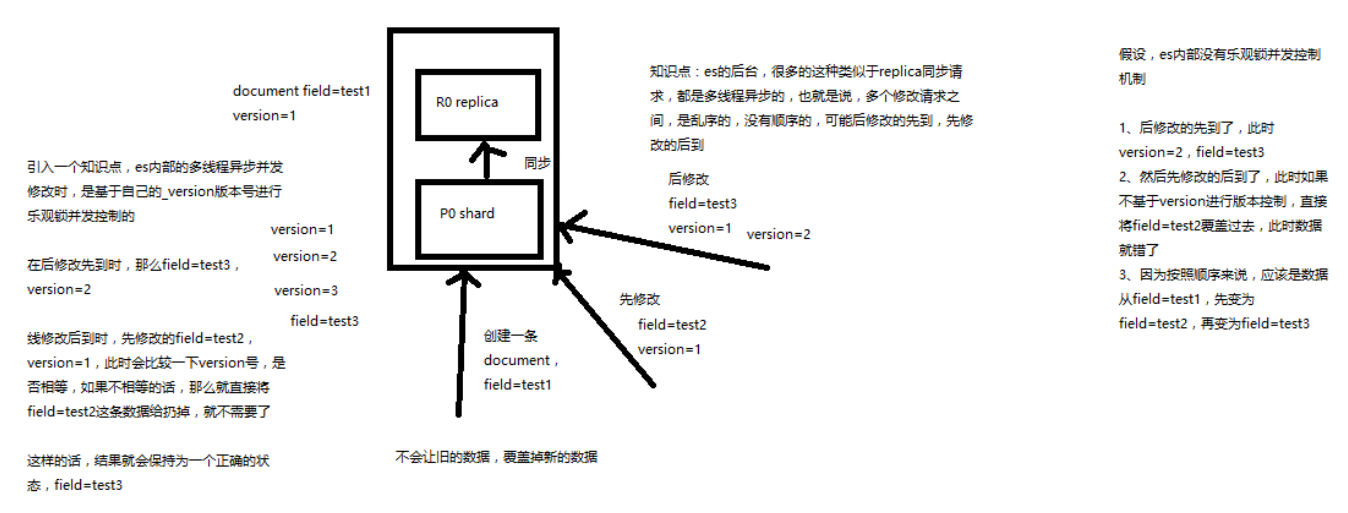

图解 Elasticsearch 内部基于 _version 如何进行乐观锁并发控制

前面说的是概念,现在说说 es 内部对于并发修改是如何控制的;

_version 的产生:在创建的时候值为 0 ,在修改和删除的时候回自动增加 1

es 内部是基于 _version 版本号控制。

对于上图流程总结:

- 假设 a 操作修改条件是 version = 1;

- 假设 b 操作修改条件也是 version = 1;

- 那一条数据被先执行则生效,后到的则被丢弃

反正这一小节还是没有解决我心中的疑惑, es 到底是怎么实现并发版本的控制的,如果不加锁,怎么保证获取数据,再修改版本号的原子操作?

对于 cas 在同一台机器中是硬件保证的,那么对于 es 这种分布式的呢?我没有明白

实战 _version 进行乐观锁并发控制

实战的步骤也很简单,利用 es api 进行操作;

-

先添加一条数据,此时 version = 1

PUT /test_index/test_type/7 { "test_field": "test test" } -

带上 version = 1 更新数据,客户端1 更新成功

PUT /test_index/test_type/7?version=1 { "test_field": "test client 1" } -

带上 version = 1 更新数据

PUT /test_index/test_type/7?version=1 { "test_field": "test client 2" }因为客户端1 已结更新成功,那么此时再用版本1 更新将会返回失败信息

{ "error": { "root_cause": [ { "type": "version_conflict_engine_exception", "reason": "[test_type][7]: version conflict, current version [2] is different than the one provided [1]", "index_uuid": "g4RJx2v8TXK95LdwlhRx5A", "shard": "0", "index": "test_index" } ], "type": "version_conflict_engine_exception", "reason": "[test_type][7]: version conflict, current version [2] is different than the one provided [1]", "index_uuid": "g4RJx2v8TXK95LdwlhRx5A", "shard": "0", "index": "test_index" }, "status": 409 }那么想要这条数据更新成功怎么办呢? 需要获取到这条数据的版本号,再带上新的版本号去更新即可

那么此次更新步骤就是 jdk 中的 cas,在并发频繁的时候,该步骤可能要尝试好多次才能更新进去

实战 external version 进行乐观锁并发控

external version 是什么?

- 这个值不是 es 中的

_version,是你自己维护的(比如 mysql 中数据的版本) - 但是提供的值是与 es 中的

_version比较的 - 提供的值必须比

_vesion的值大,才能更新成功

::: tip 内部版本号并发控制策略是提供的版本号必须一致才能更新成功 :::

语法

?version

?version=1&version_type=externalon=1

只是多了一个 type ,其他的都是一致的,除了上面说的值比较有区别外

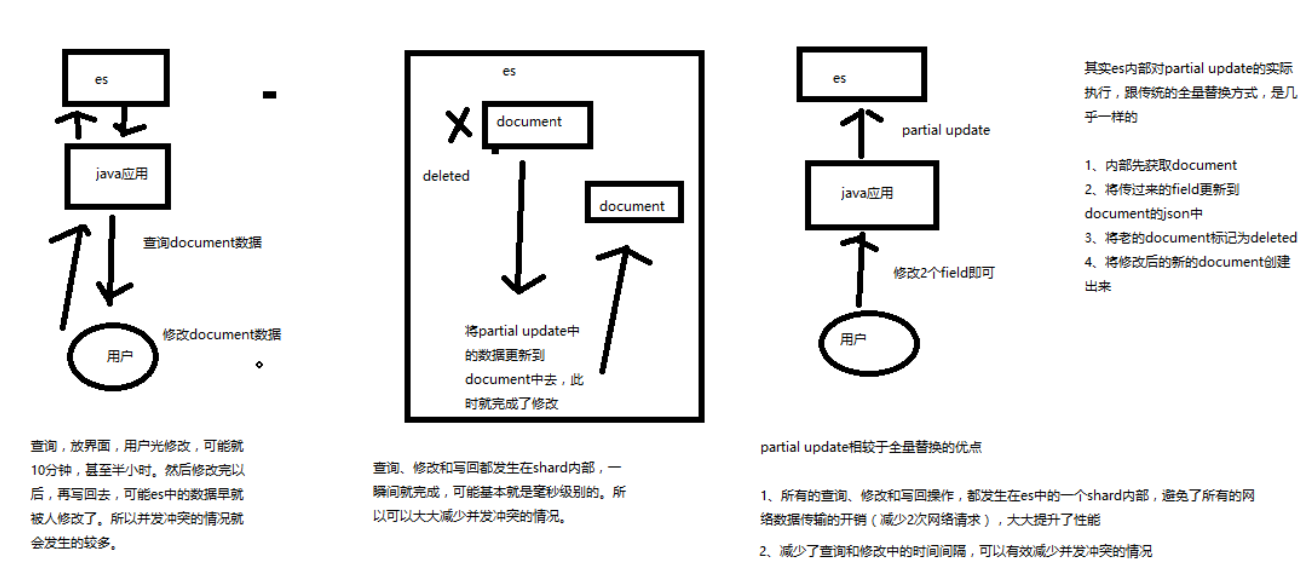

partial update

本章共记录原教程的 3 个章节,他们都是关于 partial update 的知识

- 第23节:图解 partial update 实现原理以及动手实战演练

- 第24节:上机动手实战演练基于 groovy 脚本进行 partial update

- 第25节:图解 partial update 乐观锁并发控制原理以及相关操作讲解

图解实现原理与实战演练

什么是 partial update?

PUT /index/type/id,创建文档&替换文档,就是一样的语法

一般对应到应用程序中,每次的执行流程基本是这样的:

- 应用程序先发起一个 get 请求,获取到 document,展示到前台界面,供用户查看和修改

- 用户在前台界面修改数据,发送到后台

- 后台代码,会将用户修改的数据在内存中进行执行,然后封装好修改后的全量数据

- 然后发送 PUT 请求,到 es 中,进行全量替换

- es 将老的 document 标记为 deleted,然后重新创建一个新的 document

partial update 语法

post /index/type/id/_update

{

"doc": {

"要修改的少数几个field即可,不需要全量的数据"

}

}

看起来,好像就比较方便了,每次就传递少数几个发生修改的 field 即可,不需要将全量的 document 数据发送过去

图解 partial update 实现原理以及其优点

partial update,看起来很方便的操作,实际内部的原理是什么样子的,然后它的优点是什么

要明白在原理上与全量替换方法几乎一致:

- 内部先获取 document

- 将传递过来的 field 更新到 document 的 json 中

- 将老的 document 标记为 deleted

- 将修改后的新的 document 创建出来

partial update 相较于全量替换的优点:

-

所有的查询、修改和协会操作,都发生在 es 中的一个 shard 内部

避免网络数据传输的开销(减少两次网络请求,查询写回),大大提升性能

-

减少了查询和修改中的间隔,可有效减少并发冲突情况

先获取数据,再修改,这中间可能会存在号几分钟的人工填写时间, 如果存在并发,则需要多次获取版本号再写入的操作。 而这里在一个 shard 内部就完成了这些

演练

PUT /test_index/test_type/10

{

"test_field1": "test1",

"test_field2": "test2"

}

POST /test_index/test_type/10/_update

{

"doc": {

"test_field2": "updated test2"

}

}

groovy 语法实现

es,其实是有个内置的脚本支持的,可以基于 groovy 脚本实现各种各样的复杂操作

本节基于 groovy 脚本,简单讲解如何执行 partial update

es scripting module,我们会在高手进阶篇去讲解,这里就只是初步讲解一下

内置脚本

什么是内置脚本? 语法内容通过 api 发送

新增一条数据,通过这条数据的来讲解怎么操作

PUT /test_index/test_type/11

{

"num": 0,

"tags": []

}

自增操作

POST /test_index/test_type/11/_update

{

"script": "ctx._source.num+=1"

}

----- 响应

{

"_index": "test_index",

"_type": "test_type",

"_id": "11",

"_version": 2,

"result": "updated",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

}

}

数组操作

POST /test_index/test_type/11/_update

{

"script": "ctx._source.tags.add('xx')"

}

对于这个脚本的语法这里没有说从哪里来的。

外置脚本

什么是外置脚本? 语法内容存储在 /config/scripts 目录中的文件中,通过 api 指定哪一个文件获取文件中的脚本内容

test-add-tags.groovy

ctx._source.tags+=new_tag

POST /test_index/test_type/11/_update

{

"script": {

"lang": "groovy",

"file": "test-add-tags",

"params": {

"new_tag":"tag1"

}

}

}

::: tip 外置脚本里面的语法放在内置脚本中的话,结果是不一样的, 内置中会把数组的 json 串当成字符串操作,如下

"_source": {

"num": 1,

"tags": "[xx, tag1]tag2"

}

:::

用脚本删除文档

脚本做的事情:当 num 等于指定值的时候,就删除,否则不做操作

test-delete-document.groovy

ctx.op = ctx._source.num == count ? 'delete' : 'none'

POST /test_index/test_type/11/_update

{

"script": {

"lang": "groovy",

"file": "test-delete-document",

"params": {

"count": 1

}

}

}

::: tip 注意 count 的值类型,如果写成 “1” 的话,是不会被匹配的 :::

upsert 操作

什么是 upsert ? 可以理解为 document 存在就更新,不存在则插入

刚刚把 id=11 的 document 删除了,现在直接更新操作,会报错

POST /test_index/test_type/11/_update

{

"doc": {

"num": 1

}

}

------ 响应

{

"error": {

"root_cause": [

{

"type": "document_missing_exception",

"reason": "[test_type][11]: document missing",

"index_uuid": "g4RJx2v8TXK95LdwlhRx5A",

"shard": "0",

"index": "test_index"

}

],

"type": "document_missing_exception",

"reason": "[test_type][11]: document missing",

"index_uuid": "g4RJx2v8TXK95LdwlhRx5A",

"shard": "0",

"index": "test_index"

},

"status": 404

}

使用脚本实现:如果指定的 document 不存在,就执行 upsert 中的初始化操作;如果指定的 document 存在,就执行 doc 或者 script 指定的 partial update 操作

POST /test_index/test_type/11/_update

{

"script" : "ctx._source.num+=1",

"upsert": {

"num": 0,

"tags": []

}

}

可以执行两次该操作,查看内容。

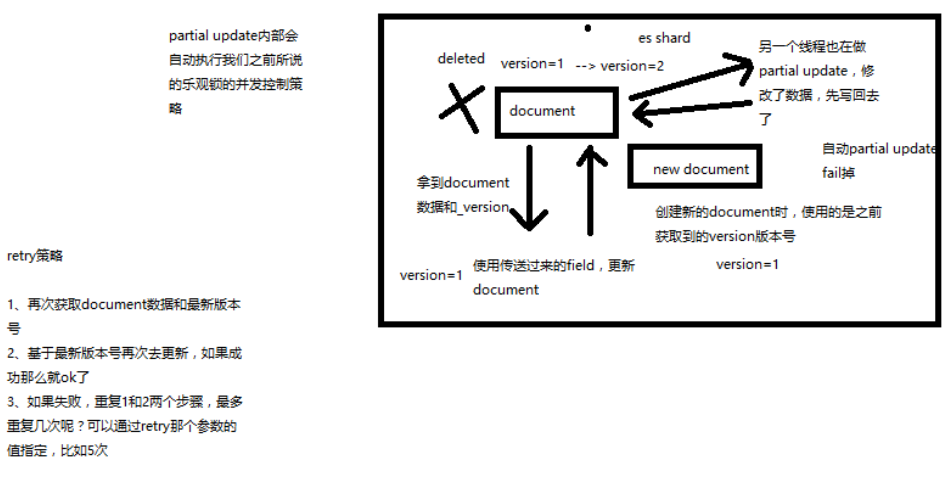

图解乐观锁并发控制原理与操作

- partial update 内置乐观锁并发控制

-

retry_on_conflict

retry 策略大致如下:

- 再次获取 document 数据和最新版本

- 基于最新版本号再次去更新

重试的次数为指定的次数,次数用完,还更新不了就失败了

_version

POST /test_index/test_type/11/_update?retry_on_conflict=2

{

"doc": {

"num" : 2

}

}

mget 批量查询 API

批量查询的好处

就是一条一条的查询,比如说要查询 100条 数据,那么就要发送 100次 网络请求,这个开销还是很大的

如果进行批量查询的话,查询 100条 数据,就只要发送 1次 网络请求,网络请求的性能开销缩减 100倍

不同 index 下

GET /_mget

{

"docs" : [

{

"_index" : "test_index",

"_type" : "test_type",

"_id" : 10

},

{

"_index" : "test_index",

"_type" : "test_type",

"_id" : 11

}

]

}

------ 响应

{

"docs": [

{

"_index": "test_index",

"_type": "test_type",

"_id": "10",

"_version": 2,

"found": true,

"_source": {

"test_field1": "test1",

"test_field2": "updated test2"

}

},

{

"_index": "test_index",

"_type": "test_type",

"_id": "11",

"_version": 3,

"found": true,

"_source": {

"num": 2,

"tags": []

}

}

]

}

是同一个 index 下

GET /test_index/_mget

{

"docs" : [

{

"_type" : "test_type",

"_id" : 10

},

{

"_type" : "test_type",

"_id" : 11

}

]

}

这里可以看出来了,在 api url 中是公共的,那么相同 type 下就可以这样写

GET /test_index/test_type/_mget

{

"docs" : [

{

"_id" : 10

},

{

"_id" : 11

}

]

}

但是这个可以简化成

GET /test_index/test_type/_mget

{

"ids":[10,11]

}

mget 的重要性

可以说 mget 是很重要的,一般来说,在进行查询的时候,如果一次性要查询多条数据的话,那么一定要用 batch批量操作的 api

尽可能减少网络开销次数,可能可以将性能提升数倍,甚至数十倍,非常非常之重要

bulk 批量增删改

什么是 bulk?

简单说:就在提供了一个批量传递操作的入口,语法和各自的差不多

每一个操作要两个 json 串,语法如下:

{"action": {"metadata"}}

{"data"}

举例,比如你现在要创建一个文档,放 bulk 里面,看起来会是这样子的:

{"index": {"_index": "test_index", "_type", "test_type", "_id": "1"}} // 唯一定位信息

{"test_field1": "test1", "test_field2": "test2"} // doc 文档内容

有哪些类型的操作可以执行呢?

- delete:删除一个文档,只要 1个 json 串就可以了

- create:

PUT /index/type/id/_create,强制创建/存在则报错 - index:普通的put操作,可以是创建文档,也可以是全量替换文档

- update:执行的 partial update 操作

:::tip bulk api 对 json 的语法,有严格的要求,每个 json 串不能换行,只能放一行,同时一个 json 串和一个 json 串之间,必须有一个换行;如果换行的话就会报错

{

"error": {

"root_cause": [

{

"type": "json_parse_exception",

"reason": "Unexpected end-of-input within/between Object entries\n at [Source: org.elasticsearch.transport.netty4.ByteBufStreamInput@2b0a4adc; line: 2, column: 40]"

}

],

"type": "json_parse_exception",

"reason": "Unexpected end-of-input within/between Object entries\n at [Source: org.elasticsearch.transport.netty4.ByteBufStreamInput@2b0a4adc; line: 2, column: 40]"

},

"status": 500

}

:::

演练

POST /_bulk

{ "delete": { "_index": "test_index", "_type": "test_type", "_id": "3" }}

{ "create": { "_index": "test_index", "_type": "test_type", "_id": "12" }}

{ "test_field": "test12" }

{ "index": { "_index": "test_index", "_type": "test_type", "_id": "2" }}

{ "test_field": "replaced test2" }

{ "update": { "_index": "test_index", "_type": "test_type", "_id": "1", "_retry_on_conflict" : 3} }

{ "doc" : {"test_field2" : "bulk test1"} }

响应

{

"took": 471,

"errors": true,

"items": [

{

"delete": {

"found": false,

"_index": "test_index",

"_type": "test_type",

"_id": "3",

"_version": 1,

"result": "not_found",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"status": 404

}

},

{

"create": {

"_index": "test_index",

"_type": "test_type",

"_id": "12",

"_version": 1,

"result": "created",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"created": true,

"status": 201

}

},

{

"index": {

"_index": "test_index",

"_type": "test_type",

"_id": "2",

"_version": 1,

"result": "created",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"created": true,

"status": 201

}

},

{

"update": {

"_index": "test_index",

"_type": "test_type",

"_id": "1",

"status": 404,

"error": {

"type": "document_missing_exception",

"reason": "[test_type][1]: document missing",

"index_uuid": "g4RJx2v8TXK95LdwlhRx5A",

"shard": "2",

"index": "test_index"

}

}

}

]

}

简写与 mget 类似

POST /test_index/_bulk

{ "delete": { "_type": "test_type", "_id": "3" }}

{ "create": { "_type": "test_type", "_id": "12" }}

{ "test_field": "test12" }

{ "index": { "_type": "test_type" }}

{ "test_field": "auto-generate id test" }

{ "index": { "_type": "test_type", "_id": "2" }}

{ "test_field": "replaced test2" }

{ "update": { "_type": "test_type", "_id": "1", "_retry_on_conflict" : 3} }

{ "doc" : {"test_field2" : "bulk test1"} }

POST /test_index/test_type/_bulk

{ "delete": { "_id": "3" }}

{ "create": { "_id": "12" }}

{ "test_field": "test12" }

{ "index": { }}

{ "test_field": "auto-generate id test" }

{ "index": { "_id": "2" }}

{ "test_field": "replaced test2" }

{ "update": { "_id": "1", "_retry_on_conflict" : 3} }

{ "doc" : {"test_field2" : "bulk test1"} }

bulk size 最佳大小

bulk request 会加载到内存里,如果太大的话,性能反而会下降,因此需要反复尝试一个最佳的 bulk size。一般从 1000~5000 条数据开始,尝试逐渐增加。另外,如果看大小的话,最好是在 5~15MB 之间。

阶段总结 & 什么是 distributed document store

阶段性总结

- 01~08讲:快速入门了一下,最基本的原理,最基本的操作

- 09~13讲:在入门之后,对 ES 的分布式的基本原理,进行了相对深入一些的剖析

- 14~27讲:围绕着 document 这个东西,进行操作,进行讲解和分析

什么是 distributed document store

到目前为止,你觉得你在学什么东西,给大家一个直观的感觉,好像已经知道了 es 是分布式的,包括一些基本的原理,然后花了不少时间在学习 document 本身相关的操作,增删改查。一句话点出来,给大家归纳总结一下,其实我们应该思考一下,es 的一个最最核心的功能,已经被我们相对完整的讲完了。

Elasticsearch 在跑起来以后,其实起到的第一个最核心的功能,就是一个分布式的文档数据存储系统。ES 是分布式的。文档数据存储系统。文档数据,存储系统。

- 文档数据:es 可以存储和操作 json 文档类型的数据,而且这也是 es 的核心数据结构。

-

存储系统:es 可以对 json 文档类型的数据进行存储,查询,创建,更新,删除,等等操作。

其实已经起到了一个什么样的效果呢?其实 ES 满足了这些功能,就可以说已经是一个 NoSQL 的存储系统了。

围绕着 document 在操作,其实就是把 es 当成了一个 NoSQL 存储引擎,一个可以存储文档类型数据的存储系统,在操作里面的 document。

es 可以作为一个分布式的文档存储系统,所以说,我们的应用系统,是不是就可以基于这个概念,去进行相关的应用程序的开发了。

什么类型的应用程序呢?

- 数据量较大,es 的分布式本质,可以帮助你快速进行扩容,承载大量数据

- 数据结构灵活多变,随时可能会变化,而且数据结构之间的关系,非常复杂,如果我们用传统数据库,那是不是很坑,因为要面临大量的表

- 对数据的相关操作,较为简单,比如就是一些简单的增删改查,用我们之前讲解的那些 document 操作就可以搞定

- NoSQL 数据库,适用的也是类似于上面的这种场景

举个例子,比如说像一些网站系统,或者是普通的电商系统,博客系统,面向对象概念比较复杂,但是作为终端网站来说,没什么太复杂的功能,就是一些简单的 CRUD 操作,而且数据量可能还比较大。这个时候选用 ES 这种 NoSQL 型的数据存储,比传统的复杂的功能务必强大的支持 SQL 的关系型数据库,更加合适一些。无论是性能,还是吞吐量,可能都会更好。

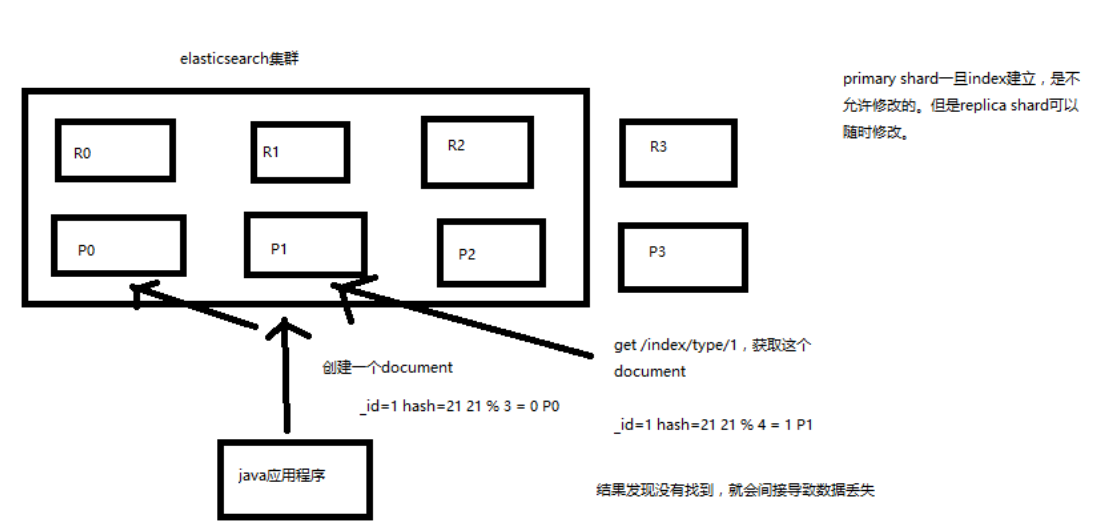

深度图解剖析 document 数据路由原理

什么是数据路由?

我们知道,一个 index 的数据会被分为多片,每片都在一个 shard 中, 所以一个 document ,只能存在于一个 shard 中

当客户端创建 document 的时候,es 此时就需要决定这个 document 存放在哪一个 shard 上。

这个过程,就称之为 docum routing (数据路由)

路由算法

- shard = hash(routing) % number_of_primary_shards

- routing =

_idor custom routing value

举个例子,一个 index 有3个 primary shard,P0,P1,P2

每次增删改查一个 document 的时候,都会带过来一个 routing number,

默认就是这个 document 的 _id(可能是手动指定,也可能是自动生成)

routing = _id,假设_id=1- hash(1) % 3 = 0; 假设 hash 值为 6

手动指定 routing

默认的 routing 就是 _id

也可以在发送请求的时候,手动指定一个 routing value,比如说 put /index/type/id?routing=user_id

手动指定 routing value 是很有用的,可以保证说,某一类 document 一定被路由到一个 shard 上去, 那么在后续进行应用级别的负载均衡,以及提升批量读取的性能的时候,是很有帮助的

primary shard 数量不可变的谜底

路由算法限制,更改之后,那么就有部分旧数据的路由错误

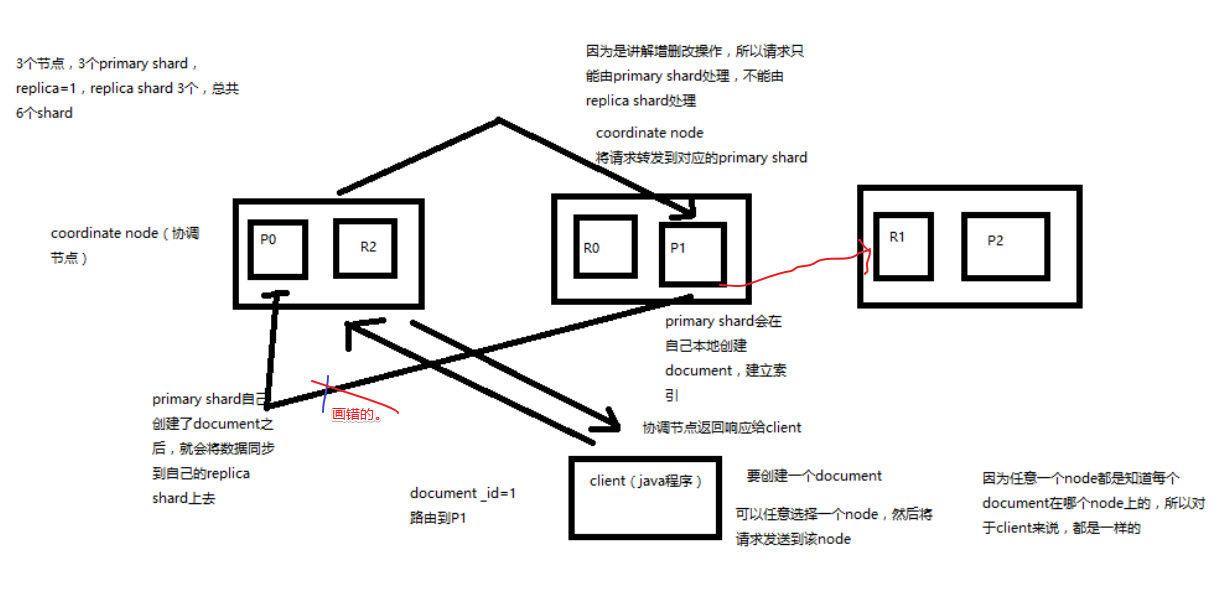

document 增删改内部原理图解揭秘

- 客户端选择一个 node 发送请求过去,这个 node 就是 coordinating node(协调节点)

- coordinating node,对 document 进行路由,将请求转发给对应的 node(有primary shard)

- 实际的 node 上的 primary shard 处理请求,然后将数据同步到 replica node

- coordinating node,如果发现 primary node 和所有 replica node 都搞定之后,就返回响应结果给客户端

::: warning 疑问 有一个知识点可能没有说到,3个 primary shard,这 3个 shard 的数据是怎么协调的呢?

这里的解密感觉还是很初级的解密 :::

图解写一致性原理以及 quorum 机制深入剖析

consistency 写一致性

我们在发送任何一个增删改操作的时候,比如说 put /index/type/id,

都可以带上一个 consistency 参数,指明我们想要的写一致性是什么?

put /index/type/id?consistency=quorum

有三个可选

-

one(primary shard)

要求我们这个写操作,只要有一个 primary shard 是 active 活跃可用的,就可以执行

-

all(all shard)

要求我们这个写操作,必须所有的 primary shard 和 replica shard 都是活跃的,才可以执行这个写操作

-

quorum(default)

默认的值,要求所有的 shard中,必须是大部分的 shard 都是活跃的,可用的,才可以执行这个写操作

quorum 机制

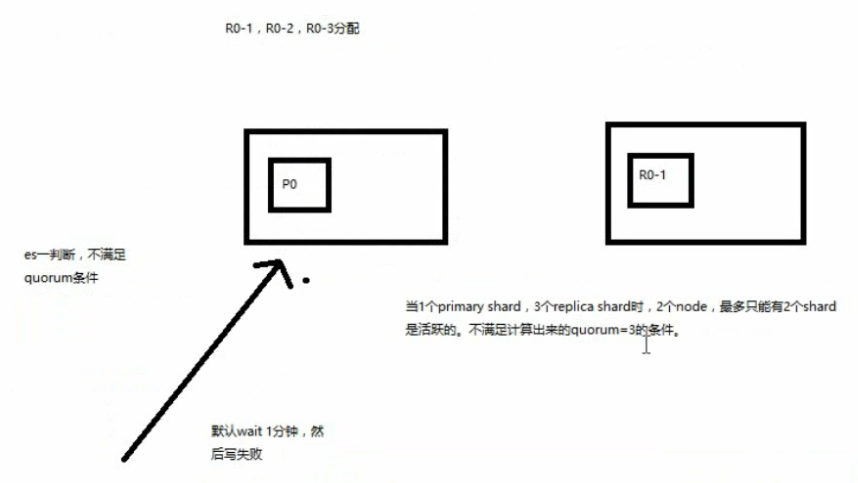

写之前必须确保大多数 shard 都可用,当 number_of_replicas>1 时才生效

计算公式:quorum = int( (primary + number_of_replicas) / 2 ) + 1,

举个例子:3个 primary shard,number_of_replicas=1,总共有 3 + 3 * 1 = 6个 shard

quorum = int( (3 + 1) / 2 ) + 1 = 3

所以,要求 6个 shard中至少有 3个shard 是 active 状态的,才可以执行这个写操作

如果节点数少于quorum数量,可能导致quorum不齐全,进而导致无法执行任何写操作

3个 primary shard,replica=1,要求至少 3个 shard 是 active,3个 shard 按照之前学习的 shard&replica机制,必须在不同的节点上,如果说只有 2台 机器的话,是不是有可能出现说,3个 shard 都没法分配齐全,此时就可能会出现写操作无法执行的情况

es 提供了一种特殊的处理场景,就是说当 number_of_replicas>1 时才生效,因为假如说,你就一个 primary shard,replica=1,此时就 2个 shard

(1 + 1 / 2) + 1 = 2,要求必须有 2个 shard 是活跃的,但是可能就 1个 node,此时就 1个 shard是活跃的,如果你不特殊处理的话,导致我们的单节点集群就无法工作

::: warning 疑问 p 和 r 不能在相同机器上。但是 r 和 r 也不能吗? p 和 p 可以再同一台机器上,现在是单节点,可以查看到他的健康状态 有 9个 p 被分配了,但是只有 3 个索引,也就是说一台机器上可以存在相同的 p ?

经过测试:在同一台机器上启动两个 es 实例,9 个 pri 和 9 个 rep,都可以被完全分配,集群状态变为 green

GET _cat/health?v

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

1546783226 22:00:26 elasticsearch green 2 2 18 9 0 0 0 0 - 100.0%

GET _cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open ecommerce ZpGp7bIBQBaZFk9SYmbJVQ 5 1 4 0 44.5kb 22.2kb

green open test_index g4RJx2v8TXK95LdwlhRx5A 3 1 8 0 56.5kb 28.2kb

green open .kibana id1SV_oGSjyGosKxeJApww 1 1 1 0 6.3kb 3.1kb

:::

document 查询内部原理图解揭秘

- 客户端发送请求到任意一个 node,成为 coordinate node

-

coordinate node 对 document 进行路由,将请求转发到对应的 node

此时会使用 round-robin 随机轮询算法,在 primary shard 以及其所有 replica 中随机选择一个,让读请求负载均衡

- 接收请求的 node 返回 document 给 coordinate node

- coordinate node 返回 document 给客户端

特殊情况:

document 如果还在建立索引过程中,可能只有 primary shard 有,任何一个 replica shard 都没有, 此时可能会导致无法读取到 document,但是 document 完成索引建立之后,primary shard 和 replica shard 就都有了

::: warning 疑问 对于这种情况没有处理么?在 mysql 的一些读写分离应用中,就会出现这种情况,

master 写入后,slave 还没有来得及同步,这个时候流量被转发到 slave 的时候无法获取到数据

一般的做法是:强制走 master;那么对于 es 来说这种场景怎么办? :::

bulk 奇特 json 与性能揭秘

bulk api 奇特的 json 格式复习,详细请查阅 bulk 批量增删改

{"action": {"meta"}}\n

{"data"}\n

{"action": {"meta"}}\n

{"data"}\n

bulk 中的每个操作都可能要转发到不同的 node 的 shard 去执行

如果采用标准的 json 格式

[{

"action": {

},

"data": {

}

}]

如果采用以上可随意换行的语法,整个可读性非常棒,读起来很爽,es 拿到那种标准格式的 json 串以后,要按照下述流程去进行处理:

- 将 json 数组解析为 JSONArray 对象,这个时候,整个数据,就会在内存中出现一份一模一样的拷贝,一份数据是 json 文本,一份数据是 JSONArray 对象

- 解析 json 数组里的每个 json,对每个请求中的 document 进行路由

- 为路由到同一个 shard 上的多个请求,创建一个请求数组

- 将这个请求数组序列化

- 将序列化后的请求数组发送到对应的节点上去

因为无法方便的将 action 分离出来,所以需要耗费更多时间去解析成对象,再提取,那么就会耗费更多内存,更多的 jvm gc 开销

我们之前提到过 bulk size 最佳大小的那个问题,一般建议说在几千条那样,然后大小在 10MB 左右, 所以说,可怕的事情来了。假设说现在 100个 bulk 请求发送到了一个节点上去,然后每个请求是 10MB,100个 请求,就是 1000MB = 1GB, 然后每个请求的 json 都 copy 一份为 jsonarray 对象,此时内存中的占用就会翻倍,就会占用 2GB 的内存,甚至还不止。 因为弄成 jsonarray 之后,还可能会多搞一些其他的数据结构,2GB+ 的内存占用。

占用更多的内存可能就会积压其他请求的内存使用量,比如说最重要的搜索请求,分析请求,等等,此时就可能会导致其他请求的性能急速下降 另外的话,占用内存更多,就会导致 java 虚拟机的垃圾回收次数更多,跟频繁,每次要回收的垃圾对象更多, 耗费的时间更多,导致 es 的 java 虚拟机停止工作线程的时间更多

那么采用奇特的格式呢?

- 不用将其转换为 json 对象,不会出现内存中的相同数据的拷贝,直接按照换行符切割 json

- 对每两个一组的 json,读取 meta,进行 document 路由

- 直接将对应的 json 发送到 node 上去

这里最大的优势可能就在于,不需要解析 doc 承载数据更多的情况了, 按行读取的话,由于 bulk 的 meta 数据较为简单,或许都不用解析成 json 对象,就能通过正则提取到 meta 信息

最大的优势在于,不需要将 json 数组解析为一个 JSONArray 对象,形成一份大数据的拷贝,浪费内存空间,尽可能地保证性能

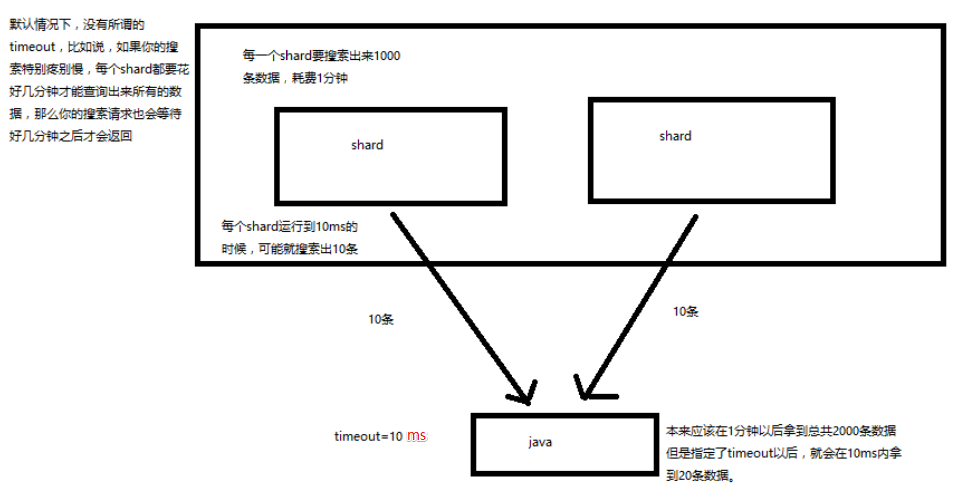

search 结果深入解析(timeout 机制揭秘)

- 我们如果发出一个搜索请求的话,会拿到一堆搜索结果,本节课,我们来讲解一下,这个搜索结果里的各种数据,都代表了什么含义

- 我们来讲解一下,搜索的 timeout 机制,底层的原理,画图讲解

搜索结果返回字段含义

GET /_search

-------------- 响应

{

"took": 4,

"timed_out": false,

"_shards": {

"total": 9,

"successful": 9,

"failed": 0

},

"hits": {

"total": 13,

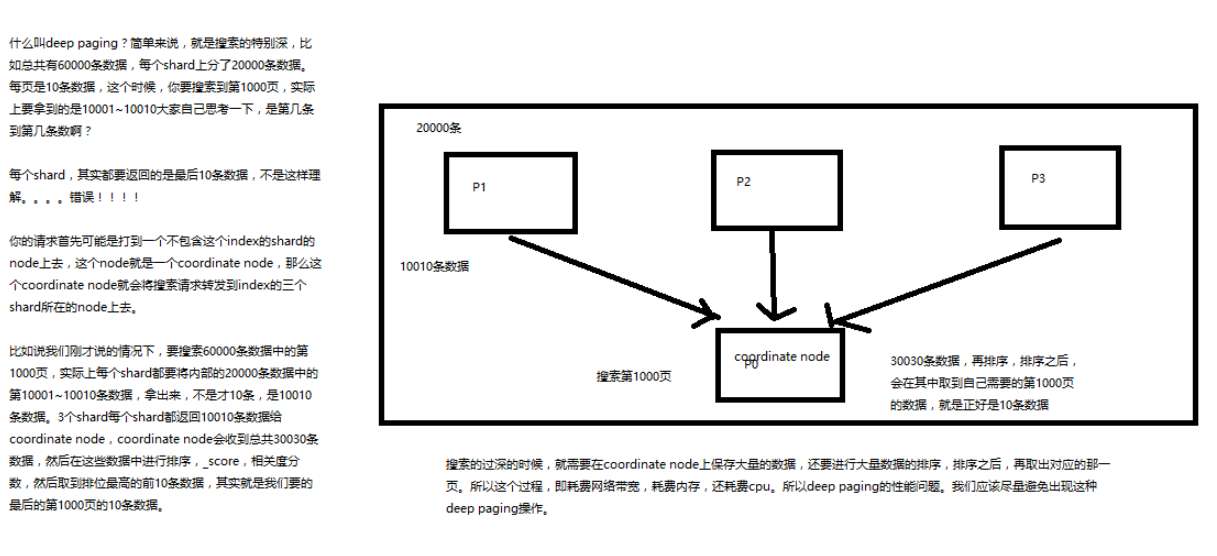

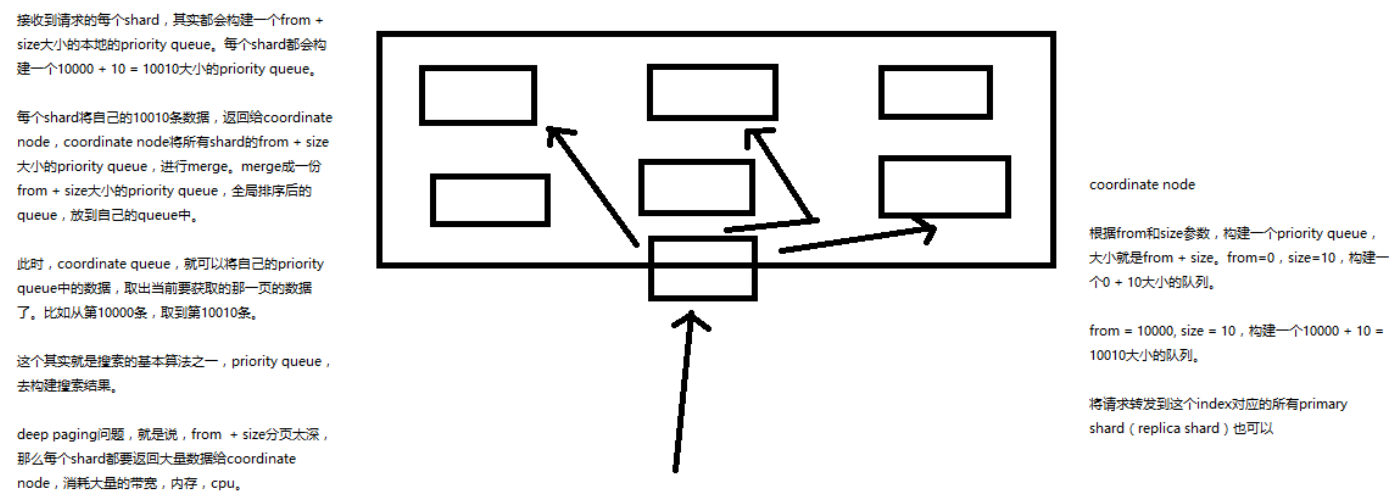

"max_score": 1,